ARM et TSMC mettent le cap sur le 7 nm

ARM et TSMC ont signé un partenariat pluriannuel pour mettre au point un processus de gravure de puces en 7 nm FinFET. Aucune échéance n'est annoncée, mais il ne faut pas attendre une mise en œuvre à grande échelle avant 2018.

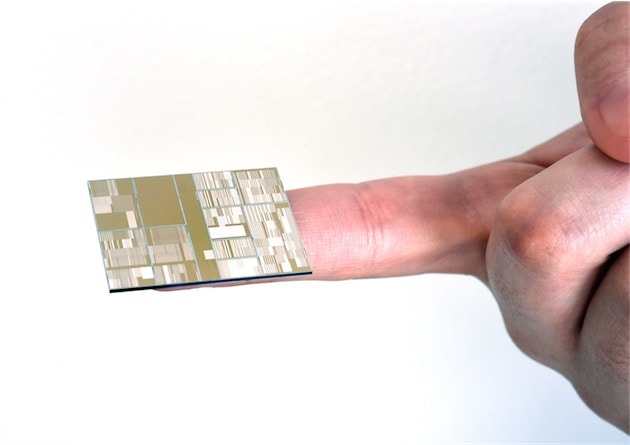

IBM, avec l'aide de Samsung et GlobalFoundries, entre autres, a produit l'été dernier la première puce en 7 nm. Une prouesse, car le silicium, le matériau de base habituel, n'est pas adapté à une gravure inférieure à 10 nm. IBM et ses partenaires ont ajouté un élément chimique, le germanium, et conçu un processus de lithographie EUV ultra précise.

À l'heure actuelle, les processeurs sont gravés en 14 nm maximum. L'A9 des derniers terminaux iOS est un peu particulier, car il est produit par deux fondeurs qui ne sont pas au même niveau : TSMC le fabrique en 16 nm, quand Samsung le fait 14 nm, un peu plus petit donc.

Pour l'iPhone 7, il se dit que TSMC a remporté le contrat grâce à sa gravure en 10 nm, sur laquelle Samsung ne pourrait pas s'aligner immédiatement. La rumeur est à prendre avec précaution, les bruits de couloir sur les fabricants de puces sont souvent inconstants.

À croire qu'ils ont plus d'intel-ligence la bas !

Mais que fait le géant ? Serait-il "outside" ?

@minitoine :

Maintenant je vais prier pour que tu ne passe pas au résumé de la semaine avec une blague aussi facile que celle ci...

Rooh, c'est méchant !

J'ai cherché pourtant... mais pas trouvé mieux. :'(

Cool du germanium ! Par contre, le prix va piquer...

J'en ai plein mon balcon...

Non pas cool, car c'est valable en labo, pas en production commercialement exploitable et ca le sera probablement jamais.

La limite effective du silicium c'est 18 nm, pour descendre en dessous il faut ruser pour un resultat de plus en plus insignifiant voire négatif (compenser les effets quantiques consomme de l'energie et du temps de calcul, donc complique l'architecture et ralentit le fonctionnement effectif).

Viser les 10nm alors que les 14nm n'apporte rien de tangible et surtout n'arrive pas a se stabiliser est un non sens.

On le voit avec Intel qui n'arrive pas a se sortir de ses problèmes de production avec le 14nm. L'architecture du x86 étant beaucoup plus alambiquée et inutilement compliquée qui celle d'ARM, le symptôme se voit plus, mais cela veut pas dire que l'architecture ARM va miraculeusement profiter de la gravure sous les 18nm... les problèmes sont les mêmes.

Ce qui sauve ARM c'est l'efficacité de l'architecture et sa souplesse. Mais si la puissance progresse de manière incomparable par rapport au x86 qui fait du surplace depuis plus de 5 ans, c'est uniquement grâce au travail sur l'architecture, pas grâce a la gravure.

NVidia a d'ailleurs demontré qu'en optimisant l'architecture et en restant sur la meme gravure il etait possible de doubler l'efficacité énergétique! Et la on parle de gravure au-dessus des 28nm!

Donc les gros progrès a venir sont du coté de l'optimisation de l'architecture ARM, et on voit qu'avec le passage au 64bit, il y a beaucoup a faire, surtout si on compare Qualcomm a Apple.

Apres, la route est bouchée, puisque la limite du silicium est deja atteinte et que les alternatives ne sont pas commercialement exploitables...

ouais, et pour améliorer l'architecture et augmenter le nombre de transistors, qui permettent donc aux processeurs d'être de plus en plus puissants, il faut graver plus fin.

C'est assez logique finalement.

Ce n'est pas une bonne nouvelle car le germanium est bien plus rare que le silicium.

Maintenant que les limites physiques des processeurs sont atteintes, il serait grand temps de se lancer dans l'optimisation logicielle, comme avec Metal ou Vulkan, Wayland, etc...

@nicolas :

Le germanium a été utilisé l'an dernier pour le premier prototype... Qui dit qu'il vont l'utiliser quand la production à grande échelle va véritablement commencer en 2018-2019 ?

@nicolas

+1000

Va falloir former les developpeurs a l'optimisation, mais il va deja falloir produire des OS optimisé.

actuelement on voit la multiplication des machines virtuelles a plusieurs niveau, meme dans le processeur, si on considere le x86 qui est en fait un emulateur de code x86 tournant sur des moteurs RISC...

Programmer en java c'est bien beau, mais on reste sur une machine virutelle qui tourne sur une machine virtuelle.

Pire encore avec les interpreteurs comme PHP ou Javascript qui sont censer faire tourner des serveurs.

Lorsque on s'interresse un minimum au type d'architecture du proceseur, on apprend que les processeurs RISC (donc ARM) sont tres sensibles a l'efficacité du compilateur. Donc un programme, optimisé et ecrit dans un langage favorisant la compilation (donc fortement typé, explicite et fortement structuré) va pouvoir augementer fortement la puissance de calcul tout en reduisant la consommmation.

Ensuite il y a tout l'aspect local qui va devoir etre optimise. Dépendre de ressources externes, donc accès réseaux, est une source d'inefficacité majeure. Va donc falloir aller dans la direction inverse d'aujourd'hui et repenser le développement en totalite.

@mrleblanc101

Parce que je vois mal une entreprise dépenser des millions en R&D pour concevoir des prototypes fonctionnels avec des matériaux bien spécifiques et en enlever un (le principal), pour le remplacer par quoi ? As-tu réfléchis un peu ?

Merci pour l'article!

Samsung est capable de sortir un processeur à 7nm avec IBM mais incapable d'égaler son concurrent à 10nm?

Construire un prototype à un prix inaccessible sans compter les déchets, et produire a cout accessible et à grande échelle ce n'est pas la même chose.

C est fou ce qu' on fait avec des géraniums ??

Dommage que certains soient si fatalistes quant au fait que nous ayons atteints les limites en matière de gravure et de performance.

Je pense qu'il y a encore un peu de chemin à faire et que le futur passe par une nouvelle conception du CPU et vers la maîtrise de l'ordinateur quantique.

La technologie étant un éternelle marche en avant, je suis un optimiste qui pense que dans 10 ans nos smartphone actuels paraîtront préhistoriques d'un point de vue puissance et que les meilleurs CPU seront des antiquités.

Parfois quand je regarde en 10 ans le bond graphique en matière de jeux vidéo je me dis que dans 10 ans le photo réalisme sera la norme.