Google détaille le fonctionnement du zoom haute résolution des Pixel 3

Les Pixel 3 de Google sont pleins de nouveautés pour la photo, avec plusieurs fonctions qui repoussent les limites de la photographie informatisée. Dans le lot, il y a notamment un zoom haute résolution (« Super Res Zoom » en anglais), un zoom numérique de bien meilleure qualité et qui peut même rivaliser avec un zoom optique d’après son concepteur. Les premiers tests montrent que ce n’est pas tout à fait le cas, mais que la qualité est en net progrès par rapport à ce que le Pixel 2 pouvait offrir.

Google revient sur cette fonction avec un article technique qui détaille le fonctionnement du zoom haute résolution. Le géant de la recherche a aussi publié une galerie d’exemples, avec des photos produites par des Pixel 3 et sans aucune retouche, pour donner une meilleure idée de ce que l’on peut attendre de cette nouveauté.

Pour améliorer les photos prises avec le Pixel 3 de manière générale, et pour améliorer le zoom en particulier, Google compte sur les mouvements du capteur pour enrichir l’image. Pour bien comprendre, il faut faire un détour par la composition du capteur lui-même. Les pixels ne savent pas distinguer la couleur, leur rôle à la base est uniquement de capter la lumière. Pour obtenir une image colorée, on ajoute donc un filtre devant les pixels avec les trois couleurs de base en informatique : rouge, bleu et vert.

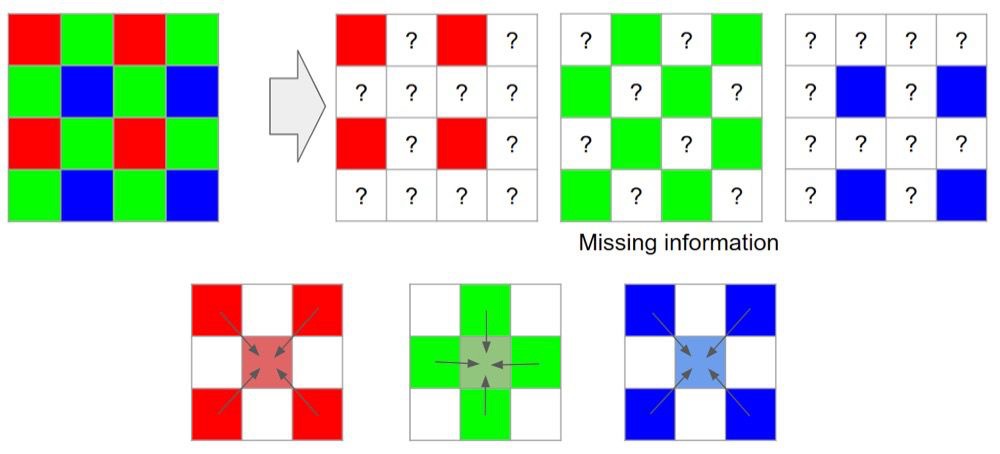

Chaque pixel du capteur est associé à l’une de ces couleurs, mais pas de façon égale. Pour chaque carré de quatre pixels, il y a un pixel rouge, un bleu et deux verts. Pourquoi deux fois plus de vert ? Parce que l’œil humain est nettement plus sensible à cette couleur, et il faut davantage de précision pour avoir un rendu plus réaliste. Dans tous les cas, le résultat pour chaque couleur est une grille à trous : il manque un pixel sur deux pour le vert, et trois pixels sur quatre pour le rouge et le bleu. Cette information manquante doit être reconstituée pour produire l’image finale, c’est ce que l’on appelle dans le jargon le dématriçage (« demoisaicing » en anglais).

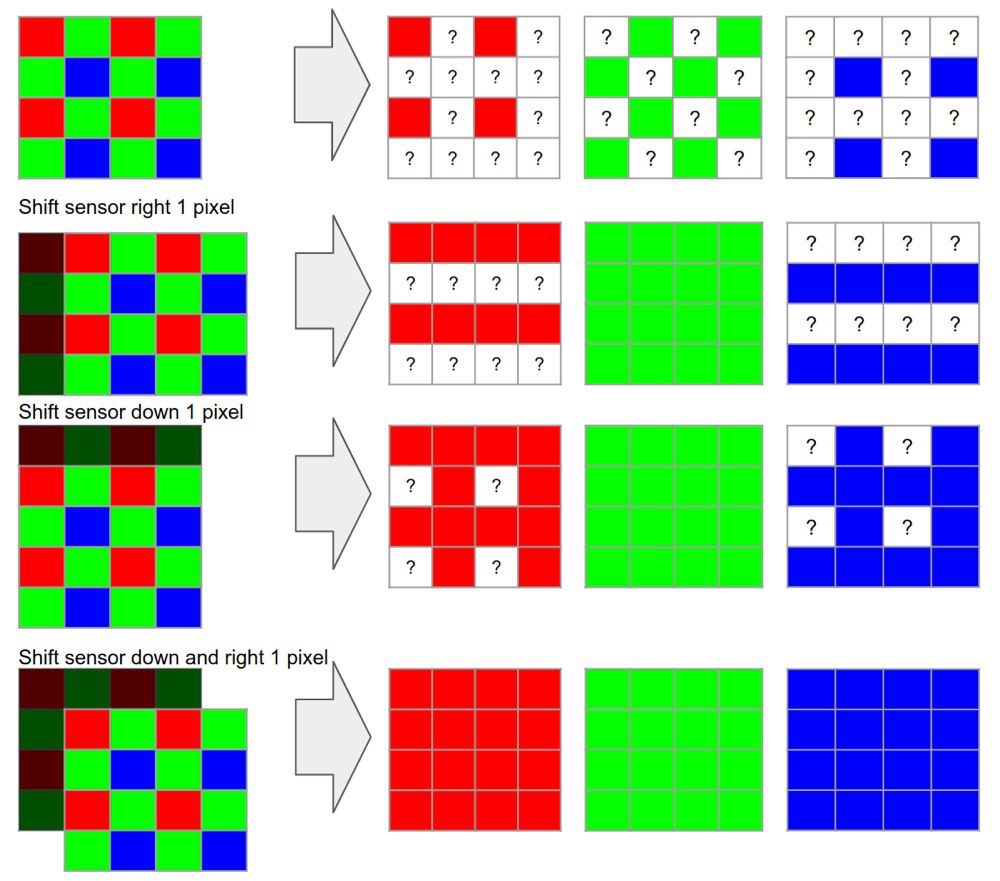

Même si les algorithmes, aidés par l’intelligence artificielle, sont devenus très malins, cette étape de remplissage implique nécessairement une perte de qualité. Les Pixel 3 évitent totalement le dématriçage en faisant bouger leur capteur, de manière à ce que la grille soit remplie sans algorithme. L’idée est très simple sur le papier : en déplaçant la grille au moins trois fois, on peut obtenir une information complète pour les trois couleurs, sans interpolation.

Une idée toute simple en théorie, mais si elle reste si rare jusqu’ici1, c’est qu’elle est très difficile à mettre en œuvre en pratique. Surtout dans le cadre d’un smartphone, où l’utilisation est majoritairement à bout de bras et sans équipement additionnel. Google liste tous les problèmes qui se posent à la mise en œuvre de cette solution et qui ont été réglés par des ajustements des algorithmes utilisés par les deux Pixel 3.

Le zoom étant composé de plusieurs photos prises successivement et réunies en un seul cliché, il y a plusieurs problèmes qui se posent. Il y en a un qui est évident : si le sujet pris en photo bouge, il faut assembler la photo en évitant des images fantômes et un effet de flou. Pour cela, Google choisit une image de référence dans le lot qui peut intégrer jusqu’à quinze clichés, et toutes les autres sont alignées en fonction de celle-ci.

D’autres défis se sont posés pendant le développement de la fonction. Ces images prises rapidement présentent beaucoup de grain, puisque le temps d’exposition est très court, et il faut le gérer pour éviter d’avoir une photo toute granuleuse à l’arrivée. Il a fallu aussi gérer les mouvements transparents, par exemple de la fumée, ou de l’eau qui bouge. Pour obtenir un résultat plus naturel, Google détecte sur l’image s’il y a des bordures artificielles, comme un panneau ou un mur, et l’algorithme utilise ces éléments comme points de repère pour l’assemblage final.

Par défaut, Google utilise les mouvements du smartphone lui-même lors de la prise. Même si vous tenez fermement l’appareil, le simple fait d’appuyer sur l’écran pour prendre une photo doit suffire à faire bouger le capteur suffisamment dans toutes les directions. Mais vous pouvez aussi poser votre Pixel 3 sur un trépied, ou même simplement sur une table ou contre une fenêtre. Il est alors trop stable pour que les mouvements naturels suffisent, et c’est alors que le stabilisateur optique intervient et fait trembler légèrement le capteur. Ce qui peut se voir lors de la prise :

Si le sujet vous intéresse, vous trouverez encore davantage d’informations techniques dans l’article de Google. L’entreprise liste aussi quelques contraintes du zoom haute résolution, notamment le fait qu’il ne s’active qu’à partir d’un zoom 1,2 fois pour des raisons de performances. Ou alors qu’il est automatiquement désactivé si vous l’utilisez sur un sujet en mouvement trop rapide, les algorithmes d’alignement ne pouvant alors plus faire leur travail.

Google précise enfin que le rendu sera meilleur à un niveau de zoom raisonnable. Les Pixel 3 sont censés concurrencer un zoom optique 2 fois, c'est-à-dire ce que proposent les iPhone équipés d’un téléobjectif au dos. Au-delà, la qualité restera dégradée, ce que les tests ont aussi montré, même si on peut s’attendre à des progrès par rapport à ce que le Pixel 2 pouvait offrir.

-

Google est le premier à l’utiliser sur un smartphone, mais c’est une méthode qui a déjà fait ses preuves en astronomie et aussi dans quelques reflex haut de gamme. ↩︎

Hâte de voir les résultats lorsque l'update sera disponible

« Dans tous les cas, le résultat pour chaque couleur est une grille à trous : il manque un pixel sur deux pour le vert, et un sur quatre pour le rouge et le bleu. »

Ne serait ce pas plutôt 3 sur 4 pour le rouge et le bleu ?

@Kelbogamin

Tout à fait, je me suis emmêle les pinceaux. Je corrige de ce pas.

Ca existe déjà sur le a7r3, pour une fois l’industrie de la photo a de l’avance

@iJoke

Oui, mais comme je le disais dans le papier précédent sur la photo, ce mode nécessite un trépied et une pose de quelques secondes. Et un sujet parfaitement immobile aussi.

En gros, c’est bien pour des paysages, de l’architecture, ce genre de choses.

Impressionant, et avec un seul objectif.

Apple peut aller se rhabiller

@IPICH

Trop gros, passera pas

@hautelfe

Je ne fais qu'un simple constat même si j'adore Apple ils chient clairement dans la colle avec leur appareil photo qui demande soit-disant 800 personnes.

c'est un peu le meme procédé utilisé dans l'application "hydra" qui propose aussi un zoom haute def a l'aide des micro mouvement.

https://itunes.apple.com/fr/app/hydra/id947824428?mt=8

==> • Le mode Zoom(*) met en oeuvre la technique de super résolution en temps réel pour recréer les pixels manquants à partir des mouvements de la main, appliquant une échelle x2/x4/x8 pour afficher plus de détails que la technique de zoom numérique classique.

Faut décidément que j’arrête de lire les articles sur le Pixel 3... Il me fait de plus en plus de l’œil.

C’est Samsung qui sera le meilleur avec ces 4 objectifs.

Intéressant !

Petite question: je suis tombé sur ce brevet de Apple publié en 2015 avec un principe qui serait identique: https://9to5mac.com/2015/04/02/iphone-camera-resolution/?pushup=1

http://appft.uspto.gov/netacgi/nph-Parser?Sect1=PTO2&Sect2=HITOFF&u=%2Fnetahtml%2FPTO%2Fsearch-adv.html&r=2&p=1&f=G&l=50&d=PG01&S1=%28348%2F208.5.CCLS.+AND+20140508.PD.%29&OS=ccl/348/208.5+and+pd/5/8/2014&RS=%28CCL/348/208.5+AND+PD/20140508%29

Quelle est la différence entre les 2 méthodes ?

@alban210

Un brevet déposé en 2012 alors que le procédé est utilisé en astrophotographie numérique depuis bien plus longtemps (Drizzle du Hubble !).

Je doute fort de la validité de ce brevet, vu le "prior art".

Par ailleurs, y'a l'exploitation du mouvement naturel et non pas contrôlé, et ça c'est pas dans le brevet d'Apple... mais figure déjà dans les techniques numériques inventées et utilisées pour (re)construire les images d'espace profond du Hubble...

La mitrise du hard et soft d'apple fait des mervei... c'est pas apple, ah... Bon bah ça sera en super feature dans 1 ou 2 itérations majeures d'ios, le temps que la photocopieuse fasse son oeuvre. :)

Peut être l’équipe de Zürich en vacances ?

Pas mal. Ils ont adapté le checkerboard rendering que la PS4 a inauguré.

@romgiotti

Non, le checkerboard rendering fait de l'extrapolation pour obtenir une résolution supérieure à celle réellement calculée, tandis qu'ici il s'agit de faire du sur-échantillonnage pour construire une résolution supérieure à celle native du capteur en accumulant comme il faut des données captées plusieurs fois dans des conditions différentes. La capture a lieu plusieurs fois mais à chaque fois à 100% de sa capacité, alors que dans le checkerboard rendering le calcul, lui, n'a lieu qu'à 50% de sa capacité, l'objectif étant in fine de réduire les calculs sans que cela se voit *trop*.

Il va quand même y avoir pas mal de contrainte au final. C’est un choix. Vu les tests, bon, mais dans la vraie pratique pour ceux qui font vraiment de la photo, ça sera plus compliqué. L’approche est intéressante toutefois et on voit facilement pourquoi Apple ne s’est pas orienté vers cela.

@Nesus

Bah en fait dans la vrai pratique ceux qui font de la photo le font déjà avec leur dslr en assemblant le tout sous toshop. Je suis justement tombé sur une vidéo je crois que c’était du studio de poche sur le sujet il y a peu

Bordel ils foutent quoi à Lausanne !!?

L’équipe de Zürich en vacances ?

J’ai appris des trucs ! Thanks !

Vous utilisez le mot pixel au lieu de photosite.

Un photosite est ce qui constitue le capteur, et reçoit la lumière rouge bleue ou verte.

Le pixel est ce qui constitue l'image et qui est créé à partir de plusieurs photosites rouge bleu vert.

C’est ce genre d’article combiné avec les commentaires qui fait que j’aime ces interactions entre savoirs et savoirs-faire ! Merci à tous !