Les Pixel 3 repoussent les limites de la photographie informatisée

Avec les Pixel, Google a réussi à proposer des smartphones parmi les meilleurs en photographie, si ce n’est les meilleurs. Un an après sa sortie, certains journalistes considèrent toujours que le Pixel 2 fait mieux que les iPhone XS, ce qui montre bien au minimum que l’entreprise a réussi à proposer un excellent module photo. On attendait beaucoup du Pixel 3, son successeur présenté cette semaine et Google le savait. Que ce soit pendant sa conférence de présentation ou même sur son site, l’appareil photo est mis en avant en premier, ce qui trahit l’importance de cette fonction.

Contrairement à tous ses concurrents maintenant, Google a opté pour un appareil unique au dos. Là où certains en installent quatre différents, la firme de Mountain View conserve son approche originale, avec un seul objectif et un seul capteur au dos. Le matériel est d’excellente qualité, mais la vraie différence vient du logiciel. Le Pixel 3 compte encore plus que son prédécesseur sur la photographie informatisée (« computational photography ») et c’est sans doute le smartphone qui va le plus loin dans le domaine, bien plus loin que les iPhone de 2018.

Le site spécialisé DPReview a obtenu, outre une galerie de photos, quelques informations techniques exclusives de la part d’ingénieurs Google qui ont travaillé sur le Pixel 3. Ils apportent plusieurs idées nouvelles dans l’univers des smartphones et repoussent encore les limites de ce que la photographie assistée par ordinateur peut faire… on fait le point.

Les mouvements pour améliorer la qualité des photos

Plusieurs nouveautés introduites avec le Pixel 3 dépendent en fait d’une même idée. Comme l’iPhone XS Max, les smartphones de Google prennent en fait plusieurs photos à chaque fois que l’on appuie sur le bouton pour en prendre une. C’est ce qui a permis au géant de la recherche d’introduire le mode HDR+ il y a quelques années, équivalent du Smart HDR d’Apple, et c’est ce qui permet d’obtenir des photos bien équilibrées, même avec des conditions lumineuses difficiles.

Google a conservé ce principe général sur le Pixel 3 et l’a amélioré sur deux points importants. Déjà, le smartphone prend plus de photos à chaque fois, jusqu’à quinze images qui sont combinées en une seule. C’est cinq de plus que le Pixel 2 et six de plus que l’iPhone XS qui compose chaque image de neuf clichés différents au mieux.

La vraie différence toutefois est ailleurs. Le Pixel 3 ne se contente pas de prendre quinze photos en variant les paramètres d’ouverture et de sensibilité, le smartphone profite des mouvements naturels de votre main pour améliorer la qualité de l’image en augmentant le nombre de pixels. Son capteur de 12 mégapixels ne peut pas produire une photo de 20 mégapixels, mais en bougeant légèrement l’appareil photo, on peut gagner des pixels sur tous les côtés. Par ailleurs, cela améliore la qualité en apportant la même quantité de lumière, non seulement à chaque pixel, mais aussi à chaque sous-pixel rouge, vert et bleu qui compose le pixel complet1.

Même si le smartphone est parfaitement immobile, cette technique est utilisée en sollicitant la stabilisation optique. Normalement, la stabilisation permet de compenser un mouvement involontaire en imprimant au capteur un mouvement inverse. Google a détourné cette fonction pour faire varier très légèrement la position du capteur et ainsi obtenir le même résultat : une photo avec une définition légèrement plus élevée, et surtout une meilleure qualité d’image.

Cette technique n’est pas nouvelle et quelques appareils photo la proposent, comme le Sony A7R III ou encore le Pentax K-1. Néanmoins, le Pixel 3 est le premier smartphone à le faire et surtout, Google a amélioré l’idée de base à tel point que la fonction est constamment utilisée. Sur les appareils dédiés, c’était une option, voire un mode spécifique, et il était lié à des contraintes importantes pour obtenir un résultat correct. Du côté de Sony, par exemple, le système consiste en quatre prises différentes, avec une attente d’une seconde entre chaque, ce qui rend l’utilisation d’un pied obligatoire.

Rien de tel sur un smartphone, on s’en doute bien. Google combine nettement plus d’images et tout ce travail est effectué en une fraction de seconde seulement et à chaque fois que vous prenez une photo. Il n’y a pas un mode spécifique à activer et il n’y a aucune condition particulière, il est disponible en permanence pour améliorer chaque photo prise avec le Pixel 3.

Mais en utilisant cette fonction, l’équipe en charge de la photo a trouvé de nouvelles idées pour enrichir l’appareil photo du Pixel 3. En particulier, deux nouvelles fonctions dépendent directement de ce capteur en mouvement : le zoom haute résolution et le mode « Night Sight » pour les photos de nuit. Le premier permet d’obtenir un zoom numérique de bien meilleure qualité, équivalent d’après Google à un zoom 2x optique.

Un zoom 2x, c’est exactement ce que propose Apple avec le téléobjectif de ses iPhone. Le Pixel 3 pourra aller bien au-delà de ce niveau, mais les meilleurs résultats seront obtenus sur les plus petits niveaux de zoom. Sur l’exemple ci-dessus, on voit bien quelques défauts, notamment le long du bras du modèle, mais l’image reste mieux définie qu’un zoom numérique traditionnel. DPReview ajoute que des exemples montrés par les ingénieurs de Google étaient plus impressionnants encore, il faudra voir ce que cela donne à l’usage.

L’autre fonction ne sera pas disponible au lancement du Pixel 3, mais sera activée par une mise à jour ultérieure. Night Sight sera un mode spécifique, qui ne sera activé qu’à la demande et qui nécessite des conditions particulières. Contrairement au fonctionnement normal de l’appareil photo, il nécessite en effet de maintenir le smartphone immobile pendant une seconde ou deux après avoir déclenché.

Tout cela, pour un résultat spectaculaire : des photos dans le noir qui ressemblent à des photos prises en journée. Pour parvenir à un tel résultat, Google exploite la capacité du smartphone à prendre jusqu’à 15 photos pour en créer une seule, mais aussi sur les mouvements du capteur. La différence avec le mode HDR+ qui est actif en permanence, c’est que chaque cliché intermédiaire est pris plus lentement, jusqu’à un tiers de seconde à chaque fois. En les combinant toutes, le Pixel 3 obtient le résultat d’une pose de 5 secondes, mais condensée en un temps nettement plus réduit.

Les algorithmes de fusion de Google se chargent d’éliminer le flou, mais aussi d’éviter les effets d’images fantômes sur les sujets en mouvement. Le rendu final n’est pas forcément naturel, dans le sens où la photo sera plus lumineuse que ce que l’œil humain peut apercevoir. Mais l’idée de l’entreprise, c’est d’offrir une option dans les situations si sombres où l’on ne sortait plus du tout un appareil photo auparavant.

Toute cette mécanique des photos combinées en une et du capteur qui se déplace n’est pas réservée aux JPEG. Le Pixel 3 est le premier smartphone de Google à proposer un mode RAW directement dans l’appareil photo de base. Et contrairement au mode RAW d’un iPhone XS, le rendu n’est pas radicalement différent entre les deux. La firme de Mountain View parle de « computational RAW » et c’est a priori une première dans l’industrie, et pas uniquement pour les smartphones.

Comme pour le JPEG, l’idée est de combiner jusqu’à quinze images en une seule photo et de l’enregistrer en DNG, un standard pour le RAW. Grâce à cet assemblage, Google a de grandes ambitions, puisqu’elle promet des RAW de la qualité d’un reflex équipé d’un capteur APS-C. Pour vous donner une idée, le capteur d’un iPhone XS mesure 40,6 mm², là où un capteur APS-C tourne autour de 350 mm².

Pour le dire autrement, Google a réussi à obtenir la qualité d’un appareil photo dédié avec un capteur de smartphone huit à dix fois plus petit. En tout cas, c’est ce que l’entreprise promet et évidemment, les reflex conservent de nombreux avantages, à commencer par une optique bien meilleure, mais il n’empêche que le Pixel 3 a bien progressé dans ce domaine. Et le smartphone a aussi des arguments à faire valoir, comme sa connexion cellulaire qui permet de partager immédiatement une image, ou encore la possibilité de stocker toutes les photos originales gratuitement sur Google Photos.

L’intelligence artificielle à la rescousse

Google a aussi amélioré les algorithmes d’apprentissage automatisé (« machine learning) qui sont également au cœur de l’appareil photo de son smartphone. Ils servaient déjà dans les Pixel précédents, mais leur rôle est plus que jamais prépondérant dans le nouveau modèle. En particulier, le mode portrait repose plus largement sur l’intelligence artificielle pour distinguer les différents plans.

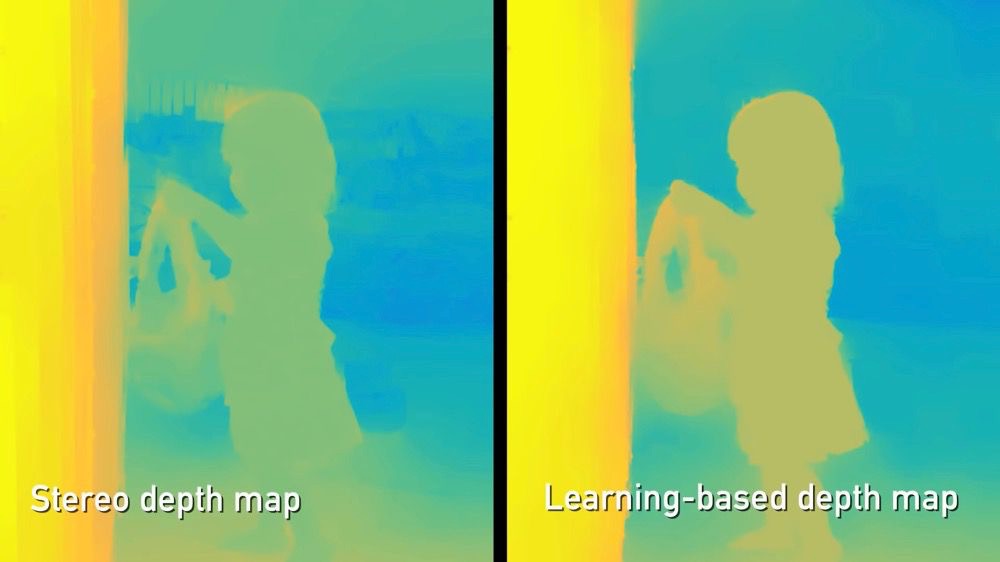

À la base, Google utilise une fonction de son capteur, qui présente des pixels légèrement décalés, pour obtenir une évaluation des distances. C’est ce qu’Apple et tous les autres constructeurs font avec deux appareils photos distincts, mais à une échelle qui ne permet pas d’obtenir naturellement un bon résultat. C’est pourquoi le calcul nécessaire est encore plus important sur les Pixel, et avec cette troisième génération, il se base aussi sur des modèles d’apprentissage pour améliorer le rendu.

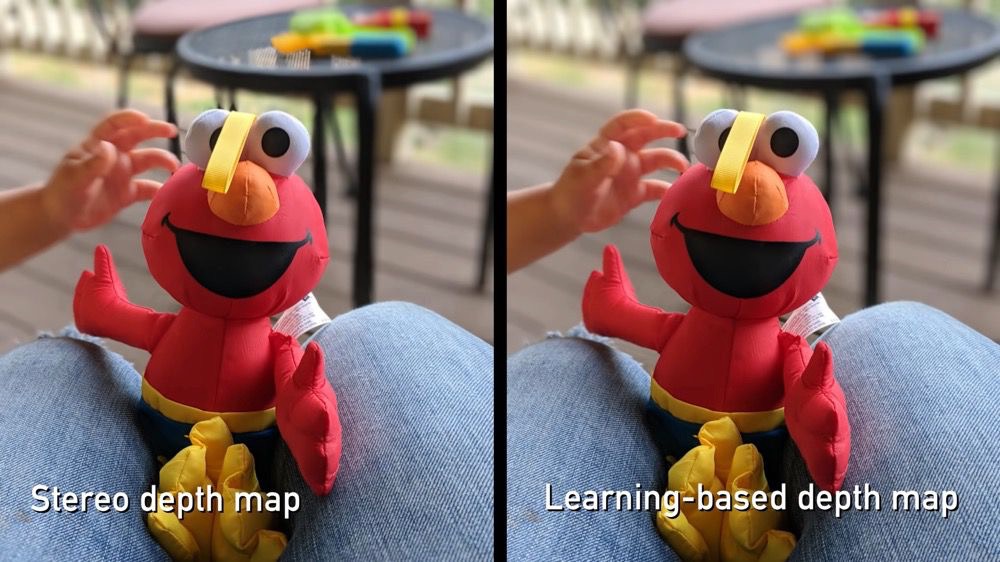

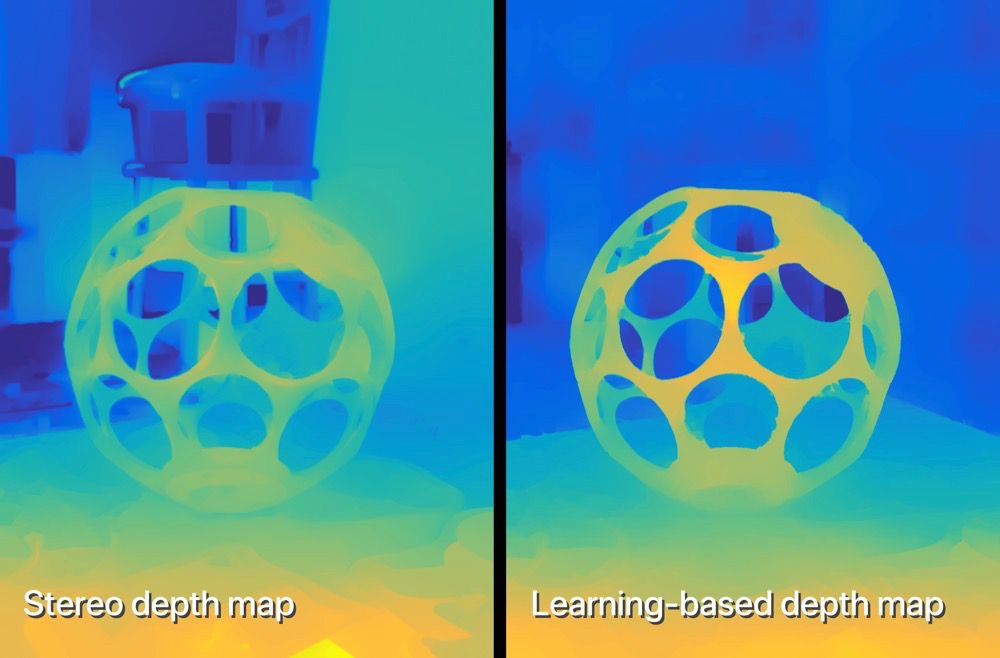

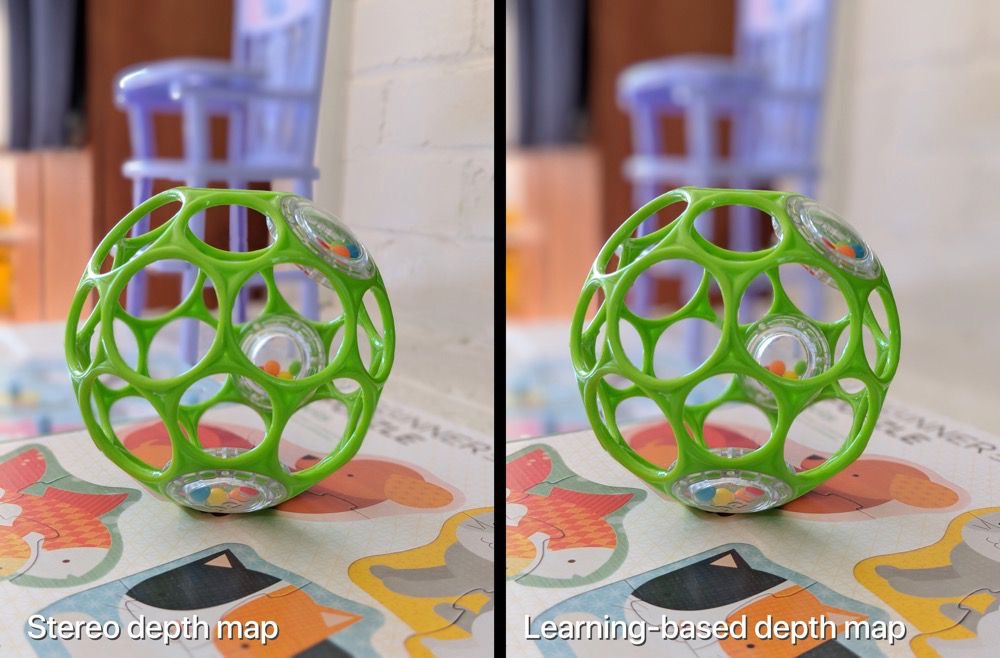

Prenez cet exemple donné par Google. Sur la gauche, vous avez un mode portrait effectué essentiellement à partir du décalage des pixels, avec une carte de profondeur basée sur la stéréoscopie. Sur la droite, le décalage sert toujours, mais il alimente un algorithme de détection qui a identifié le sujet et l’isole mieux de l’arrière-plan. Notez en particulier la barrière derrière l’enfant, elle est parfaitement floue avec l’intelligence artificielle, alors qu’elle est partiellement nette sur l’ancienne version.

Les algorithmes de Google détectent parfaitement les formes humaines, mais pas seulement. Cet exemple montre aussi que des progrès sont à attendre pour appliquer du flou uniformément sur l’arrière-plan derrière un objet, ou dans les trous entre premier et dernier plan. Notez la différence entre le bras de l’enfant et la cuisse, c’est totalement flou sur la version basée sur les nouveaux algorithmes, plus nette sur l’autre.

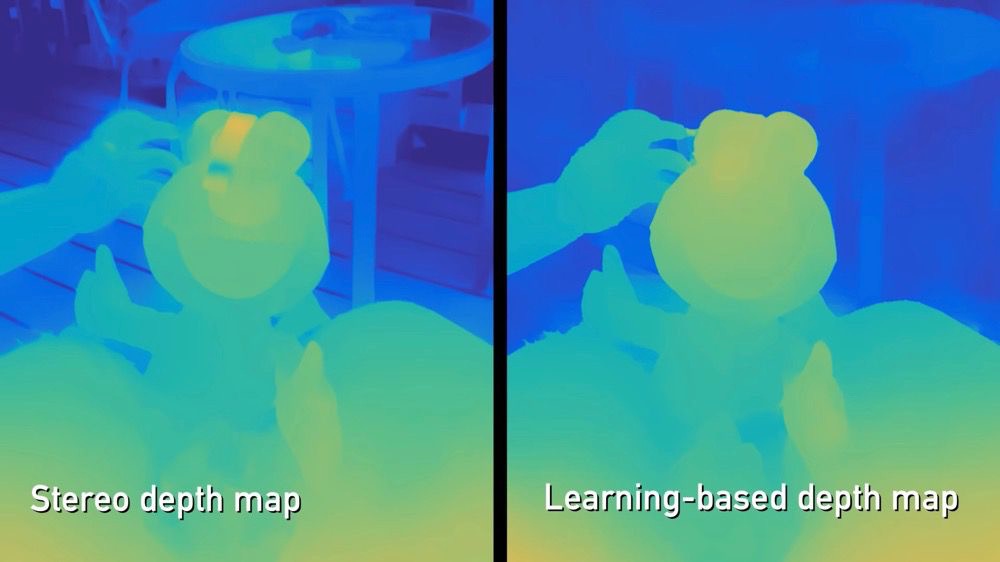

On pourrait dire qu’il s’agit toujours de formes humaines, mais ce dernier exemple devrait alors vous convaincre. C’est un sujet très complexe, puisque cet objet troué laisse voir l’arrière-plan, ce qui nécessite un détourage complexe. La version basée sur le décalage n’affiche pas un flou uniforme du fond, celle créée avec l’intelligence artificielle offre un rendu bien meilleur, plus proche de ce qu’un appareil photo dédié pourrait offrir.

Google a aussi repris l’idée de l’éclairage de portrait d’Apple, mais en l’utilisant un petit peu différemment. Pour rappel, l’idée est de simuler l’éclairage que l’on pourrait obtenir dans un studio sur les portraits. Avec les iPhone de 2017 et les suivants, on a quatre éclairages différents sur iOS et on peut passer de l’un à l’autre sur toutes les photos prises avec le mode portrait.

Sur le Pixel 3, il n’y a qu’un seul éclairage, mais il est appliqué systématiquement à tous les visages. Google nomme cette fonction « Synthetic Fill Flash », c'est-à-dire un flash artificiel chargé de « déboucher » les ombres ou de mettre en avant un visage pour un portrait. L’entreprise évoque l’équivalent généré par des algorithmes d’un réflecteur physique, utilisé par les photographes professionnels.

Dans ce cas, l’intelligence artificielle est utilisée pour distinguer les visages du reste — c’est le même mécanisme que pour le mode portrait — et pour modifier leur éclairage. Les traitements ajoutent un petit peu de luminosité pour simuler un flash sans avoir à utiliser le flash physique présent au dos du Pixel 3. Cela fonctionne aussi bien avec la caméra arrière, que les deux devant.

Ce même mécanisme sert aussi à une nouvelle fonction de stabilisation vidéo sur la caméra avant. Le Pixel 3 analyse le flux vidéo et détecte les visages sur chaque image, pour garder la mise au point sur lui, plutôt que l’arrière-plan ou un autre objet. Cette nouvelle stabilisation réduit la taille de la vidéo, mais elle permet apparemment d’obtenir un rendu beaucoup plus fluide.

Pour finir sur le chapitre de l’intelligence artificielle, notons qu’elle sert encore pour les photos de nuit avec le mode « Night Sight ». Google utilise ses algorithmes avancés pour la balance des blancs, puisqu’il n’y a plus assez de lumière pour un mode automatique traditionnel. Le Pixel 3 va essayer d’estimer la meilleure balance des blancs pour obtenir un rendu aussi réaliste que possible… il faudra voir ce que cela donnera en conditions réelles.

L’intelligence artificielle est au cœur de l’expérience et nous n’avons pas encore évoqué tous les cas de figure où elle est utilisée dans l’appareil photo du Pixel 3. La fonction « Meilleur cliché » qui suggère une meilleure photo dans la demi-seconde qui précède et qui suit la prise2 est basée entièrement sur des algorithmes chargés de vérifier si le sujet sourit, s’il ferme les yeux, etc. Même chose pour la mise au point intelligente, capable de suivre une personne en mouvement, ou même un objet, si vous le sélectionnez sur l’écran.

Les tests du Pixel 3 n’ont pas encore été publiés, nous ne savons pas encore ce que vaut cet appareil photo hors d’un environnement contrôlé par Google. Néanmoins, ces premiers éléments sont prometteurs et on voit que l’entreprise continue d’innover dans ce domaine. Apple a fait un grand pas en avant cette année en matière de photographie, mais ça ne sera peut-être pas suffisant pour tenir la distance…

-

Le Pixel 3 n’a plus besoin de passer par l’étape de dématriçage, ce qui améliore mécaniquement la qualité des images. ↩︎

-

Au passage, les ingénieurs de Google ont indiqué que la qualité de cette photo serait inférieure à l’originale, mais suffisamment bonne pour que la différence ne se voit pas. On verra si c’est bien le cas, mais on imagine/espère que la perte de qualité sera inférieure à celle que l’on connaît sur iOS, quand on change la photo principale d’une Live Photo. ↩︎

L’IA est l’avenir de la photo. C’est sûr ça qu’il faut miser, pas 18 capteurs...

@vksf1

Quand on s'appelle Huawei ou Nokia, c'est plus simple de multiplier les capteurs que de faire de la R&D sur le software. En revanche, c'est là que Google excelle et Apple devrait pouvoir suivre.

Google a vraiment les moyens de faire un smartphone qui cocherait toutes les cases aujourd'hui. Etonnant de les voir se prend les pieds dans le tapis sur des choses que tout le monde maîtrise plus ou moins : écran décevant sur le Pixel 2 XL, encoche et menton proéminent sur le 3 XL qui confèrent à la faute de goût...

En tout cas sur cette partie photo, les promesses sont d'autant plus impressionnantes que le hard n'a quasiment pas bougé...

@NestorK

Oui, Apple a deux capteurs et le résultat sur le mode portrait a l’air moins bon que Google avec un seul… Il faut vraiment bosser sur ce domaine

@vlsf1

Je préfère utiliser une optique qui fait le flou toute seule.

Plutôt que d’imiter de l’existant…

@Hasgarn

Jette ton smartphone alors... Que je sache tu n’a pas écrit ce message sur un parchemin...

Et un appareil photo créé aussi l’image avec son processeur.

@vlsf1

Pourquoi je jetterai mon smartphone qui sert à téléphoner ?

Et éventuellement prendre une photo de temps en temps…

Rien ne remplace une bonne optique. C’est pour ça que les processeurs d’appareils photos n’ont pas besoin de la puissance des smartphones.

@Hasgarn

Justement on va arriver à un stade (on n’y est pas encore) ou l’IA des téléphones leur permettra de faire des choses que les appareils photos ne peuvent pas faire. Et vice versa.

Le HDR peut donner une plage dynamique qu’on n’a que sur des appareils photos à 2000 euros...

@vlsf1

Ça reste de la Buckler ou du Canada Dry…

Mais tant mieux si les gens aiment la Buckler, je continuerai à fournir de la vraie bière pendant encore longtemps. Parce que détrompe toi, les smartphones ne vont pas rattraper les APN de sitôt : le passage à l’hybride de toutes les marques entérine le fait que la limite du miroir va disparaître : cela ouvre les portes aux très grandes ouvertures pour tout le monde. Il suffit de voir le magique RF 50mm f/1.2 de Canon et le 28-70 f/2. Plus que l’Eos R, c’est le parc optique naissant qui a laissé une sacré impression.

Ça, c’est inatteignable pour un smartphone en l’état et comme ça va devenir un norme sur les APN dans les 5 ans, les comparaisons vont continuer d’être faites.

Pour peu que les constructeurs se mettent à faire des processeurs plus puissants (ce qui ira nécessairement de paire avec de meilleurs batteries), les smartphones vont devoir se transformer en super calculateur pour rivaliser avec un effet analogique de cet acabit. Les progrès vont peut être fulgurant, mais comment les smartphones peuvent rivaliser avec les optiques f/1 ou f/0.95 qui sont à l’études en ce moment chez Nikon, Canon, Sigma…

Bon courage aux développeurs.

@Hasgarn

Je pense qu’il ne faut pas sous estimer les progres possible sur les smartphones dans les 2 ou 3 ans. Ça ne replacera pas un appareil photo mais les effets seront de plus en plus perfectionnés

@Hasgarn

Ca me rappelle le discours des photographes professionnels à l’époque de l’argentique qui méprisaient les premiers appareils digitaux à CMOS, jurant leur grand dieu, les lois de l’optique, que jamais au grand jamais, une gadget electronique ne pourrait remplacer leur 4x5 Hasselblat...

Aujourd’hui ils shootent tous en numérique et la ferment dans toutes les langues lorsque je leur renvoie leurs emails de l’époque.

Je travaille dans la pub depuis 1991. Je suis passé par la photogravure.

J’ai possédé le premier appareil photo numérique, le QuickTake 100, fruit d’une collaboration entre Apple et Sony.

Le manque de vision est de qui revient à chaque génération de technologie. Il est clair que l’AI va révolutionner la photo et permettre de franchir les barrières de l’optique. Reparlons en dans 10 ans.

@Brice21

Il y a des chances que grâce aux technologies les capteurs de smartphone n’ai rien à voir dans 10 ans comme tu dis. J’espère aussi que ça va arriver.

Peut-être que d’autre form factor de smartphone, comme les écrans souple, permettent aussi d’y loger un capteur plus gros.

Mais pour le moment le constat est tout autre.

@Brice

Je suis d'accord avec toi mais il faut souligner que les technologies des appareils dédiés évoluent aussi parallèlement. Et si les constructeurs décidaient d'intégrer l'IA dans leurs APN?

@EBLIS

Il n’ont pas la technologie, ni les “modèles” que Google a calculé à l’aide de farms de processeur TensorFlow sur des trillions de photos taggués bénévolement par les utilisateurs Google docilement. Pauvre japonais, ils sont condamnés à fournir les optiques, la nouvelle génération de photographie algorithmique va totalement leur échapper. Comme la rédaction de mode d’emploi compréhensibles :)

@ Brice21 :

On ne sait pas comment ça va évoluer mais il y a pleins de chemins : l'iso-invarience ou la double sensibilité à la prise de vue (en une fois) ou le HDR. Google a choisi l'option HDR avec reconstruction (très cool, on retrouve ça chez Olympus et Pentax) avec une super position de 15 prises de vue et du génie logiciel. C'est bien, mais il y a déjà la limitation du sujet impérativement fixe sinon c'est flou assuré et j'ai hâte de voir les gloubiboulgas de cheveux au vent :D

Bref, les travaux avancent mais je doute que la rafale soit l'avenir. C'est pas élégant et ça ne marche pas pour les cas (sport).

"Reparlons en dans 10 ans."

Oui, c'est à ce moment là qu'il faudra en reparler. Mais là et pour les 3 ou 4 prochaines années sachant que les APN vont intégrer des technos qu'on ne trouve pour l'instant que dans les smartphones (et encore c'est déjà transversal), pas sur de voir l'écart se réduire significativement. À moins d'une trouvaille d'exception.

"Il est clair que l’AI va révolutionner la photo et permettre de franchir les barrières de l’optique."

Euh… la photo passe nécessairement l'optique, quelque chose qui doit être vu. Je ne comprends pas bien comment on dépasse ce qui peut être vue ;)

Allez, peut être que les smartphones pourront un jour simuler le plénoptique mais… ça implique un paquet de truc.

"Il n’ont pas la technologie, ni les “modèles” que Google a calculé à l’aide de farms de processeur TensorFlow sur des trillions de photos taggués bénévolement par les utilisateurs Google docilement. Pauvre japonais, ils sont condamnés à fournir les optiques, la nouvelle génération de photographie algorithmique va totalement leur échapper. Comme la rédaction de mode d’emploi compréhensibles :)"

Sarcastique mais c'est très bien possible. Les Japonais resteront des billes en dev tant qu'il ne feront pas d'effort en anglais :D

Bien sûr, mais là, tu parles d'optiques qui coûtent ou coûteront plusieurs fois le prix d'un XS Max 512 Go … Bien sûr qu'avec un boitier à 3000€ et un sac avec 10 ou 15000 € de cailloux, un bon photographe fera de magnifiques photos mais dans pas mal de circonstances, le temps qu'il sorte son boitier, trouve et installe le bon objectif, le sujet aura disparu. Mais il aura les moyens de faire des clichés même pas envisageable avec un smartphone. Les deux sont complémentaires.

@ ziggyspider :

Tu parles de 2 choses très intéressantes : le prix et la disponibilité.

Le prix : un XS max coutent dans les 1300€. C'est déjà le prix d'un bon objectif. Si on parle du RF 28-70 de Canon qui coute 3200€ par là, il va couter 2,5 XS effectivement.

Mais il y a un détail, un objectif a une très longue durée de vie face à un smartphone. 10 ans contre 18 mois (moyenne). Réparti dans le temps et sans parler de rentabilité, le RF 28-70 coute 320€ par an là ou le XS coute 866€. Si tu ajoutes la rentabilité pour un pro, tu annules le coût pour le remplacer par du cash.

Donc, quand tu achètes du matos photos et surtout des optiques, c'est pour longtemps, jusqu'à 15 ans voir plus encore. Un smartphone ne va pas si loin.

La disponibilité : je ne sais pas si tu prends des photos avec un APN mais ça marche pas vraiment comme ça :)

Quand je sors faire de la photo, j'ai l'appareil en bandoulière et pas rangé, j'ai l'objectif monté pour la fonction que je recherche (grand angle pour l'archi, 35mm ou 50mm pour la photo de rue etc.). Donc, on est réactif et le matos est disponible. Un photographe sort souvent avec un objectif en tête (calembour mais c'est à prendre au sens littéral :D )

Dans le cas ou je n'ai pas mon APN, je sors mon smartphone bien sur. Et souvent même. Les plus beaux portraits de mes enfants, c'est avec mon iPhone. Parfois, je sais que je ne pourrais pas faire la photo que je veux (limitation du zoom ou autre) donc je ne fais rien, je me contente de regarder et d'apprécier (ça, c'est un truc que les gens ne savent plus faire).

Mais dans tous les cas, si je prends une photo de smartphone, je le prends la meilleure possible, sans fioriture, sans mode portrait, par exemple, jamais.

Pour info, j'ai sur mon site plusieurs photos culinaire prise au smartphone. S'il fallait une preuve qu'on peut être crédible en tant que pro avec une telle photo, je l'ai fait. C'était au Lumia 1020.

@vlsf1

"Justement on va arriver à un stade (on n’y est pas encore) ou l’IA des téléphones leur permettra de faire des choses que les appareils photos ne peuvent pas faire.

Sauf que la computational photography va aussi gagner les reflex, qui bénéficieront en plus d’un meilleur capteur.

@pat3

Est-ce que Canon et les autres arriveront à suivre Apple et Google ? Ou alors faudra mettre Android dans les appareils photo...

@Hasgarn

Personne n’a parlé de remplacer une bonne optique. Ça n’en reste pas moins intéressant que les smartphones fassent des progrès sur la question car quoi qu’en disent les puristes : ça reste l’apn qu’on a toujours sur soi.

@NestorK

Je suis d’accord avec toi

@NestorK

Ben l’effet portrait avec le bokeh, si c’est pas singer l’optique, c’est quoi ?

Après, il y a des tas de choses que la technologie permet avec les smartphones. Et c’est très bien qu’il y ait des vrais tentatives. Ça permet de faire évolué la photo au sens global.

Mais je ne vois pas comment les smartphones vont faire dans la course à l’imitation dans les années à venir.

@Hasgarn

Déjà, le bokeh, on y arrive pas qu'avec l'optique. C'est aussi une question de taille de capteur.

Mais encore une fois, où est le problème de simuler du bokeh ? Je trouve ça plutôt cool que nos smartphones nous permettent d'émuler des photos prise par un appareil 35 mm alors qu'ils mesurent quelques millimètres d'épaisseur et qu'ils tiennent dans une poche.

Après, personne te parle d'abandonner ton vieux 5D full frame avec son 85 qui ouvre à 1.4 ! Pour chaque outil, son usage.

Perso, je suis assez fan de ce que propose le mode portrait par exemple. C'est loin d'être parfait aujourd'hui mais on y viendra, c'est certain, surtout quand on voit à quelle vitesse les progrès sont faits.

@Hasgarn

"Rien ne remplace une bonne optique."

Google est en train de démontrer le contraire... :)

@fte

C’est pas encore tout à fait exact mais il faut être plutôt fermé d’esprit pour pas comprendre qu’à moyen terme c’est ce qui arrivera.

J’imagine que en 1990 les mecs qui faisait les maquettes de Monstres sur les films devaient dire « pffff, jamais un ordi n’aura le réalisme de nos maquettes, rêvez pas, on a encore du travail pour 100 ans !... »

@jean_claude_duss

Et c’est pas le cas. Je préfère les monstres animés avec des maquettes qu’avec des images de synthèse.

Je trouve que ça fait plus peur, que ça fous plus la trouille quand on sent que l’on peut toucher le monstre. Via un ordinateur c’est pas réel et ça se vois, rien que l’animation pas réaliste du tout...

@fte

Y’a clairement du progrès, c’est indéniable !

Mais…

La profondeur de champ, c’est pas ça. Les scories dans le traitement logiciel se voit encore.

Et surtout : à 15 photos par déclenchement, il y a intérêt à avoir un sujet immobile, TRÈS immobile. Toutes ses photos sont des photos test fournies par Google. Dans 2 mois, les gens qui auront le Pixel entre les mains seront déçu pensant que déclencher fera la photo et n’obtiendront pas ce résultat. C’est prometteur mais encore expérimental.

Et c’est là qu’une bonne optique qui fera le cliché en une seule fois, à une vitesse de 1/250 jusqu’à 1/1000 pour figer le mouvement grâce à son ouverture à un avantage pas encore ne serait-ce que chatouillé par les smartphones.

Google prouve qu’on peut sensiblement améliorer les clichés avec du traitement logiciel qu’on finira par retrouver dans les APN mais en compensant l’optique qui ne peut pas être trop volumineuse sur un smartphone.

@Hasgarn

"Mais…"

bien sur. C’est différent, pas de doute là dessus. Grand capteur et téléobjectif n’offrent pas le même rendu que grand angle et micro-capteur. La perspective est la même, mais ni l’angle de champ ni la profondeur de champ ne se ressemblent, évidemment.

Ce sont des représentations différentes. L’une n’est las intrinsèquement meilleure que l’autre.

@fte

On est d’accord ?

@vlsf1

Ça veut surtout dire qu'Apple enfume tout le monde avec leurs prix et le nombre de capteurs.

@vlsf1

Apple n’utilise qu’un seul objectif pour les portraits ainsi qu’on le verra avec les Xr. C’est un travail IA sur les profondeurs.

@vlsf1

Ça va malheureusement standardiser et lisser le tout, au détriment de l’originalité et de la spontanéité. On mettra des filtres pour avoir des photos floues ou mal exposées par nostalgie des photos de papa :)

@Seize

Au contraire ça ouvre des possibilités. Simuler l’effet d’un objectif à plusieurs centaines d’euros...

@vlsf1

Ca va surtout permettre de faire des tas de photos moches et faussement artistiques de gens qui ne s'y connaissent pas.?

Avec un reflex on apprend à utiliser l'appareil. Là, on touche le bouton ça prend la photo et ça détoure grossièrement pour faire un filtre flou parfois pas du tout cohérent avec la prise de vue.

@IPICH

On voit aussi des massacres avec des reflex...

@ipich

Si tu savais le nombre de personnes qui se disent photographes car ils ont des appareils haut de gamme et qui ne font qu'appuyer sur le déclencheur.

@EBLIS

Non mais ces gens-là ils ne comptent pas ils font n'importe quoi ahah

Je ne crois pas trop au photos fournies par les marques mais si c’est vraiment le cas ... les photos sont excellentes et ça montrerait bien qu’Apple est totalement dépassé niveau IA !

J’attends avec impatience les vrai tests...

@kiddsoso

Apple était déjà dépassé par le Pixel 2 niveau IA

Il y a déjà plein de vrais tests

C'est tout à votre honneur de reconnaître qu'Apple n'est pas l'alpha et l'omega… Cependant dans ces test, j'aimerais savoir ce que valent les appareils dédiés, reflex, actuels.

@Madalvée

Une ligne qui dit tout ce qu’il y a savoir sur les appareils photos : les optiques restent meilleurs.

Qu’importe le logiciel, mon iPhone ne me sortira jamais la qualité d’un portait au 70-200 f/2.8.

Et la taille du capteur aussi !

En citant ton 70-200 2.8 tu te contrains au matériel et oublies qu'on peut obtenir d'excellents portraits avec un 300, un 50, un 28 ou même un smartphone. Cette dispute qui existe entre smartphones et appareils photo classiques est en grande partie technologique, au bout du compte, l'émotion qu'on a devant une photo dépend en majeure partie du sujet et non de la qualité perçue.

@EBLIS

Tu déduis que je me ferme la porte alors que je parle d’une préférence.

Je fais des portraits au 16mm parce que l’environnement est important dans ce cas précis. Un pro dans son environnement de travail, par exemple.

Mais j’ai fait des supers portraits de mes enfants ce maitin avec mon iPhone ?

Le plus important est de savoir ce qu’on peut tirer de son matos.

Le cas 70-200 f/2.8 est pour mettre en avant le flou d’arrière plan.

Ça sent la punition pour les iPhones... on verra...

Incroyable les progrès réalisés ces derniers temps, grâce à l’IA.

C’est vrai que la qualité d’image est très bonne - pour des capteurs d’une si petite taille -.

Ça fait une bonne focale fixe que l’on balade partout et tout le temps sur soi!

IGEN on veut un test du pixel 3 svp svp svp .. et comparée à l’iPhone Xs aussi ça serais géniale .... de voir ça

@Aba7

C’est prévu, j’en recevrai un à sa sortie. J’attends depuis longtemps la possibilité de tester un Pixel alors maintenant qu’ils sont enfin officiellement en France !

Le jour où le pixel passe à deux capteurs, ça sera assez dingue !

@bidibout

Apple travaille pour son univers, et pense qu’une photo Apple est regardé systèmatiquement sur un écran Apple...

Grave erreur!

Pages