Aperçu de la fonction Texte en direct d’iOS 15

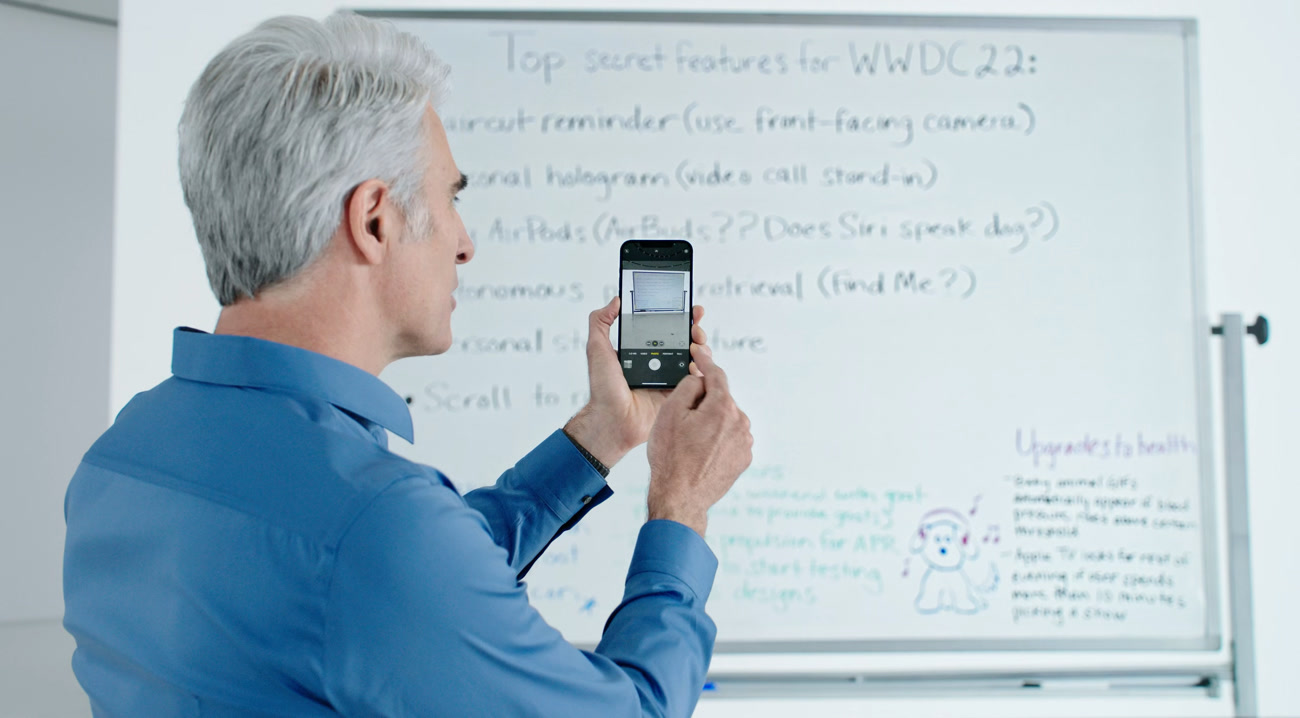

Avec « Texte en direct », Apple a placé son moteur de reconnaissance optique de caractères (OCR) maison au cœur d’iOS 15 et d’iPadOS 15. Grâce à cette nouvelle fonction, on peut pointer son smartphone ou sa tablette sur du texte pour le copier et le coller dans une autre app. Ou bien extraire le numéro de téléphone d’une carte de visite pour passer un coup de fil plus rapidement. Ou encore traduire à la volée un menu de restaurant dans une langue étrangère.

Toutes ces fonctions ne sont pas nouvelles, y compris sur iOS où des apps tierces les proposaient. Mais c’est la première fois qu’Apple les intègre dans son système. Que vaut le texte en direct d’iOS 15 et comment cela fonctionne-t-il ? Avant de le voir, il faut préciser une limite importante : cette nouveauté nécessite une puce Apple A12 au minimum1.

- Mise à jour le 27 juillet : macOS Monterey : Texte en direct est aussi compatible Intel

Au programme :

« Quand est-ce que l’iPhone va enfin exploiter son réseau de neurones sur puce ? »

Je crois qu’on a la réponse ! Bel article.

@FloMo

Dommage pour l A11 ….

@macbook60

Le premier vrai NPU d’Apple était clairement le A12 (faut voir comment ils avaient bourré le mou lors du Keynote sur cette puce … c’était presque la seule nouveauté de la soirée).

Celui de l’A11 était uniquement dédié à faceID pour avoir des performances acceptables sur un smartphone vendu une blinde à l’époque (iPhone X). D’ailleurs je me demande à quoi sert ce NPU dans l’iPhone 8 du coup.🙂

@romainB84

Effectivement y as un grand écart entre les deux

@macbook60

C’est sur! Même si P. Shiller avait bien appuyé le fait que l’A11 embarquait un NPU pendant le Keynote de 2017, mais il semblerait qu’il soit uniquement dédié à faceID 🙂.

@romainB84

C’est l’évolution lol même sans cette fonction pratique l’iPhone X reste un bon smartphone

@macbook60

Tout à fait 🙂

@macbook60

Ha ça. Techniquement, ça s’explique. Mais c’est dommage en effet.

C'est un repompage complet de Google Lens ou des fonctions de recherche dans Google Photos qui existent depuis des années. J'ai apprécié la conférence globalement mais cette partie m'a scié. Ceci dit, ce sont peut-être des fonctions sous licence.

@Ast2001

ah oui je ne connaissais pas google lens. Par contre pour google photos, c’est surtout la race des plantes ou animaux et la reconnaissance de texte dans le sphotos qui est nouveau.

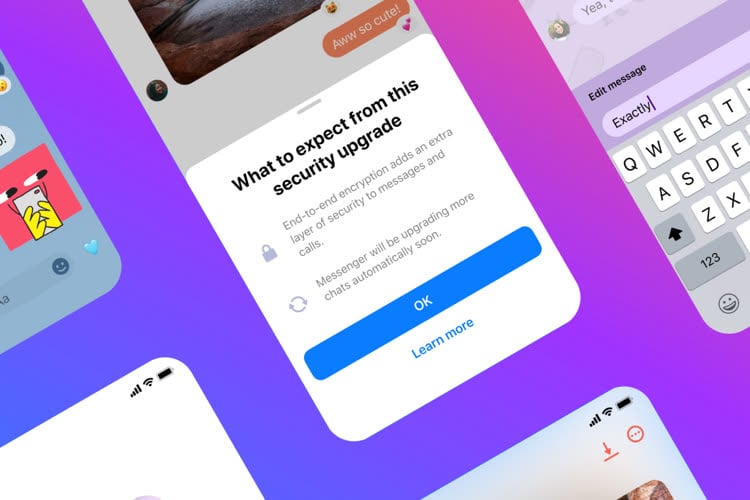

Par contre LA grande différence c’est que tout cela se fait en local, alors que sur google de souvenir ce n’est pas le cas.

@raoolito

Ca fait très longtemps que j’utilise Google Traduction et Office Lens, et cela demande une config très légère. J’avais un iPhone 6 lors de mon dernier voyage en république tchèque, et ca m’a bien aidé dans les restos ....

Bref Apple fait un remake et en plus il faut beaucoup plus de puissance que l’original ? Il y a des moments où il vaut mieux ne pas se gausser de certaines nouveautés ....

@Ast2001

« C'est un repompage complet de Google Lens ou des fonctions de recherche dans Google Photos qui existent depuis des années. »

Et?….

Parce que ça vient après, il ne devrait pas le mettre?

Le fait déjà qu’ils arrivent à le faire en local peut en outre justifier ce retard mais j’ai l’impression au vu de ton commentaire que la seule réponse que tu souhaites entendre sera « Apple c’est de la merde… ils sont en retard sur tout » ✊😉!!

Google Lens n'intègre un fonctionnement offline que depuis cette année.

Idem pour Google Photos : avant, ils utilisaient les données des utilisateurs stockées en ligne pour leurs recherches. Je ne sais pas si ça a changé.

Apple fait tout depuis l'appareil, sans connexion à internet.

D'un point de vue technologique, ce n'est pas la même chose.

Et surtout, c'est l'intégration à l'OS qui change la donne. Les APIs OCR étaient là depuis quelques temps déjà, même si elles ont clairement été améliorées.

Bizarrement je reçois les notifs 10 min après la publication des articles.. 🧐

Fonction très sexy et prometteuse

Ça c’est probablement l’une des annonces les plus sexys et enthousiasmantes de la WWDC, et oui, entre ça et Siri en local on voit enfin à quoi servent les réseaux neuronaux ! (Même si j’ai toujours du mal à comprendre exactement leur fonctionnement ^^’)

@quentinf33

Sauf si tu veux manger des fraises du coup 🤣

Ça risque de faire du mal aux applis de scanner si Apple a intégré son OCR directement dans « fichier ».

Beaucoup d’applications de scanner sont gratuites mais proposent comme fonction payante l’OCR. Si celle ci est native sur les pdf lus par l’iPhone … ça perd de son sens de l’acheter.

Oh wow, l’intégration au système semble excellente !

« La reconnaissance de texte fonctionne toujours sur ce texte inscrit sur une part de gâteau. Notez au passage le trait sous le numéro de téléphone, signe qu’iOS 15 l’a identifié et peut composer le numéro dans la foulée. »

On n’arrête pas le progrès !! On peut composer un numéro de téléphone directement depuis une part de gâteau maintenant ^^’ !

Il me reste une dernière question après cet « aperçu » très approfondi : quid des photos dans la bibliothèque iCloud ?

La fonction de reconnaissance de texte a l’air extraordinaire et le fait que le machine learning se fasse essentiellement en local est génial pour ma vie privée et la planète, mais quand on a 1037 Go de photos/vidéos dont une petite partie seulement sur l’appareil, que se passe-t-il ? Est-ce qu’il faut faire une croix dessus, est-ce qu’il faut télécharger, analyse et supprimer Go par Go, ou est-ce qu’Apple fait la même chose sur les serveurs iCloud ?

Et sinon, qu’en est-il des Macs ? Merci pour vos éclaircissements !

@Lu Canneberges

Non en fait c'est plus simple que cela : l'OCR se fait en live, dès que la photo charge. Cela fonctionne aussi comme ça dans Safari, dès qu'une image s'affiche dans le navigateur, iOS 15 analyse s'il y a du texte et lance son processeur de reconnaissance.

Apparemment, les puces neurones d'Apple sont si rapides que tout peut se faire en direct à la dernière minute. Problème réglé pour la photothèque iCloud !

Pour le Mac, j'ai totalement oublié d'en parler, mais toutes les fonctions d'analyse des photos à l'écran sont là aussi pour les Mac Apple Silicon. Donc ça marche dans Photos, Safari, Coup d'œil et les captures d'écran. Je vais ajouter l'info.

@nicolasf

merci pour le complément d'infos.

je comprends la détection instantanée (grâce au NPU) lorsque l'on charge la photo.

Par contre la question reste pertinente pour la "recherche de texte" depuis spotlight.

est ce que si l'on a activé "l'optimisation de stockage" de la photothèque iCloud, cela posera un problème pour faire une recherche d'un texte depuis spotlight?

Si j'ai une photo avec écrit "toto" dessus. Si je fais une recherche dans spotlight "toto". Est ce que si la photo n'est pas en local il sera capable de la retrouver?

@romainB84

@jul69

Hum, bonne question, je n’y avais pas pensé. 🤔

Je ne sais pas trop comment ça marche du coup, dans mon exemple toutes les photos sont trop vieilles pour être en local.

@nicolasf

Mais vu que la fonction recherche dans photos permet de rechercher du texte je pense quand même que tout ne se fait pas à la volée pour les très grosses photothèques et qu’il doit y avoir un système d’indexation un peu comme la fonctionnalité visage dans photo non ? Indexation qui se fait quand le tel est en charge…

@jul69

Certes mais si les photos ne sont pas stockées en local (juste les photos à la résolution de l’écran) la qualité risque d’être juste pour mouliner l’OCR

@nicolasf

Merci beaucoup Nicolas pour ta réponse, je comprends bien l’intérêt du fonctionnement « Live », mais du coup on reste dans l’inconnu quand à l’indexation de la photothèque ancienne.

Déjà, est-ce que ça prend au moins en compte toutes les photos en local, ou seulement celles prises a posteriori de cette fonction, ou seulement les favorites/récentes, etc. ?

Et pour ce qui est des photos sur iCloud, bien qu’on préfère l’approche locale d’Apple à celle sur serveur de Google, on peut légitimement avoir besoin/envie d’indexer toute sa bibliothèque, par exemple pour retrouver des photos prises en cours / au travail avec plein d’informations dessus, ou au moins des captures d’écran que l’on ne retrouve plus quand on en a besoin… qu’est-ce qu’il se passe dans ce cas de figure ?

Si la réponse est « ça fonctionne seulement en local, mais on peut, comme pour activer Dolby Atmos, faire des albums de 1% de sa photothèque, les télécharger, indexer et supprimer, ça peut valoir le coup de le faire à la main si la manipulation fonctionne et est réalisable.

J’imagine que c’est peut-être encore flou pour le moment, mais s’il y a l’occasion d’obtenir l’information via vos sources, essais ou en posant la question aux bonnes personnes, je pense qu’on est plusieurs personnes que cela intéresserait beaucoup !

Merci d’avance 🙏

Il y’a encore un certain fossé entre la fonction texte en direct et l’app de prise de notes Nebo.

@andr3

Vu que tu es sur la bêta d’ios15, c’est plutôt stable ou pas?

@romainB84

Patience la bêta publique va arriver lol

@romainB84

Je ne suis pas sur la bêta.

fascinant

j'arrive à lire ce que la fonction Apple ne peut pas faire.

Cela prouve donc que je ne suis pas un de ces Imbéciles Artificiels (I.A.). Reste plus qu'à prouver que je ne suis pas un Imbécile Organique...

Que se passe-t'il si iOs détecte "celui qui lit ça est un imbécile" ? :)

Fonction réservée à la puce A12 (NPU).

Ca me rappelle les nombreux tests de l'iPad Air 3 où beaucoup de testeurs avaient chié dessus en disant qu'il valait mieux prendre un iPad Pro de 2017.

Je me rappelle parfaitement avoir répondu : personnellement j'ai acheté le Air3 et pas le pro 2017 à cause de la puce A10X.... même si elle est aussi puissante, son absence de NPU sera très rapidement limitant dans les fonctions d'iOS.

comme quoi... j'avais raison plus rapidement que je ne le pensais ^^.

@romainB84

Bien joué !

@Lu Canneberges

Même pas ^^

Disons que c’était surtout du bon sens 😉!

Mais quand il y a marqué « pro » sur un produit, les gens sont comme des dingues visiblement 🤣🤣

@romainB84

Oui enfin le Pro de 2017 a quand même plein de fonctions que le Air 3 n’a pas. Meilleur son stéréo, meilleur écran, Pro Motion, bien meilleur GPU, etc. Donc au moment de ton achat, sans savoir ce qui allait arriver, tu avais tord ! lol

@BingoBob

« Donc au moment de ton achat, sans savoir ce qui allait arriver, tu avais tord ! lol »

Alors déjà … non 🤣! Je n’avais pas tort ^^ peut être pour ton usage c’est possible mais pour le mien (qui … si si je t’assure c’est possible … tu n’as pas l’usage universelle, contrairement à ce que tu sembles penser 🤣🤣)!

Et c’est comme une course… c’est pas le départ qui compte c’est la fin lol

Donc j’ai eu une bonne analyse qui a payée^^

Bah si tu as toujours tord.

iPad Air 3 :

- moins bon écran,

- son moins bon

- pas de Pro motion

- moins de GPU.

Que ton iPad soit compatible avec de nouvelles fonctions n’enlève pas le fait qu’il n’a toujours pas ce que le Pro a depuis 2017…

Et après ça, certains pensent qu’Apple n’a rien annoncé concernant la réalité augmentée.

Et niveau batterie, qu'est-ce que ça donne?

Parce que si je fais de la reconnaissance de caractères avec Seeing A I par exemple, il vaut mieux que je fasse attention, la batterie part vite...

L'une des rares nouvelles fonctionnalités intéressantes d'iOS 15.