90 associations internationales demandent l'abandon du système d'analyse de photos d'Apple

Un nouveau front hostile à la méthode choisie par Apple dans la lutte contre la pédopornographie s'est ouvert. 91 associations civiles de plusieurs continents demandent à Tim Cook d'abandonner ce projet dans sa forme actuelle.

Les signataires, réunis sous la bannière du Center for Democracy & Technology, réclament urgemment à Apple de remiser ce système de détection de photographies pédophiles. Il sera intégré à iOS cet automne, d'abord aux États-Unis, et il fonctionnera automatiquement dès lors qu'on a activé iCloud Photos.

Si l'intention est louable reconnaissent ces associations qui œuvrent pour la défense de différents droits, la méthode choisie risque d'ouvrir la porte à une surveillance beaucoup plus large et néfaste :

Nous sommes inquiets d'une utilisation qui censurerait la liberté d'expression, menacerait la vie privée et la sécurité de personnes à travers le monde et qui aurait des conséquences désastreuses pour de nombreux enfants.

Apple s'est défendue de proposer un système qui puisse être appliqué à la recherche d'autres types d'images que celles pour lesquelles il a été conçu. Des garde-fous techniques ont été prévus. Elle a également assuré qu'elle s'opposerait à toute demande de subversion de son mécanisme qui ne fonctionne qu'avec une base de référence d'images bien particulières.

Allemagne : des journalistes et des politiques inquiets du système d'analyse de photos d'Apple 🆕

Mais qu'en sera-t-il si la requête des autorités ou d'un gouvernement s'inscrit dans la loi, demandent ces associations. Apple ayant pour habitude de répondre qu'elle se conforme strictement aux lois des pays où elle est implantée, quelle sera alors sa ligne rouge ? C'est une éventualité sur laquelle la Pomme est restée muette :

Une fois que cette capacité est intégrée dans les produits Apple, l'entreprise et ses concurrents devront affronter une énorme pression — et potentiellement des exigences légales — des gouvernements du monde entier pour numériser des photos non seulement pour le CSAM [la base de référence des images de pédophiles, ndr], mais aussi pour d'autres images qu'un gouvernement juge inacceptables.

Apple l'assure, les gouvernements ne pourront pas abuser du nouveau mécanisme de lutte contre la pédopornographie

Ces exigences pourraient aller jusqu'au scan permanent des photos stockées sur l'iPhone et pas uniquement si la fonction de synchronisation iCloud Photos a été activée (le système est inopérant si cette fonction n'est pas utilisée ou lorsqu'on se contente d'une sauvegarde iCloud simple de ses photos).

En intégrant cette faculté d'analyse dans son système mobile, Apple ouvre potentiellement une boite de Pandore redoutent les signataires.

Le floutage dans Messages inquiète aussi

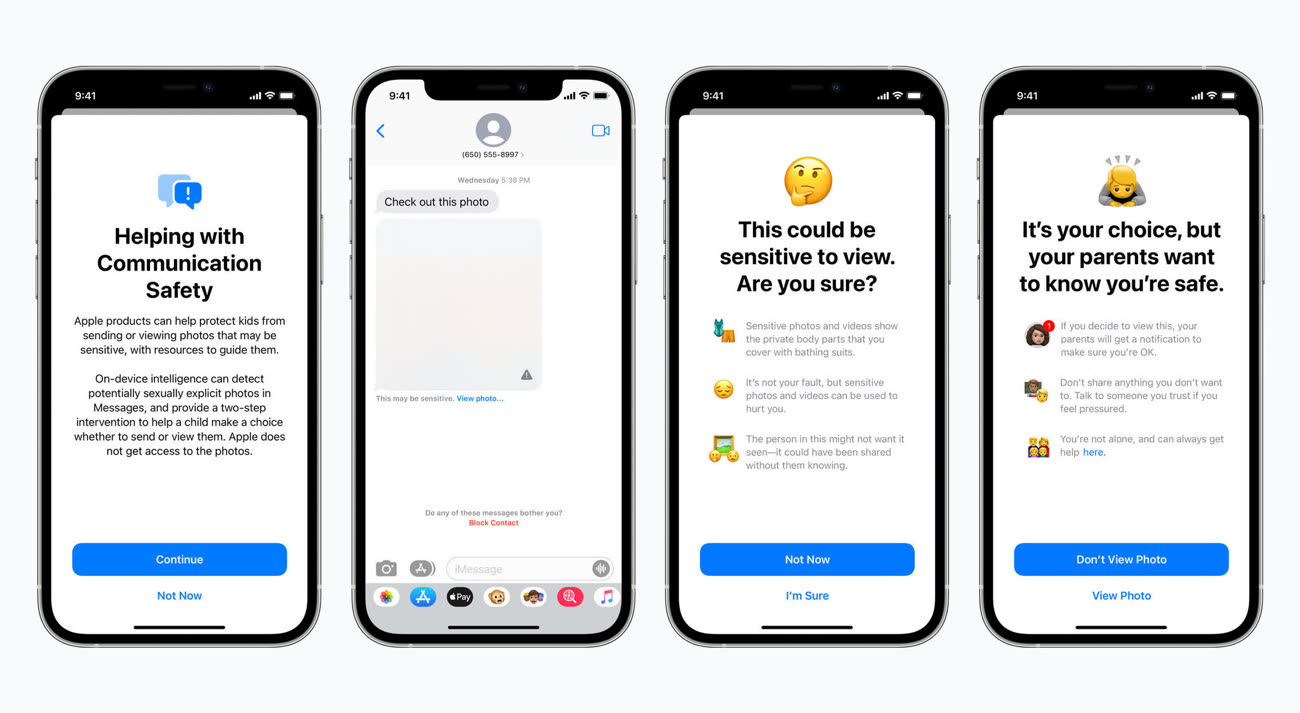

L'autre pan du projet d'Apple, relatif à la détection de photographies sexuellement explicites reçues dans Messages, n'échappe pas à la critique de ces associations qui en réclament pareillement le retrait.

Dans Messages, après activation de la future fonction depuis les réglages du partage familial, les photos reçues ou envoyées sur l'appareil iOS d'un enfant enregistré au sein d'un partage familial sont analysées en local et floutées en cas de présence d'éléments considérés comme explicites par l'algorithme.

Les parents seront prévenus par une notification de la présence de cette photo dans une conversation sur l'appareil de leur enfant. Cette alerte vaut uniquement pour les enfants de moins de 12 ans (c'est une option à activer) ; il n'y aura pas de notification pour les enfants de 13 à 17 ans.

Lutte contre la pédopornographie : Apple tente d'éteindre l'incendie avec une FAQ 🆕

Là aussi les conséquences pourraient être négatives, expliquent les associations. Il y a d'abord chez elles une méfiance vis-à-vis de la fiabilité de ce type d'algorithmes qui pourrait mélanger des images répréhensibles avec des visuels éducatifs, des œuvres d'art, des informations de santé ou d'autres contenus parfaitement innocents.

Au-delà de ça, elles considèrent que le fait pour les parents d'être automatiquement prévenus pourrait faire plus de mal que de bien dans certains cas de figure. Apple part du principe que le(s) parent(s) et l'enfant ont une relation saine et basée sur la tolérance, ce qui est évidemment loin d'être systématique :

Un adulte violent peut être l'administrateur du compte, et les conséquences de la notification parentale pourraient menacer la sécurité et le bien-être de l'enfant. Les jeunes LGBTQ+ enregistrés sur des comptes familiaux avec des parents abusifs se retrouvent particulièrement à risque.

Non seulement la garantie de confidentialité des échanges n'existe plus mais là-encore des gouvernements pourraient vouloir qu'Apple aménage son système pour leurs besoins de surveillance.

Les signataires de cette lettre réclament le retrait de ces deux fonctions des projets d'Apple et l'invitent à consulter davantage les organisations et communautés en première ligne sur ces sujets.

Ces 91 associations viennent d'horizons géographiques aussi variés que le Brésil et l'Inde (deux pays où WhatsApp par exemple, très populaire, ferraille régulièrement face aux autorités pour préserver son droit au chiffrage de bout en bout). Certaines sont du Royaume-Uni, d'Allemagne, du Canada, des États-Unis, du Népal, d'Afrique, d'Australie, du Pakistan, du Pérou, de Belgique, du Japon, du Mexique, etc. Un très large arc international qui ajoute sa voix aux inquiétudes à l'égard de cette initiative d'Apple.

Allemagne : des journalistes et des politiques inquiets du système d'analyse de photos d'Apple 🆕

Avec tous les pédos dans les hautes sphères c’est tout de même compréhensible.

@robertodino

« Avec tous les pédos dans les hautes sphères c’est tout de même compréhensible. »

Oui on sait la pizzeria, tout ça, tout ça 🙄🙄🙄🙄🙄🙄

Tout ce que fait Apple amène une levée de bouclier, je suis avec Apple, pas avec ces organisations inconnues, et Google? Tout va bien ?

Pages