Le patron de WhatsApp farouchement opposé au système de lutte contre la pédopornographie d'Apple

Apple va avoir beaucoup de travail pour expliquer et tenter de rassurer autour de sa solution de détection de photos pédopornographiques. Plusieurs organisations et personnalités sont vent debout contre ce qui est présenté comme un système de surveillance global (lire : Les nouveaux systèmes d'Apple pour lutter contre la pédopornographie inquiètent).

Will Cathcart, le patron de WhatsApp, met les deux pieds dans le plat dans un fil Twitter : il n'est pas question d'implanter un système similaire dans l'application de messagerie instantanée appartenant à Facebook. Il compare la technologie du constructeur à un « système de surveillance construit et opéré par Apple qui pourrait facilement être utilisé pour examiner du contenu privé en fonction des exigences d'un gouvernement ».

Le dirigeant s'interroge sur la gestion par Apple des requêtes des gouvernements qui voudront ajouter d'autres types de contenus que la pédopornographie. Et que se passera-t-il si une société spécialisée dans les spywares dégottait une faille dans l'armure ? Cathcart se demande également pourquoi le constructeur n'a pas travaillé avec des experts dans ce domaine (sur le site web de présentation de ces mesures, Apple partage quatre analyses techniques provenant de trois chercheurs).

L'approche d'Apple dans ce dossier pose de sérieux problèmes, selon lui, « plutôt que de se concentrer sur une manière facile pour les utilisateurs de signaler du contenu partagé avec eux, Apple a construit un logiciel qui scanne toutes les photos privées que vous ne partagez avec personne. Ce n'est pas de la confidentialité », reproche-t-il.

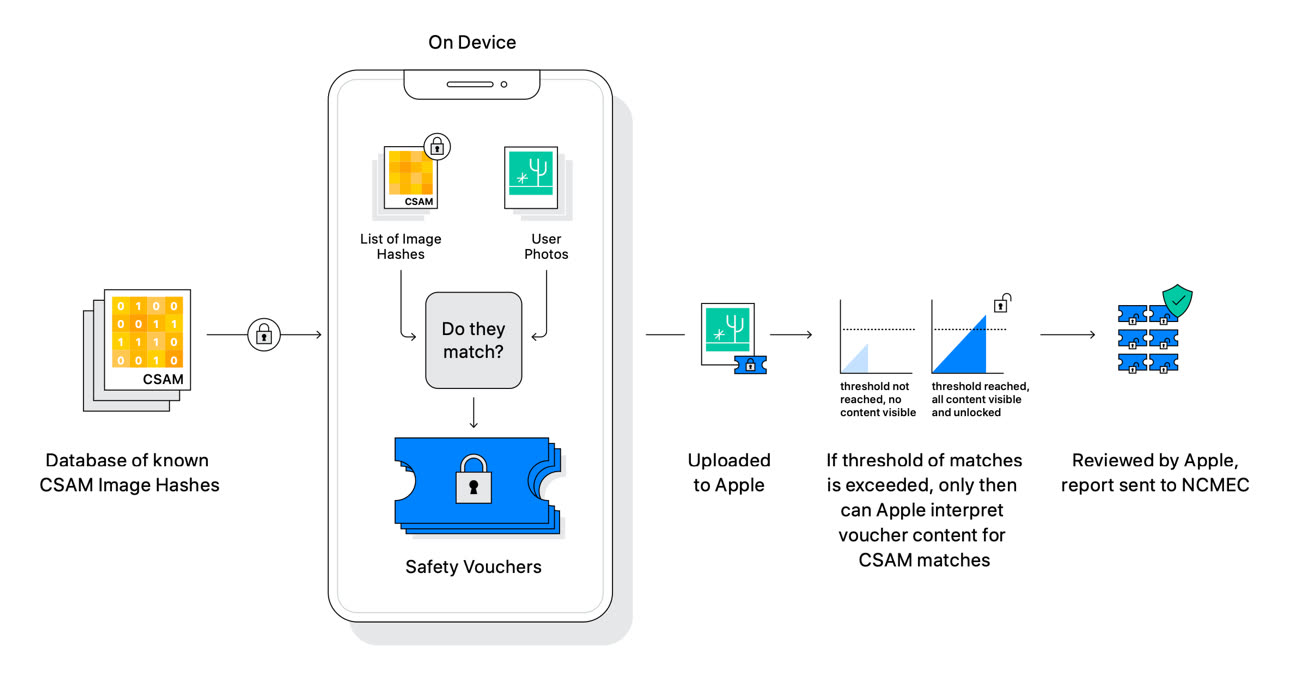

Le mécanisme de détection des images CSAM (Child Sexual Abuse Material) repose sur un mécanisme de correspondance entre une base de données d'images pédopornographiques et les photos de l'utilisateur. Plus précisément, il s'agit de comparer des suites de chiffres : les images sont converties par l'iPhone en des numéros hachées par un processus cryptographique (baptisé NeuralHash).

Ce processus de comparaison est réalisé sur l'appareil en local, avant que les images soient téléversées dans la bibliothèque iCloud Photos de l'utilisateur. En cas de correspondance avec la base de données, la photo uploadée s'accompagne d'un « bon de sécurité » qui encode le résultat de la correspondance. À partir d'un certain nombre de correspondances, Apple peut déchiffrer le contenu du bon de sécurité, une opération qui est ensuite visée par un opérateur humain.

WhatsApp a mis en place un système de signalement qui a permis de rapporter plus de 400 000 cas l'an dernier au NCMEC (National Center for Missing and Exploited Children) , « sans casser le chiffrement », s'enorgueillit Will Cathcart.

Photos, Messages : Apple dévoile de nouveaux mécanismes pour lutter contre la pédopornographie

@Insomnia

"ce genre de personne utilisent réellement iMessage"

En effet mais l’idée d’Apple est de protéger les mineurs afin qu’ils ne reçoivent pas de photos de bites, et eux ils utilisent tous iMessage. Je soutiens le floutage et l’alerte aux parents.

Ce projet d’Apple n’empêchera jamais les pedophiles adultes de communiquer entre eux, car ils utilisent plutôt Signal, Telegram, Snapchat, Discord, Kik, Kakaotalk, Viber, des e-mails encryptés en PGP, des forums web par milliers ou des trucs plus obscurs que je ne connais pas. Il y a en effet des centaines d’app de messageries sur l’app store…

Dans l’immédiat ca serait bien que Facebook procède de même pour les mineurs avec Messenger et Whatsapp, notoirement utilisé par les pedophiles pour approcher leurs victimes qu’ils repèrent sur Facebook.

@Insomnia

Il faut bloquer un maximum de moyens pour rendre la tâche plus difficile aux pedopornographes. C’est comme en sécurité informatique, l’absolu n’existe pas, mais ce n’est pas un argument pour ne rien faire. Au contraire, plus tu en fais mieux c’est.

Après, à Apple où au GAFAM de fournir l’outil et aux États et à la justice d’en faire usage et/ou de le superviser.

C’est probablement l’un des sujets les plus intéressants de ces dernières années. Alors que la question qui avait été initiée par Apple face aux autres GAFAM était celle de la confidentialité, la nouvelle question, à nouveau posée par Apple, est celle des limites de la confidentialité. On repart pour un tour, avec au passage un nouvel axe marketing pour Apple : avec nous vous protégez vos enfants. Aucun jugement de ma part, d’ailleurs personne ne devrait en avoir parce que ceci est trop récent pour être évalué.

« Le patron de WhatsApp farouchement opposé au système de lutte contre la pédopornographie d'Apple »

Apparemment fou de rage il aurait même indiqué

« La surveillance de masse ca nous est réservé! »

😝

Y aurait-il un risque du côté d’Apple, si détentrice d’évidences, à être inquiétée par quelque chose s’approchant du « non assistance à personne en danger » qui pourrait expliquer sa position technique et morale?

Mouais…. Whatsapp surveille tout autant les contenus. La surveillance de whatsapp c’est pas pour se substituer à la justice, pour des principes moraux ou des questions d’idéologie ou de salubrité publique.

C’est pour de l’analyse et ensuite en produire un profilage publicitaire à vendre.

Pour ce qui est des entreprises qui mettent des opinions dans le management ou le commercial c’est déjà bien pourri.

On le voit déjà avec des groupes d’entreprise… tiens comme bolloré par exemple, qui font n’importe quoi juste parce que ça ne plait pas à la construction mentale d’un malade qui dirige le bastringue. Chez IKEA où ont profilait les clients et employés selon des principes moraux.

Les associations c’est pas mieux, souvent refuge de rageux, de bornés, de soit disant écorchés de la vie, plus que de gens réfléchis comme chez CIVITAS, familles de France, L214….

Le monde à déjà du mal et subit déjà le foutoir avec les acteurs des pouvoirs législatifs, exécutifs, judiciaires, religieux et le caritatif, l’associatif….

Si les entreprises qui vendent du matériel numérique permettant d’effectuer une surveillance de masse en détournant la fonction première de ce matériel suivant les torpeurs ou les phobies de quelques dirigeants…. c’est la fin.

Si Apple se lance dans ce genre d’idéologie alors oui, il faudra procéder au démantèlement de celle-ci pour assurer une vraie sécurité.

@Sindanárië

« Les associations c’est pas mieux, souvent refuge de rageux, de bornés, de soit disant écorchés de la vie, plus que de gens réfléchis comme chez CIVITAS, familles de France, L214…. »

Oui, elle sont utiles, mais il est tout aussi utile de les canaliser et de les prendre avec un peu de distance, c’est sûr…

@Sindanárië

« Si les entreprises qui vendent du matériel numérique permettant d’effectuer une surveillance de masse en détournant la fonction première de ce matériel suivant les torpeurs ou les phobies de quelques dirigeants…. c’est la fin. »

Complètement d’accord, comme avec le reste de ton post.

@Sindanárië

"Whatsapp surveille tout autant les contenus"

Non, je t’appelle que Whatsapp encrypte les messages end-to-end avec le protocole de Signal. Ce n’est donc techniquement pas possible.

Par contre les photos ne sont peut-être pas encryptées, ça reste toutefois à vérifier avant de dire n’importe quoi, comme tu le fais sans vergogne.

@Brice21

Tiens voilà l’hôpital qui se fout de la charité 🤣

Au delà du débat, on appréciera le comportement de charognards….

Le business en somme.

@jcp25

"Détecter la nudité... Cela ne gêne personne ?"

Cela s’appelle mentir par omission. Ou plus simplement de la désinformation pour sensationnalisme. Ça rapporte des lecteurs plus nombreux lorsqu’épouvantés.

En l’occurrence il s’agit de détecter l’envoi de pornographie (pas juste des nus, il faut des vraies bites, chattes, tétons) uniquement pour les comptes iCloud de MINEURS et uniquement aux USA.

On s’en fou

Je me demande bien qui va avoir le droit de mater mes enfants dans leur bain ou entrain de jouer dans la piscine familiale pour vérifier que je suis un bon parent parce que Apple aura vu un zizi sur la photo 😡

mais c'est quoi ces patrons qui donnent leur avis sur des trucs pour lesquels on n'a pas besoin d'avis ?

Bon vivement le hash poisonning que le truc tombe de lui-même.

Pages