Lutte contre la pédopornographie : Apple tente d'éteindre l'incendie avec une FAQ 🆕

Le moins qu'on puisse dire, c'est qu'Apple n'a pas su convaincre du bien fondé de ses nouvelles mesures pour lutter contre les abus sexuels des enfants. Dévoilés jeudi dernier, ces mécanismes ont provoqué une levée de boucliers de chercheurs en sécurité et d'organisations de défense de la vie privée.

Devant la bronca (prévisible) suscitée par cette affaire, Apple a prévu de communiquer tous azimuts et cela s'incarne dès aujourd'hui avec une foire aux questions que le constructeur aurait été bien avisé de publier dès l'annonce de ces mesures.

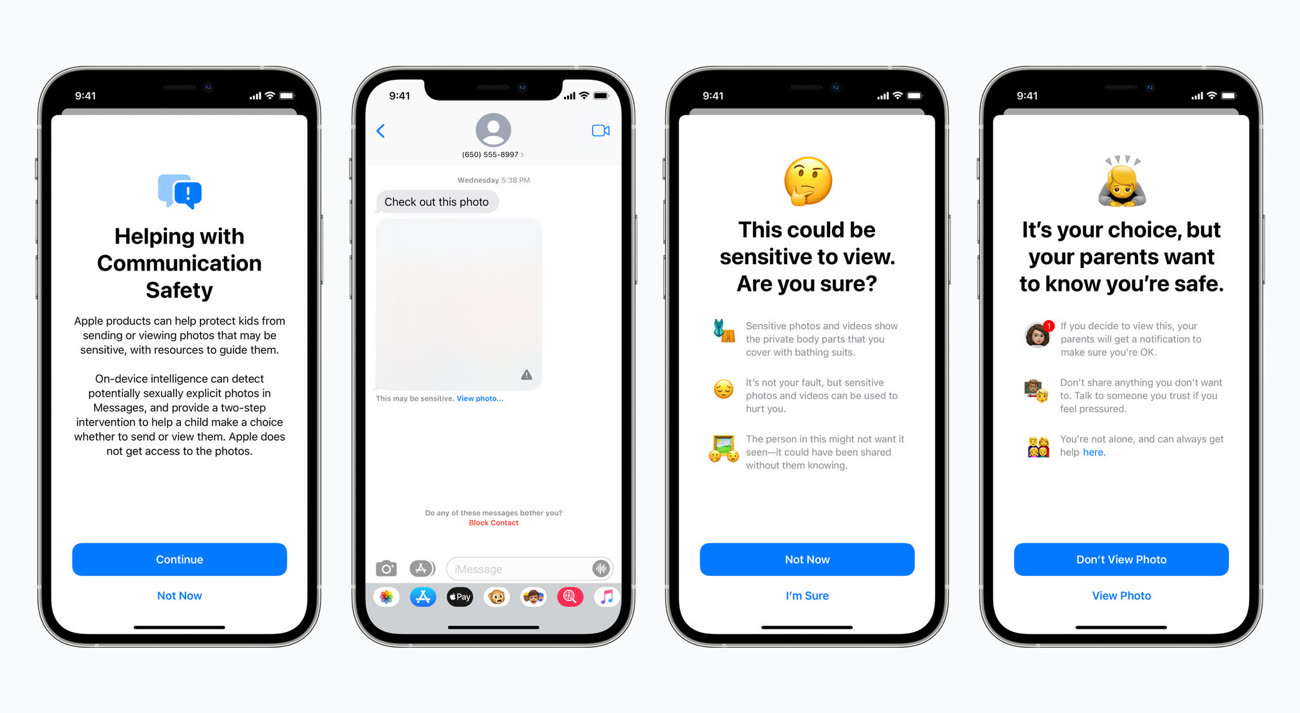

Le système de floutage des images dans Messages

En préambule, Apple éclaircit une première incompréhension : le système de floutage des photos sexuellement explicites dans Messages et celui qui détecte les photos pédopornographiques dans la bibliothèque iCloud sont différents et n'utilisent pas la même technologie.

Dans Messages, après activation de la fonction depuis les réglages du partage familial, les photos reçues ou envoyées sur l'appareil iOS d'un enfant enregistré au sein d'un partage familial sont analysées en local et floutées en cas de présence d'éléments explicites. Les parents peuvent être prévenus par notification du partage de la photo, mais uniquement pour les enfants de moins de 12 ans (c'est une option à activer) ; il n'y aura pas de notification pour les enfants de 13 à 17 ans.

Cette fonction de floutage se réalise en local et « Apple n'accède jamais aux communications » dans Messages. Le chiffrement des communications dans la messagerie est toujours réalisé de bout en bout, rien ne change ici.

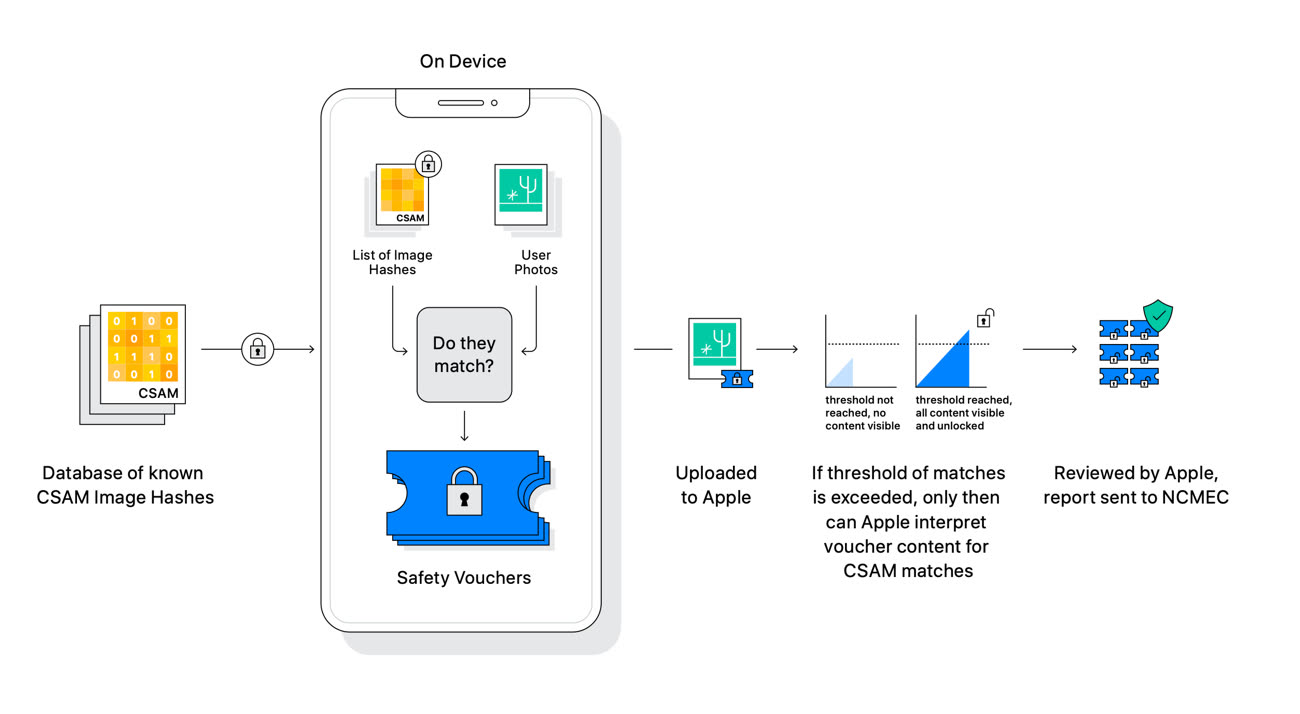

Le système de détection des photos dans la bibliothèque iCloud

Le système de détection des photos d'abus sexuels d'enfants (CSAM pour Child Sexual Abuse Material) n'a rien à voir avec celui de Messages. Apple souligne en préambule que ce mécanisme ne concerne que les photos téléversées dans la bibliothèque iCloud Photos. « Le système ne fonctionne pas pour les utilisateurs ayant désactivé la bibliothèque iCloud », martèle le constructeur.

Apple rappelle le principe global de détection CSAM. En local, il compare les photos de l'utilisateur à la base de données du National Center for Missing and Exploited Children (NCMEC), une association à but non lucratif, seule organisation habilitée à posséder de tels documents (leur possession est interdite dans de nombreux pays). Attention, Apple ne va pas télécharger sur des millions d'iPhone les photos de cette base de données, uniquement leurs hashes, c'est à dire des suites de chiffres.

« En utilisant de nouvelles fonctions cryptographiques, Apple est capable d'utiliser ces hashes pour savoir si les comptes iCloud Photos stockent des collections de photos qui correspondent aux images CSAM, et uniquement les images CSAM », précise le constructeur. Ce dernier ne saura rien des autres données stockées sur l'appareil.

Si Apple a pris la route d'une détection qui se déroule d'abord en local puis sur ses serveurs, c'est pour éviter les « risques sur la confidentialité » que font peser les autres systèmes utilisés par d'autres entreprises qui examinent les photos de leurs utilisateurs uniquement dans le nuage. « La détection CSAM dans iCloud Photos offre des bénéfices significatifs pour la vie privée, en empêchant Apple d'en apprendre davantage sur les photos des utilisateurs, à moins que celles-ci ne correspondent à des images CSAM ».

Apple cherche également à apaiser les craintes très fortes sur la sécurité de ses appareils et la confidentialité des utilisateurs. Le constructeur assure que son système ne peut servir à détecter autre chose que des images CSAM, et il faudra croire l'entreprise sur parole : « Apple refusera les demandes » des gouvernements qui voudront ajouter des images non-CSAM à la liste de hashes.

« Nous avons reçu des demandes de gouvernements pour bâtir et déployer des changements [dans la sécurité d'iOS] qui dégradent la vie privée des utilisateurs », déroule la FAQ. « Nous avons catégoriquement refusé ces demandes. Nous continuerons à les refuser à l'avenir. Soyons clairs, cette technologie se limite à la détection d'images CSAM stockées dans iCloud et nous n'accèderons à aucune demande d'un gouvernement pour l'étendre ».

Les promesses n'engageant que ceux qui y croient, Apple devra donner des gages sur ce point car ce qui se passe en Chine n'est guère encourageant.

Censure, sécurité des données : les compromissions d'Apple en Chine

Le système a été conçu de telle sorte que les hashes d'images « non CSAM » ne puissent être injectés dans la base de données : tous les iPhone et iPad recevront les mêmes hashes, donc les attaques ciblant des individus seront impossibles. Enfin, Apple précise qu'en cas de signalement, c'est un humain qui prend la relève et vérifie si la photo en question est bien litigieuse. La probabilité que le système signale de manière incorrecte un compte iCloud est « inférieure à un sur mille milliards par an ».

Mise à jour 20h30 — Dans une nouvelle séance de questions/réponses avec la presse US, Apple a indiqué que les fonctions de protection de l'enfance (pour Messages et la détection de photos pédopornographiques) pourraient être proposées à des éditeurs tiers. Par exemple, la fonction de floutage des photos sexuellement explicite pourrait être disponible dans WhatsApp, Instagram ou encore Snapchat. La détection des photos CSAM fonctionnerait avec d'autres nuages que celui d'iCloud.

Au vu de la réception pour le moins glaciale réservée par la concurrence à ces mesures (chez le patron de WhatsApp, par exemple), il n'est pas certain que l'on retrouvera de si tôt ces mécanismes ailleurs que chez Apple.

On communique tellement dessus que tous les pedophiles seront au courant et auront trouvé des alternatives à iCloud …

Si j’ai bien compris, si Apple détecte une photos mais se trompe, une personne vérifiera la correspondance entre notre photo (par exemple notre fils dans son bain) et la photo référence ?

Donc Apple a en stock des millions de photos pedopornographique ?

En fait ça représente quoi en chiffre la pedopornographie dans le monde ? C’est si vaste que ça ?

@Lexada

Non. Ils vérifient la correspondance uniquement si les deux CSAM sont quasiment identiques, à partir d’un seuil défini. (Qui en toute logique, devrait être extrêmement haut)

Pour ce qui est de la taille du contenu pedopornographique, oui, c’est un désastre tellement c’est vaste…

@Lexada

> « tous les pedophiles seront au courant et auront trouvé des alternatives à iCloud … »

Certes, mais si le reste de l’industrie suit son exemple — voire si, comme je l’évoquais dans l’autre article, cela devenait une délibération politique internationale et que c’était l’ONU qui mettait au clair les critères et les règles — il deviendra de plus en plus difficile pour les pédocriminels d’opérer !

Évidemment, les pires savent déjà très bien quoi faire, mais une partie importante de ceux qui cherchent à accéder à ces contenus ne sont pas forcément des experts en cybersécurité et ne savent alors pas se servir de TOR et d’un système informatique fait maison… donc cela agira quand même sur au moins une partie des pédocriminels.

> « Si j’ai bien compris, si Apple détecte une photos mais se trompe, une personne vérifiera la correspondance entre notre photo et la photo référence ? »

Oui, mais la correspondance doit être extrêmement précise, cela ne devrait vraiment pas arriver sur une photo innocente et personnelle !

> « Donc Apple a en stock des millions de photos pedopornographique ? »

Pas Apple, mais l’ONG qui gère cela, et qui le fait depuis très longtemps, et est évidemment extrêmement surveillée et régulée !

> « En fait ça représente quoi en chiffre la pedopornographie dans le monde ? C’est si vaste que ça ? »

Oui, tu n’as pas idée d’à quel point c’est gigantesque et monstrueux !!

@Lu Canneberges

Merci pour les infos

Je viens d’aller faire un tour sur Wikipedia

Effectivement ça pourrait concerner 1 à 5% de la population et des dizaines de milliards d’euro par an en chiffre d’affaires …

Personnellement je ne suis pas contre, à la limite je m’en fou presque qu’Apple puisse voir mes photos si il y a des erreurs mais je comprend aussi que les gens sont inquiets et se posent des questions

J’ai plutôt confiance en Apple pour ça

A voir

@Lu Canneberges

*Oui, tu n’as pas idée d’à quel point c’est gigantesque et monstrueux !!*

À ce point? J'ai toujours cru (naïvement) que les pédos constituaient une branche ultra minoritaire parmi toutes les déviances sexuelles existantes (genre nécrophilie, zoophilie...).

On a des chiffres dessus?

Ils passent leur truc je vais voir Android #pixel6

Tout ce qui permet de lutter contre la pédophilie doit être encouragé. L’intérêt de l’enfant doit être supérieur, il est protégé par la convention internationale des droits de l’enfant de l’UNICEF, et plus particulièrement son article 34 dans ce cas.

C’est vraiment bien qu’Apple s’engage…

@mattcastel

+1, tous les frustrés contre cela n’ont pas la conscience tranquille… il faut que ce genre de système soit cadré mais être contre la lutte pedopornographique …. Je ne comprends pas les gens…

@33man

Alors, oui et non. Autant chacun a son opinion sur ce sujet avec l’action d’Apple, autant, non, on ne peut pas tout justifier sous l’étendard du CP. Guérir le mal par le mal, ça ne marche pas. Et être contre une méthode de résolution d’un problème ne signifie pas être pour le problème. C’est très réducteur comme façon de voir les choses. C’est pas blanc ou noir.

@mattcastel

"Tout ce qui permet de lutter contre la pédophilie doit être encouragé."

Non. On ne peut pas TOUT se permettre.

@MarcMame

En tout cas les pédophiles eux le font

@raoolito

"En tout cas les pédophiles eux le font"

Non. Pas tous. Et surtout, quel rapport ?

@mattcastel

Ils s’engagent sur la mauvaise voie et ouvre la boîte de Pandore à la recherche d’autres contenu. Si on ajoute que l’essentiel de la pedophilie se déroule dans le cercle familial, cela donne encore plus l’impression que l’on se trompe de cible tout en prenant des risques pour la vie privée.

@Patrick_C

Pour compléter mon propos précédent, je vous rappelle qu’au fond de la Boîte de Pandore, lorsque tous les fléaux et maux de l’humanité s’en sont échappés, a subsisté une disposition de l’esprit humain, souvent perçue comme fragile, mais qui peut s’avérer puissante.

Il s’agit de l’ESPÉRANCE 😉.

Je continue à affirmer que la pédopornographie relève du droit pénal et qu’à ce titre, elle doit être traitée — dans un état de droit, — par le système judiciaire comme n’importe quelle entreprise criminelle, et NON PAR UNE ENTREPRISE PRIVÉE.

S’agissant d’une criminalité internationale, ce combat nécessite d’être mené par des instances internationales telles qu’Interpol qui doivent être suffisamment financées pour être efficaces.

Apple peut fournir, si elle le désire et bénévolement, les moyens informatiques à ces instances pour contribuer à cette lutte (payer ses impôts également), ce dont chacune et chacun lui sera gré. En aucun cas, elle peut se substituer à l’état de droit.

@sambucus

Sauf que là on est entre véritablement dans ce qu’on appelle la Backdoor

Et quand on voit les debats sans fin sur anti Covid on se doute bien que si en plus dans le communiqué il y avait marqué « et ce sont les autorités judiciaires de chaque pays qui vont aller regarder ce qu’il y a dans votre téléphone » alors là c’est l’hallali

@raoolito

Le question des backdoors n’est pas mon propos. Les enquêteurs formés ont des techniques de travail déjà éprouvées. Régulièrement, de vastes enquêtes sont couronnées de succès. Ce travail est encadré par les différents droits nationaux, ce qui complique le travail. En revanche, « tous les coups ne sont pas permis ».

Malgré tout, plusieurs fois par années, les actualités rendent compte de succès appréciable.

Comme trop souvent, les budgets sont étriqués. Le combat contre la criminalité informatique internationale, — dont la pédopornographie n’est qu’un des aspects, — ne peut pas être porté au point de la contenir, voire la faire régresser.

Voilà pourquoi, les richissimes entreprises et les privés qui se soustraient à l’impôts, contribuent à l’essors de ces terribles agressions contre les plus vulnérables.

@sambucus

Très bon contre-exemple d’Interpol : la Chine (et d’autres pays) injectent dans la base de données des notices rouges en y glissant des militants politiques classés en terroristes. Demain, qu’est-ce qui empêche la Chine de faire insérer des images non pas pedophiles mais politique sous des prétextes de lutte contre le terrorisme ?

@Patrick_C

Je n’ai jamais entendu parler de cette stratégie chinoise. Ceci étant, la duplicité de certains gouvernements étant ce qu’elle est, je crois possible ce genre de malversation. Pas seulement de la Chine par ailleurs.

D’où l’importance que ce combat contre ces formes de criminalité transnationales soit encadré par un droit pénal supranational, dont l’application soit confirmé à des organisations supranationales comme pourrait l’être le Tribunal Pénal International en articulation avec les instances judiciaires nationales.

Encore faudrait-il qu’une volonté existe. Encore faudrait-il que les citoyens s’unissent pour l’exiger. Je pense malgré tout que c’est possible.

@sambucus

https://www.ledevoir.com/monde/497397/l-europe-s-inquiete-de-l-utilisation-abusive-d-interpol-par-des-regimes-autoritaires

https://www.yabiladi.com/articles/details/112986/interpol-suspend-notice-rouge-l-activiste.html

https://france3-regions.francetvinfo.fr/auvergne-rhone-alpes/emissions/qui-sommes-nous/documentaire-interpole-police-influence-lundi-6-mai-23h45-france-3-1665257.html

Donc polluer une base de données, des régimes comme la Chine, la Russie ou l’Iran, savent très bien le faire.

@Patrick_C

Je ne suis pas naïf. Ni les services de polices, ni la justice ne sont parfaits et de loin. Aucun pays n’est épargné par cette réalité. Aucun.

L’Espérance qui reste au fond de la Boîte de Pandore, c’est de pouvoir les faire évoluer, c’est le travail de professionnels compétents qui cherchent à mieux faire; c’est la pluridisciplinarité qui permet d’additionner les compétences au lieu de les mettre en opposition, un nombre incroyable d’engagements dont on ne parle jamais.

C’est le travail de chacun de nous, citoyens. Le pire, c’est l’indifférence, la critique facile, rejeter la faute sur les autres, déléguer ses responsabilitéspersonnelles, etc.

Bien sûr que vous avez raison de souligner que toutes sortes d’abus sont possibles, notamment par des régimes autoritaires, voir franchement tyranniques. Ils détournent au profit de leur toute-puissance ce qui devrait servir le « bien commun ».

Mais ce n’est pas à des français que je vais apprendre la « résistance » à la tyrannie. Stéphane Hessel a écrit un très beau plaidoyer dans un petit opuscule à moins de 5€ qui se lit en 1h : « Indignez-vous ».

Une façon positive de lutter, c’est faire ressortir tout ce qui va en faveur du bien commun, du respect des autres, … et pas seulement faire toujours état de ce qui est négatif ou impossible. Ça finit par être désespérant. Il faut parler des deux aspects, afin de se montrer ni candide, ni sceptique.

Je suis navré de vous dire que votre commentaire m’attriste et conduit au découragement. Vous semblez laisser entendre que l’on ne peut rien contre ces pays et que rien n’est possible. Que diriez-vous de proposer quelque chose de constructif et d’encourageant en complément de vos remarques ?

@sambucus

« Stéphane Hessel a écrit un très beau plaidoyer dans un petit opuscule à moins de 5€ qui se lit en 1h : « Indignez-vous ». »

Ah.

Je l’ai trouvé très bête ;)

Et je suis pas le seul…

Pour le reste, complètement d’accord.

@Patrick_C

Cette digression éloigne de mon propos initial relatif au projet d’Apple. Je continue d’affirmer que ce projet de lutte contre un aspect marginal de criminalité informatique — néanmoins extrêmement préjudiables pour les victimes de pédopornographie — est non seulement dangereux pour de nombreuses raisons mentionnées dans nombre de commentaires à cet article, mais FONDAMENTALEMENT ILLÉGITIME.

À ce titre, il doit être fermement combattu au profit du système judiciaire — bien qu’imparfait dans les pays cherchant le bien commun et non la domination ou la toute-puissance, —sachant que c’est la moins mauvaise solution à notre disposition.

@sambucus :

Merci pour ce message plein de bon sens.

@sambucus

Parfaitement résumé. Cette initiative d’Apple est totalement déplacée. Personne ne lui a rien demandé et elle n’a aucune légitimité à le faire. Et comme vous dites si vraiment Apple estime devoir s’impliquer d’avantage dans cette lutte alors qu’elle fournisse son soutien aux autorités compétentes et légitimes.

Quelqu’un a t’il une idée du traitement effectué par Google et autres pour identifier les photos du NCMEC ?

Il me semble intéressant d’avoir une vision globale sur les process utilisés par les différents acteurs du secteur.

Par ailleurs, y’a t’il une contrainte réglementaire aux USA sur ce sujet ?

Merci d’avance

@Luneart

Très bonne question ! Un panorama ou « benchmark » des pratiques de Google, Facebook, Microsoft, Amazon… réalisé par la rédaction de MacG serait très intéressant et utile !

google va aussi le faire. le site Patreon a récemment modifié sa réglementation pour les auteurs, en élargissant les interdictions sur ces sujets. bref c'est plutôt une directive, ça vient pas seulement de Apple.

Dernière chose : les mots sont importants, faisons attention à ne pas confondre « pédophile » et « pédocriminel ». Ce n’est pas de sa faute si l’on est « pédophile », c’est un trouble psychologique inné que personne ne souhaite ; ce qui est impardonnable et évidemment à combattre à tout prix c’est le fait de passer à l’action !

Donc les groupes de parole pour les pédophiles, l’accompagnement psychologique, voire le transfert vers le dessin et uniquement le dessin (ce qui est la stratégie du Japon, avec relativement de succès), sont des solutions primordiales pour lutter contre la pédocriminalité !

Il ne faut ni chercher à lire dans les pensées ou prédire le crime comme dans Minority Report, ni vouloir castrer ou condamner à mort les pédophiles qui n’ont rien fait de mal, cela serait absolument inutile, dangereux et extrêmement immoral aussi !

Donc je vous invite à utiliser « pédocriminels » et « pédocriminalité » plutôt que « pédophile/pédophilie », cela recouvre des choses très différentes !

@Lu Canneberges

"Ce n’est pas de sa faute si l’on est « pédophile », c’est un trouble psychologique inné que personne ne souhaite ; ce qui est impardonnable et évidemment à combattre à tout prix c’est le fait de passer à l’action !"

Je crois bien que la simple détention d’images pédo-pornographiques est déjà sanctionnée par la loi.

@DahuLArthropode

"Je crois bien que la simple détention d’images pédo-pornographiques est déjà sanctionnée par la loi."

C’est exactement ce qu’il dit. La détention et la distribution d’images pédo-pornographiques relèvent du droit criminel, mais on peut être pédophile et ne jamais faire l’un ni l’autre.

@Lu Canneberges

👍🏻

Merci de nous rappeler cette distinction.

@jcp25

« La pedophilie est

1- une maladie psychiatrique (voir DSM 4/5) : relations sexuelles pendant plus de 6 mois sur un enfant pre-pubere par une personne ( femme ou homme) ayant au moins 5 ans de plus. »

Mais enfin n’importe quoi !!!

T’es gratiné, toi aussi.

Censurez ce post.

C’est quoi l’intérêt de venir jouer l’expert d’un sujet dont on ne sait ni comprend rien ?

@Bigdidou

« Mais enfin n’importe quoi !!! »

On atteint le summum de la connerie c’est sûr..

…mais la bonne attitude serait soit de ne pas réagir face à autant de bêtise, soit d’apporter les bons éléments de définition

…pas d’appeler à la censure

@jazz678

« …pas d’appeler à la censure »

Bien sûr que si.

On n’est pas dans le débat d’idée.

Une fausse information de cette nature, ça s’efface.

Évidemment.

Elle n’a pas lieu d’être.

La liberté d’expression n’est pas le droit de raconter n’importe quoi surtout sur un sujet aussi sensible.

@Bigdidou

Pas mon avis

Un fausse information se combat en apportant une vraie information. Crédible. Référencée.

Seule manière de l’annihiler

J’ai un problème avec la censure. Quelle qu’elle soit.

Mais soit..

Sujet clos de mon côté

@jcp25

« J'ai mis la définition de la pedophilie issue du DSM 4 »

Absolument pas et on en est au DSM V.

En plus le IV est caduque, déjà qu’il y a eu une révision entre IV et le V.

Mais même, ce n’est la définition de la pedophilie d’aucun DSM, aucune CIM.

Vous êtes fascinants, les pourvoyeurs de vérité alternatives.

Aucun problème non seulement à affirmer un truc faux (mais de façon délirante), pourtant facile à vérifier, et, donc, même de le réaffirmer !

Ou alors tu es juste débile et tu as confondu je ne sais quoi ?

@jcp25

C’est presque ça mais ta traduction du DSM est tellement mauvaise qu’elle est fautive ou en tout cas ne veut pas dire grand chose par endroits.

Des fantaisies, franchement…

🤣🤣🤣

De toute façon, nous sommes donc très loin de ta définition initiale tronquée puisque la pédophilie, comme toutes les paraphilies, peut se résumer (le plus souvent) à de simples fantasmes sans jamais de passages à l’acte.

Dans paraphilies, le passage à l’acte est minoritaire, et personne n’est responsable de ses fantasmes.

« Selon l'Association américaine de psychiatrie et son manuel le DSM-5, le trouble pédophilique constitue une paraphilie et non pas une orientation sexuelle »

Évidemment, mais c’est une très mauvaise traduction du DSMV qui ne précise pas ça, mais que des pulsions sexuelles sans dommages (ni culpabilité, ni anxiété, ni globalement de troubles du fonctionnement social, et, donc, sans passage a l’acte) n’est pas une paraphilie mais bien une orientation sexuelle.

@jcp25

Oui, c’est un métier de comprendre ces trucs là…

Y a pas trop de place pour, comment tu dis ? La fantaisie :D

Un point qui n'est pas abordé dans la FAQ, c'est l'impact et l'efficacité attendus d'une telle mesure.

Il me semble qu'on va juste attraper les plus petits poissons, à savoir les quelques pervers qui stockent de la pédopornographie en clair sur leur icloud.

Les abuseurs, producteurs de ces contenus, tout comme les partageurs, vendeurs, acheteurs organisés sur le darknet ou ailleurs n'ont aucun souci à se faire.

On ouvre donc la boîte de Pandore de l'analyse des photos en local pour détecter du contenu illégal en brandissant l'épouvantail de la pédocriminalité, mais l'impact sur cette dernière sera bien moindre que celui sur les limites de notre vie privée.

l'analyse des photos se faisait déjà depuis longtemps. rien ne change (l'argument boite de pandore est bidon). bref Apple sait tout de toi, si t'es ou pas un pervers.

et même pour les autres ça va poser problème, parce que sans clients, leur activité sera moindre. les cibles aussi. dès qu'il y a une demande, des clients, une activité commerciale nait. sans clients ça disparait tout seul. c'est l'argent qui motive.

@marenostrum

"l'analyse des photos se faisait déjà depuis longtemps. rien ne change (l'argument boite de pandore est bidon). bref Apple sait tout de toi, si t'es ou pas un pervers. "

Exactement. Beaucoup ne semblent pas connaitre la fonction “recherche” dans Photos, où l’IA permet deja de detecter les photos si on tape “nourriture”, “porte”, “chat”, “voiture”, etc. Là on remplace par “nu” ou “sexe”, (ca doit etre un peu plus poussé toutefois avec un bon dictionnaire), mais la logique est là et existe depuis un bon moment. Donc tous ceux qui ralent deja pour ne pas qu’Apple fouille dans leur iPhone, vie privee, etc… a mourir de rire. Mais c’est deja scanné! Apple recupere juste les clefs quand c’est televersé, y a rien qui change.

Vous ne voyez pas de différence entre chercher vous-même dans vos photos selon vos critères, et voir Apple venir fouiller dans vos photos celles qui pourraient vous conduire à voir débarquer le FBI en enfonçant la porte un matin à 6h? 😳

@r e m y

"Vous ne voyez pas de différence entre chercher vous-même dans vos photos selon vos critères, et voir Apple venir fouiller dans vos photos celles qui pourraient vous conduire à voir débarquer le FBI en enfonçant la porte un matin à 6h? 😳"

Lire l’article et surtout, mais alors surtout, les réponses d’Apple, avant d’affabuler avec de tels propos. C’est vraiment pas comme ça que ca fonctionne.

@marenostrum

Oui, mais sauf erreur de ma part, elle se fait en local.

@albandf

C’est vrai, mais en trouvant les consommateurs, on peut parfois remonter le fil.

Pages