Lutte contre la pédopornographie : Apple tente d'éteindre l'incendie avec une FAQ 🆕

Le moins qu'on puisse dire, c'est qu'Apple n'a pas su convaincre du bien fondé de ses nouvelles mesures pour lutter contre les abus sexuels des enfants. Dévoilés jeudi dernier, ces mécanismes ont provoqué une levée de boucliers de chercheurs en sécurité et d'organisations de défense de la vie privée.

Devant la bronca (prévisible) suscitée par cette affaire, Apple a prévu de communiquer tous azimuts et cela s'incarne dès aujourd'hui avec une foire aux questions que le constructeur aurait été bien avisé de publier dès l'annonce de ces mesures.

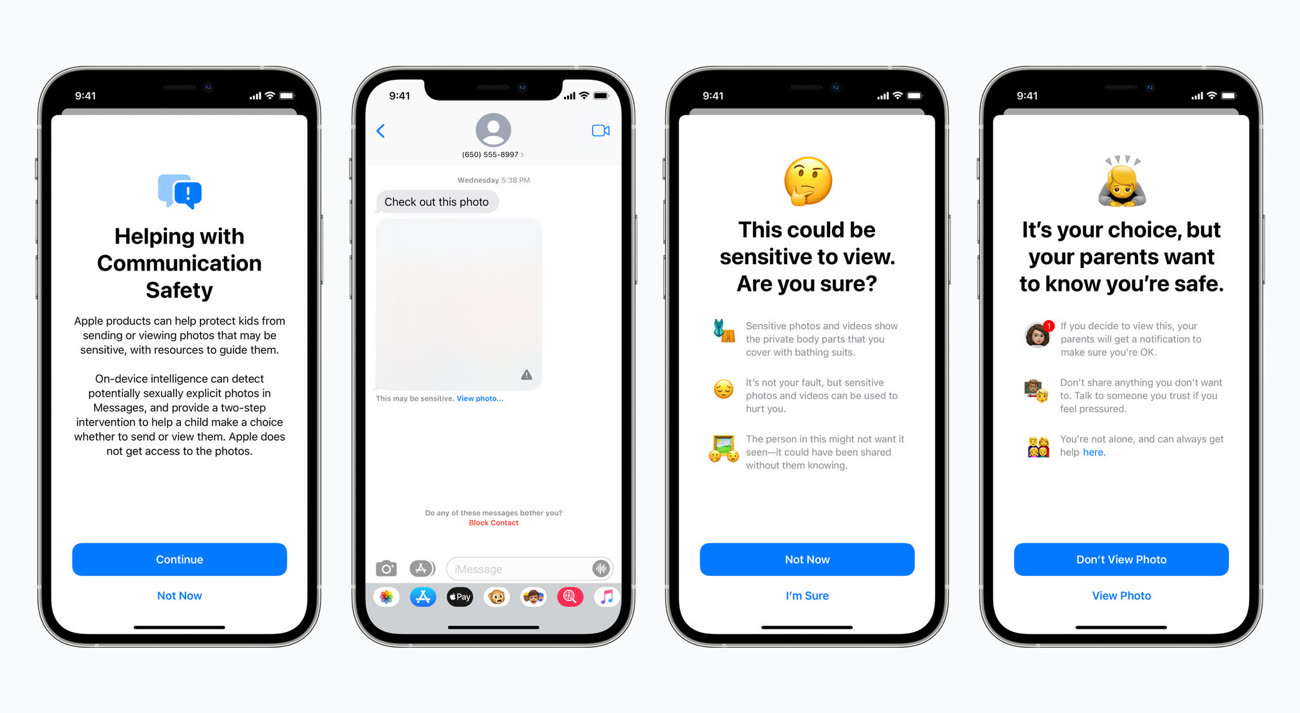

Le système de floutage des images dans Messages

En préambule, Apple éclaircit une première incompréhension : le système de floutage des photos sexuellement explicites dans Messages et celui qui détecte les photos pédopornographiques dans la bibliothèque iCloud sont différents et n'utilisent pas la même technologie.

Dans Messages, après activation de la fonction depuis les réglages du partage familial, les photos reçues ou envoyées sur l'appareil iOS d'un enfant enregistré au sein d'un partage familial sont analysées en local et floutées en cas de présence d'éléments explicites. Les parents peuvent être prévenus par notification du partage de la photo, mais uniquement pour les enfants de moins de 12 ans (c'est une option à activer) ; il n'y aura pas de notification pour les enfants de 13 à 17 ans.

Cette fonction de floutage se réalise en local et « Apple n'accède jamais aux communications » dans Messages. Le chiffrement des communications dans la messagerie est toujours réalisé de bout en bout, rien ne change ici.

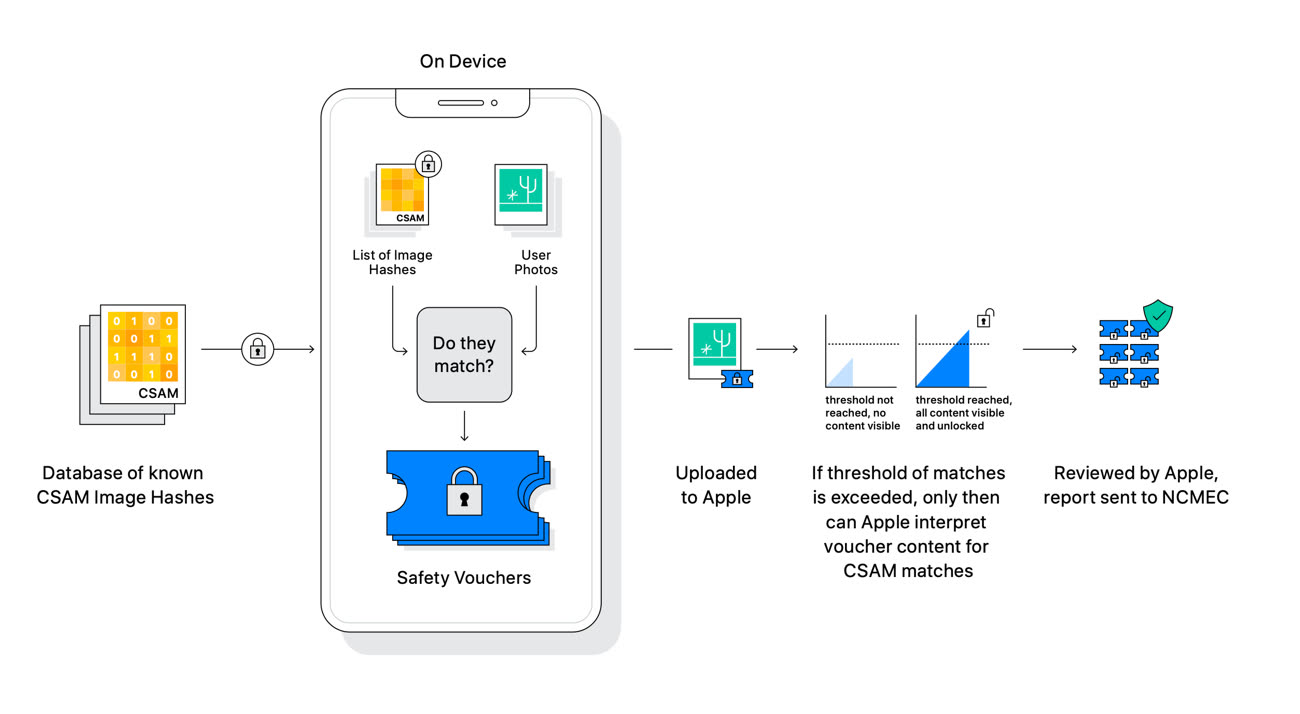

Le système de détection des photos dans la bibliothèque iCloud

Le système de détection des photos d'abus sexuels d'enfants (CSAM pour Child Sexual Abuse Material) n'a rien à voir avec celui de Messages. Apple souligne en préambule que ce mécanisme ne concerne que les photos téléversées dans la bibliothèque iCloud Photos. « Le système ne fonctionne pas pour les utilisateurs ayant désactivé la bibliothèque iCloud », martèle le constructeur.

Apple rappelle le principe global de détection CSAM. En local, il compare les photos de l'utilisateur à la base de données du National Center for Missing and Exploited Children (NCMEC), une association à but non lucratif, seule organisation habilitée à posséder de tels documents (leur possession est interdite dans de nombreux pays). Attention, Apple ne va pas télécharger sur des millions d'iPhone les photos de cette base de données, uniquement leurs hashes, c'est à dire des suites de chiffres.

« En utilisant de nouvelles fonctions cryptographiques, Apple est capable d'utiliser ces hashes pour savoir si les comptes iCloud Photos stockent des collections de photos qui correspondent aux images CSAM, et uniquement les images CSAM », précise le constructeur. Ce dernier ne saura rien des autres données stockées sur l'appareil.

Si Apple a pris la route d'une détection qui se déroule d'abord en local puis sur ses serveurs, c'est pour éviter les « risques sur la confidentialité » que font peser les autres systèmes utilisés par d'autres entreprises qui examinent les photos de leurs utilisateurs uniquement dans le nuage. « La détection CSAM dans iCloud Photos offre des bénéfices significatifs pour la vie privée, en empêchant Apple d'en apprendre davantage sur les photos des utilisateurs, à moins que celles-ci ne correspondent à des images CSAM ».

Apple cherche également à apaiser les craintes très fortes sur la sécurité de ses appareils et la confidentialité des utilisateurs. Le constructeur assure que son système ne peut servir à détecter autre chose que des images CSAM, et il faudra croire l'entreprise sur parole : « Apple refusera les demandes » des gouvernements qui voudront ajouter des images non-CSAM à la liste de hashes.

« Nous avons reçu des demandes de gouvernements pour bâtir et déployer des changements [dans la sécurité d'iOS] qui dégradent la vie privée des utilisateurs », déroule la FAQ. « Nous avons catégoriquement refusé ces demandes. Nous continuerons à les refuser à l'avenir. Soyons clairs, cette technologie se limite à la détection d'images CSAM stockées dans iCloud et nous n'accèderons à aucune demande d'un gouvernement pour l'étendre ».

Les promesses n'engageant que ceux qui y croient, Apple devra donner des gages sur ce point car ce qui se passe en Chine n'est guère encourageant.

Censure, sécurité des données : les compromissions d'Apple en Chine

Le système a été conçu de telle sorte que les hashes d'images « non CSAM » ne puissent être injectés dans la base de données : tous les iPhone et iPad recevront les mêmes hashes, donc les attaques ciblant des individus seront impossibles. Enfin, Apple précise qu'en cas de signalement, c'est un humain qui prend la relève et vérifie si la photo en question est bien litigieuse. La probabilité que le système signale de manière incorrecte un compte iCloud est « inférieure à un sur mille milliards par an ».

Mise à jour 20h30 — Dans une nouvelle séance de questions/réponses avec la presse US, Apple a indiqué que les fonctions de protection de l'enfance (pour Messages et la détection de photos pédopornographiques) pourraient être proposées à des éditeurs tiers. Par exemple, la fonction de floutage des photos sexuellement explicite pourrait être disponible dans WhatsApp, Instagram ou encore Snapchat. La détection des photos CSAM fonctionnerait avec d'autres nuages que celui d'iCloud.

Au vu de la réception pour le moins glaciale réservée par la concurrence à ces mesures (chez le patron de WhatsApp, par exemple), il n'est pas certain que l'on retrouvera de si tôt ces mécanismes ailleurs que chez Apple.

Même avec les meilleures intentions du monde Apple est une société cotée en bourse, qui comme toutes les autres entreprises cotées en bourse a comme priorité le cours de l'action. Ce n'est pas son job de se substituer aux états pour faire la police dans le monde, ce serait une porte ouverte à de futures dérives ; ce type de contrôle doit être encadré par des accords internationaux et supervisé par une autorité internationale fiable et légitime... et si ensuite Apple souhaite mettre sa technologie à disposition et sous contrôle de cette autorité, why not, Google en fera de même et ça n'en sera que plus efficace.

Apple (ou ceux qui le dirigent) c'est l'état en fait. c'est les mêmes. c'est naïf ne pas comprendre ça.

"...Apple souligne en préambule que ce mécanisme ne concerne que les photos téléversées dans la bibliothèque iCloud Photos. « Le système ne fonctionne pas pour les utilisateurs ayant désactivé la bibliothèque iCloud », martèle le constructeur...."

Que les photos téléversées dans la bibliothèque iCloud??? Pourtant il y a 18 mois on apprenait qu'ils font le même travail de filtrage sur les emails qui transitent par leurs serveurs, avant signalement aux autorités.

https://www.macg.co/aapl/2020/02/icloud-details-sur-la-facon-dont-apple-gere-les-contenus-pedophiles-111919

Dans le cas rapporté par Forbes, aucune charge n'avait finalement été retenue contre l'individu signalé aux autorités par Apple après contrôle par le FBI d'un certain nombre de documents disponibles sur son compte iCloud.

Open source vs logiciel propriétaire.

C’est dans des cas comme ça qu’on en prend toute la mesure.

a bien raison et je trouve cette mesure excellente. Les pedo doivent être traqués, arrêtés et mis hors d’état de nuire.

Arrêtez de faire les vierges effarouchées avec vos libertés !

Vous êtes quasiment toutes et tous inscrits sur des réseaux sociaux… pensez vous ne pas déjà être traqués ???

Rien que de faire une carte grise, vos données sont vendues à des entreprises privées…

@gattuz

Ce n’est pas à Apple (ou à toute entreprise privée) de traquer les pédocriminels et les dénoncer de sa propre initiative, mais aux autorités compétentes.

Si Apple veut contribuer utilement à ce combat, qu’elle paye le juste montant d’impôts correspondant à ses activités. Les rentrées supplémentaires d’argent public aideraient bien plus cette cause qui est juste.

Si un tel système se met en place, les pédocriminels n’utiliseront plus iCloud, mais le reste des utilisateurs qui n’a rien demandé continuera à voir ses photos analysées.

C’est bien la première fois qu’on veut moissonner les données des utilisateurs non pas pour monétiser un service gratuit ou pour identifier des bugs de fonctionnement, mais à des fins de moralité.

Non, on ne peut pas tout accepter au nom d’une cause, aussi juste soit-elle. Il y a d’autres moyens que d’ajouter des moyens de surveillance qui concernent toute une population d’utilisateurs (plus de moyens pour les forces de l’ordre dont c’est le métier).

Et certains mentionnent la reconnaissance d’objets actuelle dans la bibliothèque de photos. Cela n’a rien à voir car elle réalisée uniquement en local sur le terminal sans envoi, et n’appelle pas de dénonciation des utilisateurs selon des critères arbitraires.

@dexter :

Entièrement d'accord. Ça fait plaisir de constater que certaines personnes, face à ce sujet sensible, gardent leur capacité de réflexion et évitent les simplifications extrêmes de type "toutes les mesures pour lutter contre la pédo-pornographie sont bonnes à prendre" et "c'est Apple qui le fait alors tout va bien".

Extrait de l'article :

« La probabilité que le système signale de manière incorrecte un compte iCloud est "inférieure à un sur mille milliards par an". »

Avec ce genre de déclaration, où Apple balance un gros chiffre au doigt mouillé sans fournir la moindre explication supplémentaire, comment qui que ce soit pourrait croire les promesses de la Pomme ? o_O'

Dans le cas rapporté par Forbes, il y a 18 mois (comme quoi, il y a un moment qu'Apple fait cette analyse des photos...) aucune charge n'a été retenue contre l'individu signalé par Apple au FBI.

On peut donc en conclure que LE cas sur mille milliard s'est déjà produit. On est donc tranquille pour quelques siècles maintenant! 😊

@webHAL1

"Extrait de l'article :

« La probabilité que le système signale de manière incorrecte un compte iCloud est "inférieure à un sur mille milliards par an". »

Avec ce genre de déclaration, où Apple balance un gros chiffre au doigt mouillé sans fournir la moindre explication supplémentaire, comment qui que ce soit pourrait croire les promesses de la Pomme ? o_O'"

Ca repose tout simplement sur la loi de Poisson a mon humble avis.

Je suis pour la protection des enfants mais contre cette intrusion inacceptable dans ma vie privée. Si Apple va de l’avant, j’arrêterai d’acheter de l’espace sur iCloud et je n’installerai pas la version de iOS contenant cette application.

Hahahaha apple et son privacy a la sauce comme ça l arrange. Déjà avec les serveurs en Chine. En tout cas gaffez vous avec vos sex tapes car l algorithme peut vous croire plus jeune que vous ne l êtes . 🤣😂🤣😂🤣

L’enfer est pavé de bonnes intentions mais les populations sont prêtes à accepter n’importe quoi en se moment pourvu qu’un diable soit désigné. Il faut en profiter…

Quelque chose me gêne.

Un paragraphe dit ds l’article que le scann ne fera que sur les fotos téléchargées sur iCloud.

Le paragraphe d’après, précise qu : en local, les fotos seront …

En local où ? Sur le Phone ou iCloud ? Car si c’est sur le phone. C’est donc qu’il y aura donc bien un outil de surveillance généralisé…

@MacGruber

"Quelque chose me gêne.

Un paragraphe dit ds l’article que le scann ne fera que sur les fotos téléchargées sur iCloud.

Le paragraphe d’après, précise qu : en local, les fotos seront …

En local où ? Sur le Phone ou iCloud ? Car si c’est sur le phone. C’est donc qu’il y aura donc bien un outil de surveillance généralisé…"

Le scan se fera (et se fait deja) sur iPhone, en local donc (comme ca existe deja avec la fonction recherche dans Photos). Si et seulement si, tu utilises iCloud pour televerser tes photos, alors tu enverras avec tes photos les clefs (le fameux hash) a Apple pour qu’elle puisse comparer avec la base de donnees de photos illegales.

@Paquito06

Je me posais aussi la même question. Mais c'est la même information partout.

Cela n'étant pas clair / transparent, cela montre, selon moi, que Apple ne dit pas tout.

Il bon toutefois de rappeler que WhatsApp fait la même chose depuis 4 ans et personne n'a vraiment évoqué le sujet...

@Paquito06

Ah ok merci.

@Paquito06

Je ne suis pas sûr que ce soit exact. Le schéma dans l’article indique que la liste des signatures numériques (hash) des photos pédo-pornographiques sera téléchargée sur l’iPhone et la comparaison avec les photos sur l’iPhone sera faite en local.

C’est seulement si suffisamment de photos (seuil non communiqué ?) ont une signature numérique identique qu’un drapeau est levé et qu’une vérification sera effectuée par Apple en se basant sur les photos contenues dans le cloud (si j’ai bien compris).

Les images ne seront jamais analysées en local par rapport à leur contenu; c’est une simple comparaison entre les hash dans la base MSAM et le hash des photos sur l’iPhone.

Cela signifie aussi qu’une photo avec votre enfant dans son bain ne devrait pas poser de problème, à moins, bien sûr, que cette même photo se trouve dans la base de données MSAM de photos pédocriminelles (auquel cas on pourrait raisonnablement se poser des questions …).

Ce qui confirme au passage qu'Apple a bien les clés de déchiffrage des comptes iCloud, pour pouvoir, le cas échéant, contrôler les photos indiquées comme douteuses par l'algorithme.

@r e m y

Sauf erreur de ma part, ça fait longtemps qu’Apple a accès aux clés de décryptage des données dans iCloud. Rien de nouveau dans cela.

@hdam1959

Des sauvegardes iCloud oui, mais pas des photos ni des iMessage

@r e m y

Non, un token est généré pour la photo en question quand elle est envoyée sur iCloud si elle est détectée comme étant une image pédo-pornographique et transmise à Apple. Sinon Apple n’a pas accès aux photos qui ne rentrent pas dans ce mécanisme

Non puisqu'Apple indique qu'il faut un certain nombre de tokens générés pour qu'Apple considère que ça nécessite vérification. Donc les premières photos ayant généré un token sont déjà sur iCloud. Pour qu'Apple les verifie il faut qu'ils aient la clé de déchiffrement de cette bibliothèque.

Même si ils ne vont aller y puiser QUE les photos identifiées comme suspectes, ils ont bien la clé pour accéder à tout.

@r e m y

Il y a une liste de token (= clé de déchiffrement des photos) qui est envoyé à Apple quand le seuil est atteint. Donc non Apple n’a pas un accès généralisé aux photos

@hdam1959

"Cela signifie aussi qu’une photo avec votre enfant dans son bain ne devrait pas poser de problème, à moins, bien sûr, que cette même photo se trouve dans la base de données MSAM de photos pédocriminelles (auquel cas on pourrait raisonnablement se poser des questions …)."

Absolument. Il n’y aura jamais aucun souci avec les photos prises par les parents de leurs enfants dans le bain, a la plage, etc. Sauf si, pour une quelconque raison, leurs photos se retrouvent dans la base de donnees des photos flagguees illegales.

Pourtant dans le cas rapporté par Forbes en février 2020, l'individu qu'Apple avait identifié comme envoyant des photos pedopornographiques par e-mail (par la même technique et la même base de données de référence dont on parle aujourd'hui) n'a finalement pas été inquiété, aucune charge n'ayant été retenues par le FBI à qui Apple l'avait signalé. Comme quoi, Apple peut faire des erreurs.

@r e m y

"Pourtant dans le cas rapporté par Forbes en février 2020, l'individu qu'Apple avait identifié comme envoyant des photos pedopornographiques par e-mail (par la même technique et la même base de données de référence dont on parle aujourd'hui) n'a finalement pas été inquiété, aucune charge n'ayant été retenues par le FBI à qui Apple l'avait signalé. Comme quoi, Apple peut faire des erreurs. "

Quelle en etait la cause? Du FBI pour ne pas donner suite. Car ils plaisantent pas avec ca. Soit c’etait pas assez important et ils ont refilé le dossier a des locaux, soit ca faisait parti du taff du mec, (travail d’investigation) Apple n’en sait rien mais le FBI sait, soit… y a de multiples raisons, d’où ma question.

Bon apres, il est aussi probable que ca soit une erreur d’Apple bien sûr.

Je ne sais pas, Forbes ne le précise pas

https://www.forbes.com/sites/thomasbrewster/2020/02/11/how-apple-intercepts-and-reads-emails-when-it-finds-child-abuse/?sh=1cee78431c29

Ils se contentent d'écrire "As no charges have been filed against that user, Forbes has chosen to publish neither his name nor the warrant"

Après le signalement d'Apple, un mandat de perquisition a été produit le 17 Septembre 2019 et Apple a fourni des données complémentaires de son compte iCloud ( name, address and mobile phone number that the user submitted when he signed up. The government also asked for the contents of the user’s emails, texts, instant messages and “all files and other records stored on iCloud.”). Mais au final donc... aucune charge retenue.

Ça doit être le fameux faux positif qui se produit tous les 1000 milliards de signalements..

@r e m y

A l’epoque la stat devait etre bien plus mediocre que ce 1 sur mille milliards 😅 Ou alors le FBI n’a pas pu recueillir assez d’elements egalement pour appuyer ses charges. Ca devait pas etre un gros poisson.

L’emoji famille utilisé pour illustrer un article sur la pedopornographie

🤮

La proposition d’Apple me paraît plutôt bien pensée et ceux qui protestent au nom de la liberté ou de la vie privée ne se rendent peut-être pas compte qu’ils défendent le droit de détenir des images pédo-pornographiques, alors que c’est déjà interdit.

Ce qui me semble toutefois inquiétant, c’est que cela inaugure une surveillance automatique, une forme de perquisition faite par Apple en lieu et place de la police, alors que jusqu’ici, une perquisition ne se fait pas sans l’autorisation expresse d’un juge. Je ne suis pas très calé dans les matières juridiques américaines ou même françaises, mais ça me semble un changement assez notable pour que ce soit a priori interdit, au moins jusqu’à ce qu’une loi votée par nos représentants autorise explicitement une telle pratique.

Par ce procédé, Apple présuppose que chacun des utilisateurs d'iPhone est potentiellement un délinquant et met sous surveillance (une fois generalisé) entre 1 et 2 milliards d'individus.

Aucun service de police, aucune agence de renseignement dans aucun Pays au monde n'aurait l'autorisation de le faire.

@r e m y

"Aucun service de police, aucune agence de renseignement dans aucun Pays au monde n'aurait l'autorisation de le faire. "

Euh... aucun n’aurait les moyens. Mais quand même, il y en a pas mal qui le font, parfois même après s’être donné explicitement l’autorisation (c’est d’ailleurs le travail très officiel de la NSA).

On parle de placer un mouchard dans près de 2 milliards d'iPhones! Aucune agence de surveillance , même en chine, n'a jamais osé en rêver !

@r e m y

Sur le nombre, je ne peux qu’être d’accord. C’est sur « autorisation » que je réagissais.

@r e m y

Peut-être. Mais Apple ne moucharde rien tant qu’il n’y a pas de pédocriminalité en jeu.

Rien n’est mouchardé tant qu’il n’est pas établi que des photos sur une liste noire sont détectés. C’est seulement à ce moment-là que le mouchardage commence.

Vous me direz, et je vous l’accorde, que ça prive les pédocriminels du droit au respect de leur vie privée.

Mais ça me semble exactement le but de cet effort de la part d’Apple : garantir le respect de la vie privée pour tout le monde, sauf pour les criminels.

@r e m y

« Par ce procédé, Apple présuppose que chacun des utilisateurs d'iPhone est potentiellement un délinquant et met sous surveillance »

Oui, c’est sûr j’ai fini par comprendre que je vivait très mal.

@DahuLArthropode

Ce n’est pas une question de liberté ou de vie privée. Ces deux notions extrêmement importantes doivent trouver leur limite dans celle des autres.

Le vrai problème relève de la justice, de l’équité auxquelles chacun a droit par opposition à l’arbitraire, au caprice de puissants qui cherche à plaire à leur clientèle. C’est bien à cause de cela que le débat est rempli de suspicions et de procès d’intention.

Dans ma profession, j’ai assisté au travail de commissions dirigées par des privés se montrant incapables de faire preuve de la plus élémentaire équité. Jugements de valeur, caprices, vanité ont dû être combattus par des recours aux instances judiciaires supérieures pour obtenir le respect des droits des justiciables. Il en résulte une incommensurable perte d’efficacité, d’énergie, de temps, et d’argent. Et c’est peu de le dire.

@sambucus

"Ce n’est pas une question de liberté ou de vie privée."

Si si. Carrément même.

@MarcMame

D’accord. Alors vous devez accorder la même liberté et le même droit à la vie privée aux pédocriminels que celle que vous voulez qu’il vous soit accordé. La liberté et le droit à l’intégrité des victimes doivent être également complètes.

Dans ce cas, si ces trois parties ont les mêmes droits, comment protège-t-on les personnes vulnérables ? Comment arbitre-t-on les intérêts de chaque partie ?

Ou alors, il faut admettre que même si notre droit à la vie privée et à la liberté doit être accordée à chacun, doit exister un système qui met des limites à la liberté et à la garantie du droit à la vie privée de sorte que l’on ne se retrouve pas dans un état d’abus et de barbarie dominants.

Êtes-vous favorable à la loi du plus fort au détriment du plus faible ? Est-ce cela que vous désirez ?

@sambucus

« Dans ce cas, si ces trois parties ont les mêmes droits, comment protège-t-on les personnes vulnérables ?

Comment arbitre-t-on les intérêts de chaque partie ?»

Ce n’est ni à moi, ni à toi, ni à Apple d’en décider.

—-

« Ou alors, il faut admettre que même si notre droit à la vie privée et à la liberté doit être accordée à chacun, doit exister un système qui met des limites à la liberté et à la garantie du droit à la vie privée de sorte que l’on ne se retrouve pas dans un état d’abus et de barbarie dominants. »

Tu ne peux pas mettre dans la même phrase que la vie privée et la liberté de chacun doit être accordée et en même temps dire qu’on doit mettre en place un système qui la limite.

C’est incohérent.

Il n’y a que les lois et le système judiciaire qui est compétent.

—-

« Êtes-vous favorable à la loi du plus fort au détriment du plus faible ? »

Non

——

« Est-ce cela que vous désirez ? »

Non

@MarcMame

+100%

Apple a rien a faire là-dedans, c’est aux instances compétentes de faire leurs taffs.

De plus, y’a quand même derrière ts ça, un buzz marketing, pour avoir une image « safe childrens friendly » qui me dégoûte un peu…

Bref Apple arrête, il est encore temps avant de prendre un bad buzz monumental.

@sambucus

« La liberté et le droit à l’intégrité des victimes doivent être également complètes. »

Apple ne propose vraiment pas ça.

Et même, moi je ressens ça comme une insulte qui m’active beaucoup.

Le monde du trauma n’est pas simple.

Ma liberté et mon droit à l’intégrité, c’est justement qu’en tant qu’ex victime on ne vienne pas fouiller dans mes photos, figure toi.

@Bigdidou

Apple ne « fouille » pas dans vos photos.

Elle ne prend pas de décisions juridiques non plus.

Elle ne fait que communiquer l’existence de photos à caractère criminel aux autorités compétentes lorsque ces photos sont stockées sur les serveurs d’Apple (iCloud).

Faut-il le rappeler : d’une façon générale, dans le cadre de cette nouvelle politique, Apple ne va pas « regarder » le contenu de vos photos. Elle ne fait que vérifier si l’empreinte numérique des photos de votre iPhone correspond à celles de photos criminelles recensées sur CSAM.

Si c’est le cas, et seulement dans cas, elle va procéder à une vérification visuelle du contenu pour s’assurer qu’il n’y a pas eu d’erreur. À cette étape, des photos introduites illégitimement dans la base de données seraient invalidées et le processus arrêté.

Le système n’est pas parfait. Mais face à une situation complexe, il me semble que les solutions retenues représentent un compromis acceptable entre le laisser-aller et la surveillance excessive.

@Bigdidou

Je comprends que notre dialogue est le produit de votre légitime douleur qui se confronte à l’expérience d’un ancien professionnel chargé de faire accéder les victimes à la protection et aux soins. Croyez que je suis navré de ce qui vous est arrivé, bien que nous ne nous connaissons pas. Je n’avais aucune intention de vous faire mal.

@sambucus

« Croyez que je suis navré de ce qui vous est arrivé, bien que nous ne nous connaissons pas. Je n’avais aucune intention de vous faire mal. »

Ah, mais non, pas du tout, zéro souci, c’était une réflexion générale ;)

Je bosse aussi pour l’accès au soins des gens TDI/traumas (souvenirs complexes sévères) tout en étant du même bord qu’eux.

C’est pas pour autant que j’ai la même vision des choses.

En fait, c’était juste pour dire que quelque chose le mettait profondément mal à la ide dans cette histoire sans comprendre quoi.

Et unau réalise hier ou avant hier que le fait que quelq’un ou une institution prétendent chercher chez moi des images pedopornographiques faisait un écho très activant à la propre histoire.

Je ne suis du coup pas très objectif…

(Fausse manip)

Ça me convainc assez. Et il vaut mieux qu'une entreprise comme Apple, en qui j'ai à priori confiance (pas comme Microsoft !) expose ce qu'elle compte faire et comment, plutôt que d'autres comme Google qui le font en espionnant votre vie et vos photos SANS VOUS LE DIRE.

Il y a un gouffre entre les deux attitudes. On se trompe de combat en attaquant Apple. C'est Google et Facebook qu'il faut bombarder de critiques.

@Cyrille50

"Et il vaut mieux qu'une entreprise [...]"

———-

Non.

Pas la peine d’aller plus loin.

NON !

Ce qui est paradoxal c’est que d’un côté ils prônent la confidentialité et aucune backdoor pour les gouvernements et d’un autre je vais m’occuper de tes photos parce qu’il y a des gros pervers. Si on ferme tout, y compris pour les terroristes, alors no way.

Pas de surveillance et puis c’est tout.

Pages