Lutte contre la pédopornographie : Apple tente d'éteindre l'incendie avec une FAQ 🆕

Le moins qu'on puisse dire, c'est qu'Apple n'a pas su convaincre du bien fondé de ses nouvelles mesures pour lutter contre les abus sexuels des enfants. Dévoilés jeudi dernier, ces mécanismes ont provoqué une levée de boucliers de chercheurs en sécurité et d'organisations de défense de la vie privée.

Devant la bronca (prévisible) suscitée par cette affaire, Apple a prévu de communiquer tous azimuts et cela s'incarne dès aujourd'hui avec une foire aux questions que le constructeur aurait été bien avisé de publier dès l'annonce de ces mesures.

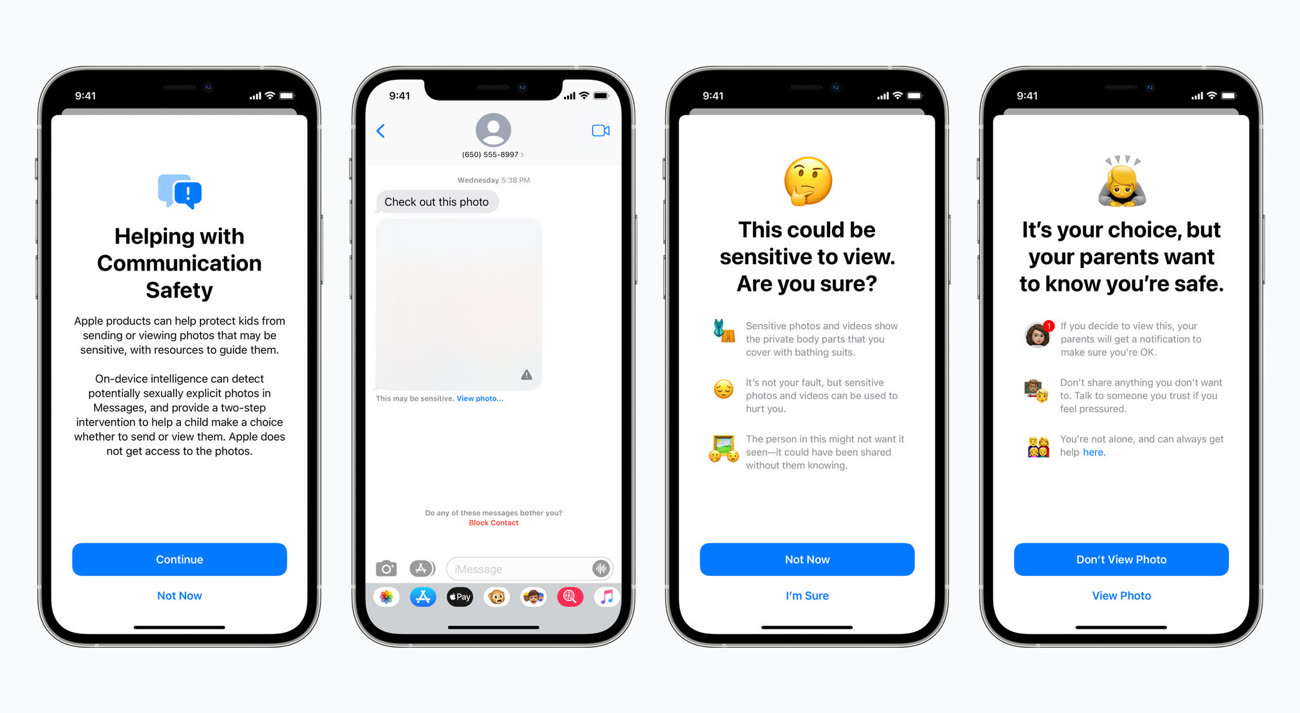

Le système de floutage des images dans Messages

En préambule, Apple éclaircit une première incompréhension : le système de floutage des photos sexuellement explicites dans Messages et celui qui détecte les photos pédopornographiques dans la bibliothèque iCloud sont différents et n'utilisent pas la même technologie.

Dans Messages, après activation de la fonction depuis les réglages du partage familial, les photos reçues ou envoyées sur l'appareil iOS d'un enfant enregistré au sein d'un partage familial sont analysées en local et floutées en cas de présence d'éléments explicites. Les parents peuvent être prévenus par notification du partage de la photo, mais uniquement pour les enfants de moins de 12 ans (c'est une option à activer) ; il n'y aura pas de notification pour les enfants de 13 à 17 ans.

Cette fonction de floutage se réalise en local et « Apple n'accède jamais aux communications » dans Messages. Le chiffrement des communications dans la messagerie est toujours réalisé de bout en bout, rien ne change ici.

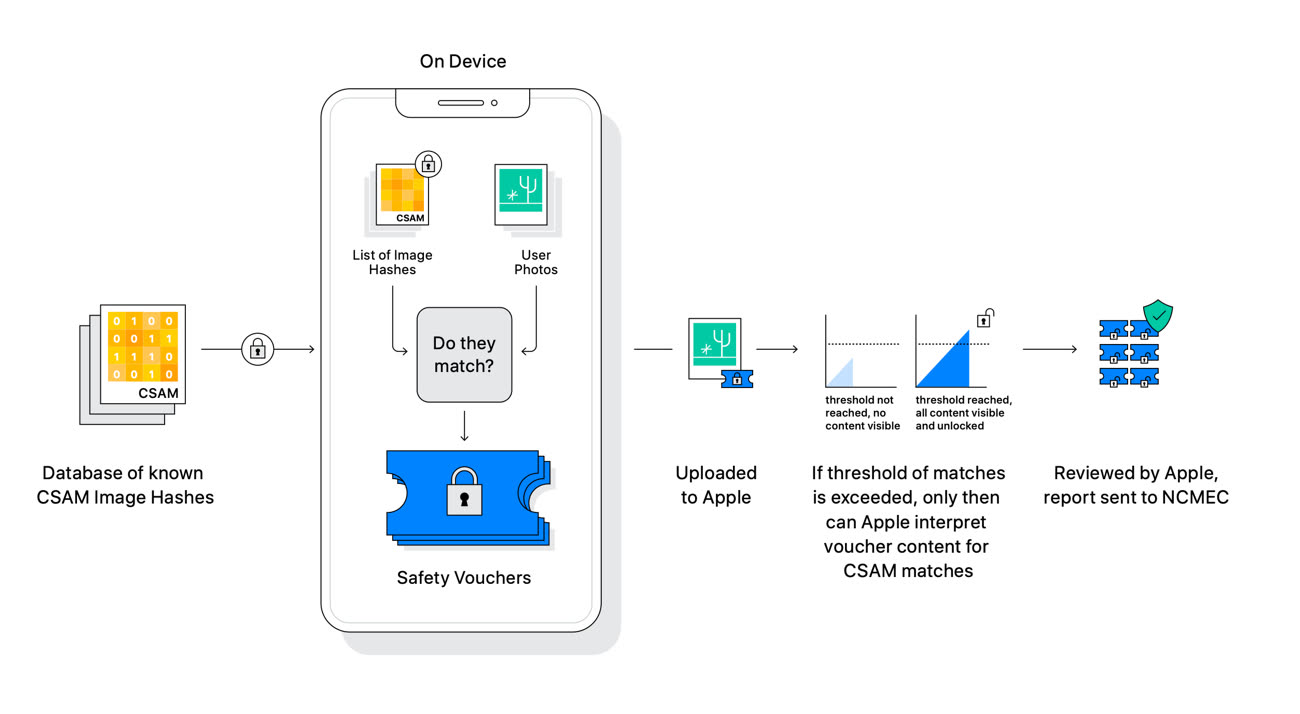

Le système de détection des photos dans la bibliothèque iCloud

Le système de détection des photos d'abus sexuels d'enfants (CSAM pour Child Sexual Abuse Material) n'a rien à voir avec celui de Messages. Apple souligne en préambule que ce mécanisme ne concerne que les photos téléversées dans la bibliothèque iCloud Photos. « Le système ne fonctionne pas pour les utilisateurs ayant désactivé la bibliothèque iCloud », martèle le constructeur.

Apple rappelle le principe global de détection CSAM. En local, il compare les photos de l'utilisateur à la base de données du National Center for Missing and Exploited Children (NCMEC), une association à but non lucratif, seule organisation habilitée à posséder de tels documents (leur possession est interdite dans de nombreux pays). Attention, Apple ne va pas télécharger sur des millions d'iPhone les photos de cette base de données, uniquement leurs hashes, c'est à dire des suites de chiffres.

« En utilisant de nouvelles fonctions cryptographiques, Apple est capable d'utiliser ces hashes pour savoir si les comptes iCloud Photos stockent des collections de photos qui correspondent aux images CSAM, et uniquement les images CSAM », précise le constructeur. Ce dernier ne saura rien des autres données stockées sur l'appareil.

Si Apple a pris la route d'une détection qui se déroule d'abord en local puis sur ses serveurs, c'est pour éviter les « risques sur la confidentialité » que font peser les autres systèmes utilisés par d'autres entreprises qui examinent les photos de leurs utilisateurs uniquement dans le nuage. « La détection CSAM dans iCloud Photos offre des bénéfices significatifs pour la vie privée, en empêchant Apple d'en apprendre davantage sur les photos des utilisateurs, à moins que celles-ci ne correspondent à des images CSAM ».

Apple cherche également à apaiser les craintes très fortes sur la sécurité de ses appareils et la confidentialité des utilisateurs. Le constructeur assure que son système ne peut servir à détecter autre chose que des images CSAM, et il faudra croire l'entreprise sur parole : « Apple refusera les demandes » des gouvernements qui voudront ajouter des images non-CSAM à la liste de hashes.

« Nous avons reçu des demandes de gouvernements pour bâtir et déployer des changements [dans la sécurité d'iOS] qui dégradent la vie privée des utilisateurs », déroule la FAQ. « Nous avons catégoriquement refusé ces demandes. Nous continuerons à les refuser à l'avenir. Soyons clairs, cette technologie se limite à la détection d'images CSAM stockées dans iCloud et nous n'accèderons à aucune demande d'un gouvernement pour l'étendre ».

Les promesses n'engageant que ceux qui y croient, Apple devra donner des gages sur ce point car ce qui se passe en Chine n'est guère encourageant.

Censure, sécurité des données : les compromissions d'Apple en Chine

Le système a été conçu de telle sorte que les hashes d'images « non CSAM » ne puissent être injectés dans la base de données : tous les iPhone et iPad recevront les mêmes hashes, donc les attaques ciblant des individus seront impossibles. Enfin, Apple précise qu'en cas de signalement, c'est un humain qui prend la relève et vérifie si la photo en question est bien litigieuse. La probabilité que le système signale de manière incorrecte un compte iCloud est « inférieure à un sur mille milliards par an ».

Mise à jour 20h30 — Dans une nouvelle séance de questions/réponses avec la presse US, Apple a indiqué que les fonctions de protection de l'enfance (pour Messages et la détection de photos pédopornographiques) pourraient être proposées à des éditeurs tiers. Par exemple, la fonction de floutage des photos sexuellement explicite pourrait être disponible dans WhatsApp, Instagram ou encore Snapchat. La détection des photos CSAM fonctionnerait avec d'autres nuages que celui d'iCloud.

Au vu de la réception pour le moins glaciale réservée par la concurrence à ces mesures (chez le patron de WhatsApp, par exemple), il n'est pas certain que l'on retrouvera de si tôt ces mécanismes ailleurs que chez Apple.

"La probabilité que le système signale de manière incorrecte un compte iCloud est « inférieure à un sur mille milliards par an »."

J'aimerais bien savoir comment est calculé ce chiffre. Sûrement à partir du taux de faux positifs divisé par le nombre de détections nécessaires pour déclencher une procédure et multiplié par le nombre de photos par compte en moyenne. Je préférerais quand même avoir le détail de tous ces chiffres.

Quand je vois les gens lever leur bouclier face à une mesure qui protège les enfants je me demande bien ce qu'ils ont comme photos sur leur iPhone.

@cosinusix

"Quand je vois les gens lever leur bouclier face à une mesure qui protège les enfants je me demande bien ce qu'ils ont comme photos sur leur iPhone."

Tu as une petite idée non ?

@cosinusix

Des dessins de Winnie l’Ourson et des photos de Tian'Anmen. Cf https://www.bbc.com/news/blogs-china-blog-40627855

Merci pour les sous-entendus, ça fait toujours plaisir.

La protection des enfants a bon dos. Avec le même argument, on criminalise les LGBT (cf Hongrie), on interdit aux femmes de sortir ou travailler (elles doivent être mères et s’occuper des enfants), on interdit les relations hors mariage (ne permet pas des familles stables), etc…

ça va venir. pas par les mêmes mais ça va venir. le monde n'est qu'un éternel retour.

🇨🇳 : Nous aimerions accéder à votre algorithme de détection de photos.

: NON ! La vie privée de nos utilisateurs est une valeur que nous défendrons jusqu’à…

🇨🇳 : Vos produits seront donc taxés à +180%

: Le code d’accès à la database c’est APPLE0101 mdr déso

@Arf1

Tellement…

J’attendais cet article pour me faire un avis de la situation. Il est vrai qu’il est surprenant qu’Apple mette en place un tel système. Cela dit, se proclamant défenseur de la vie privée, il semblerait qu’il y ait un réel besoin de régulation d’images pedopornographique. Sinon Apple ne le ferait pas. Il est rassurant de voir que la méthode appliquée semble être bien encadrée. Si Apple, comme elle le déclare, refusera à l’avenir catégoriquement toute demande gouvernementale alors ça va.

Ce que j’ai trouvé vraiment étonnant par contre c’est la réaction des gens à cette annonce avec certains qui se disent prêt littéralement à changer de marque « juste » pour cette histoire. Sauf qu’en fait cela ne change rien : si déjà l’algorithme de reconnaissance d’image se trompe alors au pire un humain verra bien que votre photo n’est pas sensible (sauf si elle l’est bien 👀). Je ne me fais pas d’inquiétude sur cela : cette affaire sombrera bientôt dans « l’oubli » vous verrez. L’idée de voir déjà plein de gens sur Reddit se disant scandalisés par cette mesure et changeant de marque c’est vraiment stupide : il pense vraiment qu’ils vont trouver mieux ailleurs.

« La détection CSAM dans iCloud Photos offre des bénéfices significatifs pour la vie privée, en empêchant Apple d'en apprendre davantage sur les photos des utilisateurs, à moins que celles-ci ne correspondent à des images CSAM »

Cette partie ne me convainc pas, mais alors pas du tout.

Je ne vois rien qui les empêcherait de faire sur leur serveur la même chose que ce qu’ils veulent faire sur iPhone.

Même pire, je trouve cette entêtement à ajouter une outil d’analyse sur chaque iPhone plutôt suspect.

Un outil d’analyse sur le cloud ne sert a rien si on n’utilise pas le cloud. Un outil d’analyse sur le téléphone mais qui s’active que si le cloud fonctionne, il suffit de modifier son mode d’activation. Sans parler du fait qu’il scanne les photos mais peut scanner n’importe quoi demain…

J’y connais pas grande chose mais j’ai une question. Qu’est-ce que Apple y gagne ? Cela doit être infiniment plus grand que le risque de perdre en crédibilité dans le message qu’elle prône depuis des années « le respect de la vie privée est important pour nous ».

@Albatros86

Qu’est-ce qu’Apple y gagne? Pour autant que je sache, rien. Au contraire elle a tout a y perdre.

Maintenant, il doit être extrêmement compliqué de dire constamment « pas question » a des agences gouvernementales, y compris celles de son pays, qui font pression en permanence pour obtenir des backdoors, et qui sont prêtes a tout pour les obtenir.

Au bout d’un moment, ça doit être intenable, et il ne reste plus qu’à céder en tentant de ne pas perdre la face.

Mais quiconque a déjà eu l’occasion de discuter avec un flic, ou un avocat, ou un juge sait que les criminels sexuels sont extrêmement prudents et retors (ou leur « carrière » est très breve) et qu’ils sont des utilisateurs du dark web plutôt que de whatsapp et facebook.

Donc le coup de pervers pépère qui échange des photos de gamins tous nus, j’y crois moyen. Il va bien en avoir un ou deux parmi les plus dégénérés qui vont se faire serrer, mais la grande majorité ( et elle est plus nombreuse que ce que je pensais) va passer à travers les mailles du filet.

La veritable question qui devrait nous turlupiner, c’est : que se passera t’il demain, si le parti extrémiste X ou Y arrive au pouvoir, qu’il fait voter une loi obligeant toute entreprise présente sur le territoire à mettre à disposition des forces de l’ordre « sans limite, et sans délai, tout moyen ou mesure pouvant contribuer à la sécurité nationale », et qu’ensuite promulgue un décret disant que les personnes détestant les pizza hawaïennes sont un danger pour la nation?

On en est loin, des photos de gosses. Mais les politiciens pas très démocrates (au sens large) savent tres bien que l’un des leviers les plus efficaces de la manipulation de masse c’est de mettre « danger » et « enfant » dans la meme phrase. Nous sommes des mammifères, et notre cerveau est câblé de telle sorte que nous basculons en mode alerte, voire panique quand notre progéniture court un risque.

EDIT.

J’ai interrompu la redaction de ce post pour chercher des chiffres sur le net. Mal m’en a pris. C’est à vomir. Mais raison de plus pour ne pas se satisfaire de mesures dont on sait qu’elles sont inefficaces.

Exemple: https://www.lemonde.fr/police-justice/article/2020/01/24/un-reseau-mondial-de-pedopornographie-ayant-fait-des-milliers-de-victimes-juge-en-belgique_6027137_1653578.html

Besoin d’un verre que quelque chose de fort.

@f3nr1l

Comment faire une bdd de pizza hawaïenne ? C’est impossible il y a trop d’images et elles ne circulent pas beaucoup. C’est un hash, pas une détection d’image.

Pour faire une bdd efficace, il faut peu d’images et suffisamment de circulation de chaque image pour les trouver

> « Nous avons catégoriquement refusé ces demandes. Nous continuerons à les refuser à l'avenir. […] et nous n'accèderons à aucune demande d'un gouvernement pour l'étendre ».

Aha!

Sauf que, contrairement à avant, ils ont prouvé qu’ils sont capables de le faire. Il est beaucoup plus facile de refuser une injonction quand on peut prétendre être incapable d’y accéder. Ce n’est plus le cas.

Et autant la naïveté qu’ils affichent est touchante, autant le gouvernement chinois n’a pas hésité à s’en prendre violemment à sa propre industrie tech (Ali Baba, Didi, Tencent & co). Alors une entreprise étrangère ?

Que dira Apple si une nouvelle loi interdit la commercialisation de smartphones ne recherchant pas et ne rapportant pas au gouvernement la présence de dessins de Winnie l’Ourson ou de photos de Tian'anmen parmi les photos de leurs utilisateurs ?

Si la Hongrie décide de faire sa propre base de donnée CSAM et décide qu’elle doit aussi inclure des "images LGBT" pour "préserver les enfants" ?

Qu’est-ce qui a changé par rapport à avant ? Ils ont prouvé que c’était possible, qu’ils en sont techniquement capables, et que ce n’est qu’une question de volonté.

Sérieusement, Putin, Xi, ou dans une moindre mesure Duterte, s’en moquent de bannir une marque étrangère de leur marché. Fichtre, ça pourrait même faire office d’exemple pour les autres. Tout ce qui compte, c’est de rester au pouvoir.

Je me demande d’ailleurs ce qu’Apple fait avec iMessage concernant la nouvelle réglementation indienne, et fera vis-à-vis de la nouvelle "ePrivacy Derogation" européenne. Parce que le système en place ici m’a l’air insuffisant.

Si l’UE arrive à la même conclusion, ils vont se battre au tribunal. Et s’ils perdent ? Apple quittera le marché européen ? Apple retirera iMessage des iPhone en Europe ? Ou est-ce qu’Apple pliera, ouvrant encore davantage la boîte de Pandore pour tous les amateurs de discours sécuritaires et dictateurs en herbe du monde ?

@ElFitz

Je crois que tu n’a pas compris comment ça fonctionnait.

Je pense que macg a complètement foiré tous ces articles sur le sujet pour qu’il y ait une telle incompréhension.

Bon ben je sens que je ne vais plus pouvoir partager mes albums de « Martine... » 😭

@MarcMame

Les photos de Martine sont dans la base CSAM? Si oui, posséder les albums coûter cher 🤣

Encore le système dans Message est plutôt bien foutu dans le cadre du contrôle parental, celui avec le CSAM est bien plus litigieux

@Hideyasu

C’est l’inverse. La détection iMessage peut se planter, pas le hash csam.

Pages