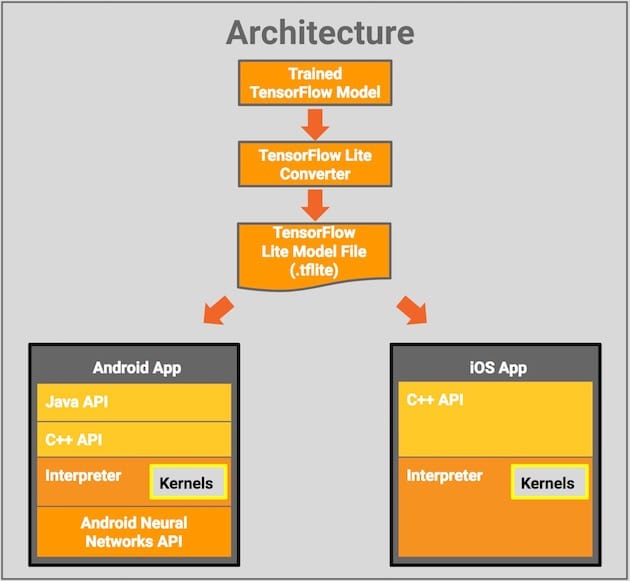

Google et Apple ont chacun leurs technologies mobiles d’apprentissage automatique, qui ne recouvrent pas exactement les mêmes choses. Sur Android il y a TensorFlow Lite, qui permet de créer et de faire tourner des modèles d’apprentissage automatique (réseaux neuronaux, modèles linéaires, arbres de décision…). Sur iOS il y a Core ML, qui sert uniquement à intégrer dans des applications des modèles déjà prêts.

Ces deux technologies se rapprochent maintenant avec la prise en charge de TensorFlow Lite par Core ML. Concrètement, les développeurs disposent d’un nouvel outil pour convertir les modèles TensorFlow Lite (.tflite) en modèles Core ML (.mlmodel) pour ensuite les déployer dans des applications iOS.

Google, qui a collaboré avec Apple sur cette prise en charge, fait ainsi de TensorFlow Lite une grande porte d’entrée pour l’apprentissage automatique sur mobile.