L’une des principales raisons qui ont poussé Apple à abandonner Intel en faveur de ses propres puces se compte en nanomètres. Le fondeur a eu beaucoup de mal à affiner la gravure de ses processeurs, ce qui est l’une des explications pour justifier le ralentissement des progrès en termes de performance ces dernières années. Et c’est aussi l’une des justifications derrière le retour réussi d’AMD, qui bénéficie de l’expertise de TSMC pour les gravures les plus fines.

TSMC s’impose toujours davantage sur ce marché et le fondeur taïwanais aurait battu Samsung sur un autre marché. Qualcomm devait à la base travailler avec le constructeur coréen pour produire le Snapdragon 875G, un futur SoC gravé à 5 nm. Sauf que la branche dédiée aux semi-conducteurs de Samsung ne parviendrait pas à atteindre la productivité nécessaire pour ce contrat. Le taux de déchets serait encore trop important, si bien que Qualcomm aurait finalement donné le contrat à TSMC.

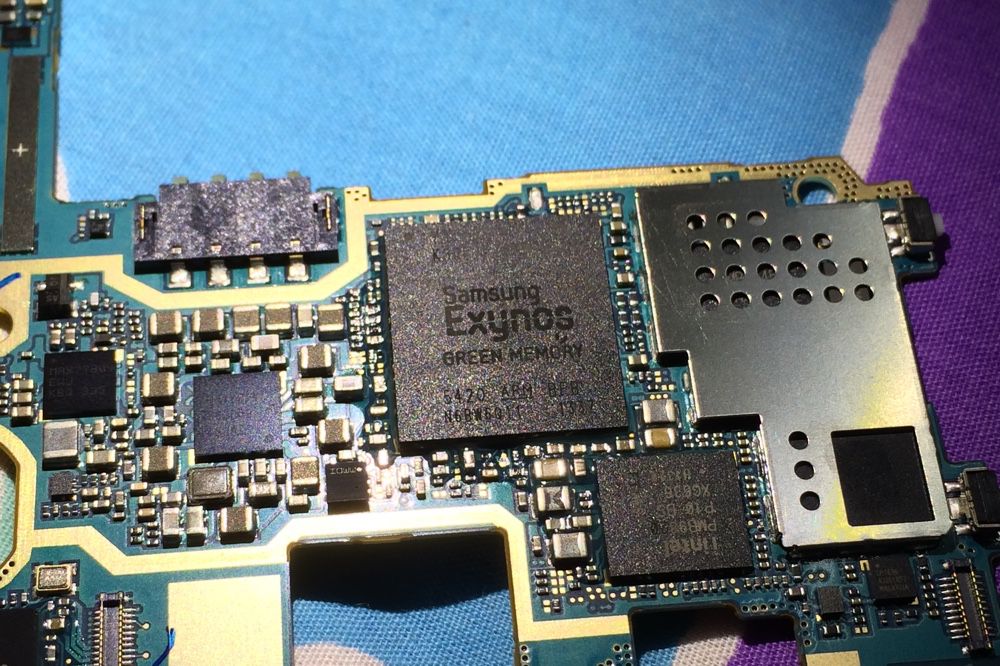

Un autre signe que la gravure à 5 nm n’est pas au point chez Samsung est à chercher du côté des Note 20 qui viennent d’être présentés. On les attendait avec un processeur maison Exynos reposant sur cette finesse de gravure, ils sont finalement arrivés avec un modèle d’ancienne génération, toujours gravé à 7 nm.

D’après les rumeurs, la gravure à 5 nm proposée par TSMC sera prête pour les Apple A14 qui seront utilisés dans les iPhone de 2020 et aussi pour leurs variantes destinées aux premiers Mac Apple Silicon. La firme de Cupertino avait été aussi parmi les tous premiers sur le 7 nm, introduit avec l’Apple A12 des iPhone XS. Et pendant ce temps, TSMC a commencé ses recherches pour graver à 2 nm…

Source :