On savait que les enceintes intelligentes pouvaient présenter des risques en matière de respect de la vie privée, on apprend maintenant qu'elles peuvent poser des problèmes de sécurité. Un groupe de scientifiques a découvert que les assistants vocaux étaient vulnérables à une attaque exploitant des lasers pour leur faire exécuter des commandes.

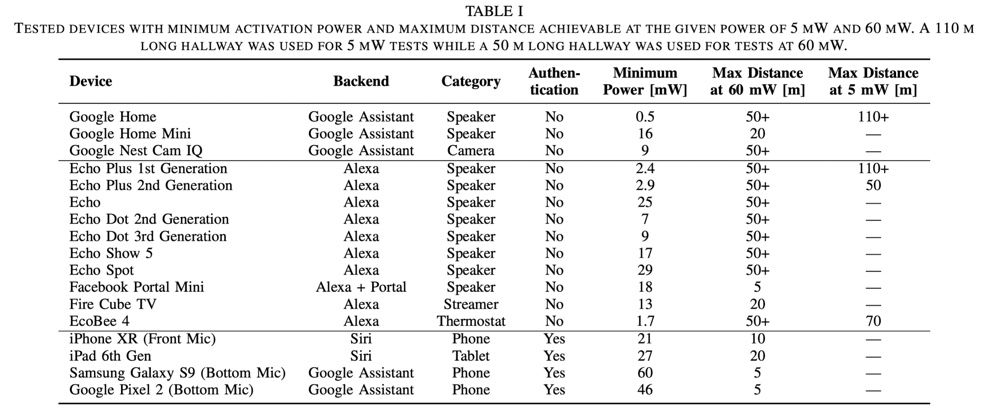

Dans leur étude « Light Commands : Laser-Based Audio Injection Attacks on Voice-Controllable Systems » rapportée par Ars Technica, les chercheurs démontrent que l'on peut contrôler des enceintes intelligentes à l'aide de « commandes lumineuses », jusqu'à 110 mètres de distance, avec la vue débouchée.

Les microphones qui exploitent des MEMS, des puces minuscules électromécaniques, peuvent interpréter par erreur la lumière comme s'il s'agissait de son. En modulant l'amplitude de lasers et en les pointant sur le micro de plusieurs enceintes, les chercheurs ont réussi à tromper le micro des appareils et à leur faire exécuter différents types de commandes.

Les enceintes intelligentes ne sont pas les seuls appareils vulnérables à ce genre d'attaque, c'est également le cas des smartphones, mais de par leur nature, elles sont plus exposées. L'attaque fonctionne contre le Google Home, le Google Home Mini, la caméra Nest Cam IQ, différents modèles d'Amazon Echo, le Facebook Portal Mini, ainsi que l'iPhone XR et l'iPad 6, entre autres. Le HomePod ne fait pas partie de l'étude.

Les scientifiques de l'University of Electro-Communications de Tokyo et de l'University of Michigan prennent l'exemple d'un malandrin équipé d'un laser qui, à travers une vitre, demanderait à une enceinte intelligente d'ouvrir la porte de la maison. On peut aussi imaginer que le brigand en profite pour désactiver la caméra de surveillance.

Bien qu'il puisse être réalisé avec du matériel facile à se procurer (l'une des démos a été réalisée avec un pointeur laser tout ce qu'il y a de plus banal, un driver de diode laser et un ampli audio), le piratage présente plusieurs contraintes importantes, la première étant que le pillard doit avoir en vue l'appareil ciblé. Ensuite, il doit viser très précisément le micro de l'appareil, après quoi l'appareil répondra à voix haute, ce qui attirera l'attention de l'utilisateur, si celui-ci est dans les parages.

Ces commandes lumineuses soulèvent néanmoins le problème des assistants vocaux qui exécutent des actions potentiellement sensibles sans authentification. Et quand bien même certaines actions requièrent un code vocal, comme il est possible de le demander quand on réalise un achat avec Alexa, les chercheurs ont trouvé qu'il était possible de découvrir le code grâce à une attaque par force brute.

Les fabricants ont plusieurs pistes à leur disposition pour bloquer ou affaiblir ce type d'attaque. L'une serait d'ajouter une couche d'authentification pour les commandes sensibles en demandant par exemple à l'utilisateur de fournir la réponse correcte à une question secrète ou aléatoire. Une autre serait de cacher les micros de la lumière ou bien de ne prendre en compte la requête que si plusieurs micros la captent, ce qui compliquerait singulièrement les commandes lumineuses.

Bien que la menace réelle soit très faible, il n'y a aucune histoire connue de piratage de ce type à l'heure actuelle, vous pouvez dès à présent prendre quelques mesures pour améliorer la sécurité et la confidentialité de votre enceinte intelligente. Si celle-ci dispose d'un bouton pour couper son micro (ce n'est pas le cas du HomePod), utilisez-le pour rendre l'appareil sourd quand vous ne vous en servez pas. Sur le HomePod, vous pouvez désactiver les requêtes personnelles, qui permettent d'envoyer des messages vocalement, notamment. Avec Alexa, vous pouvez définir un code de sécurité qui sera requis pour passer des commandes.

Amazon et Google ont déclaré à Ars Technica mener une investigation en collaboration avec les chercheurs. Apple et Facebook n'ont pas fait de commentaire à ce stade.