Après avoir donné une voix et des oreilles à Gemini, Google lui donne des yeux. Gemini Live, le mode vocal de l’IA accessible dans l’app mobile, peut maintenant voir le monde en exploitant la caméra de votre iPhone ou de votre smartphone Android. Cette fonctionnalité est déployée pour tous les utilisateurs à partir d’aujourd’hui (elle n’est pas encore arrivée chez nous pour le moment).

Avec cette nouvelle capacité visuelle, l’IA est capable de décrire en temps réel votre environnement et de répondre (plus ou moins bien) à toutes les questions contextuelles que vous lui posez. Jusqu’à présent, cette fonction était réservée aux Pixel. Google avait d’ailleurs utilisé cette exclusivité pour se moquer de l’iPhone dans une publicité.

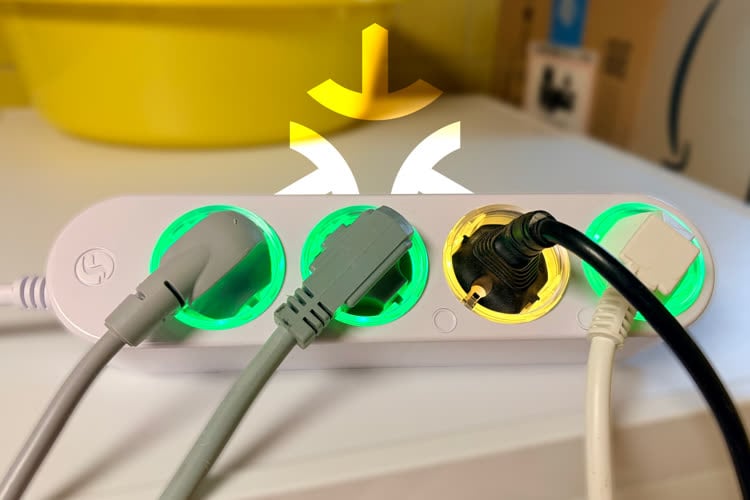

Les iPhone compatibles avec Apple Intelligence ont une fonction similaire, Visual Intelligence, mais celle-ci est largement en retrait sur deux points essentiels : il faut d’abord prendre une photo de l’élément visé pour qu’il soit analysé, et c’est souvent ChatGPT qui est appelé à la rescousse pour l’interprétation. En plus de la caméra de l’iPhone, Gemini Live peut aussi disséquer ce qui se trouve sur son écran.

Dans les prochaines semaines, l’assistant deviendra encore plus pratique en communiquant avec d’autres services de Google. Par exemple, rien qu’en pointant un carton de rendez-vous, il pourra ajouter l’événement directement dans Google Calendar. Des intégrations sont également prévues avec Google Maps, Tasks et Keep.

L’app Google Gemini disponible sur iOS avec Gemini Live pour des conversations (presque) naturelles