Depuis le S21 Ultra, les smartphones phares de Samsung sont particulièrement doués pour prendre des photos de la Lune. L'astre est tellement détaillé que cela parait suspect pour un cliché pris avec un téléphone. Le fabricant triche-t-il ?

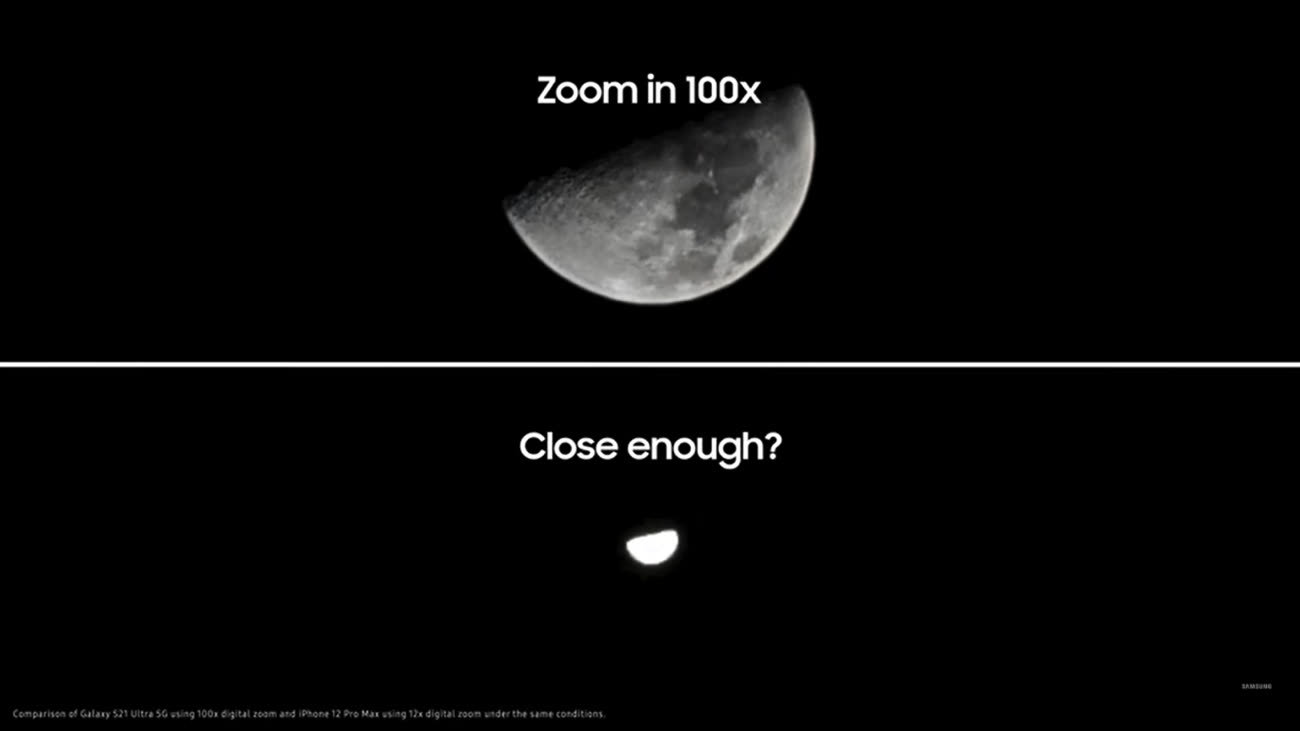

Le débat a été relancé récemment sur Reddit par un internaute qui a obtenu avec son S23 Ultra une Lune nette alors qu'il avait pris en photo une image du satellite toute floue et toute petite (170 x 170 pixels). Autant dire que le zoom numérique x100 de l'appareil n'explique pas tout dans cette capacité surprenante à révéler des détails là où il n'y en a pas.

Alors que cette démonstration éloquente a suscité beaucoup de commentaires, Samsung a publié hier un billet de blog révélant le tour de magie. Les explications ne sont en fait pas véritablement nouvelles car il s'agit d'une traduction d'un billet coréen paru l'année dernière, mais devant l'ampleur de la controverse, le fabricant se devait de communiquer de nouveau.

Pour commencer, ces photos détaillées de la Lune ne fonctionnent que lorsque plusieurs conditions sont réunies. Il faut que la fonction Optimiseur de scène soit activée (elle l'est par défaut) et que le mode Super Résolution soit lui aussi en route (pour cela, il faut pousser le zoom numérique à 25x ou plus).

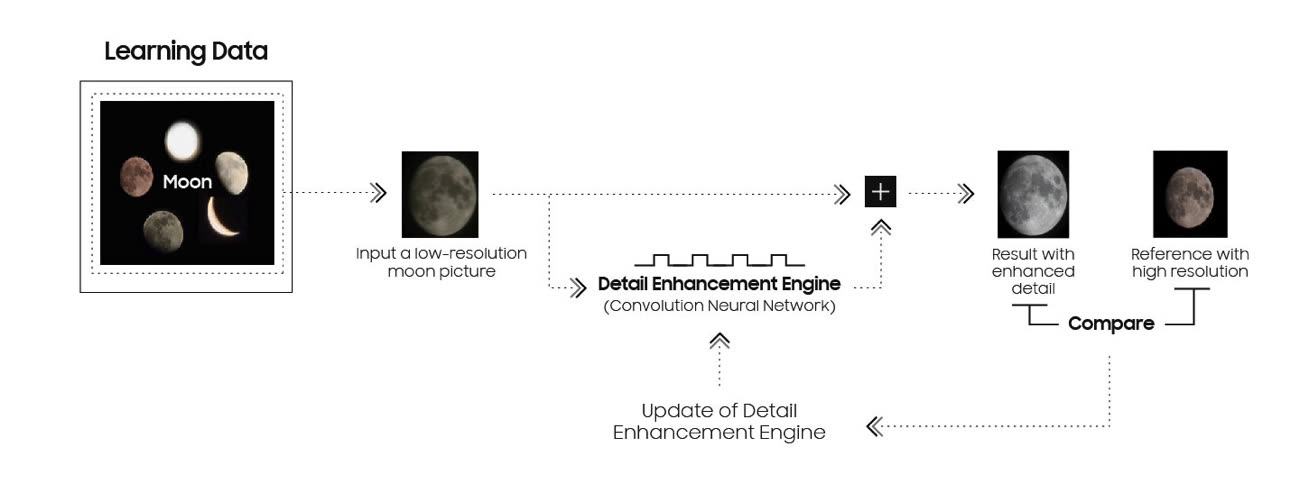

Ce mode fusionne plus d'une dizaine de clichés pris en rafale pour améliorer la netteté du sujet capturé à grande distance. Quant à l'Optimiseur de scène, il se charge d'identifier la Lune grâce à un entraînement réalisé en amont (deep learning dans le jargon de l'intelligence artificielle) sur des tonnes d'images du satellite. Samsung précise à cet endroit que les nuages peuvent affecter l'identification de la Lune.

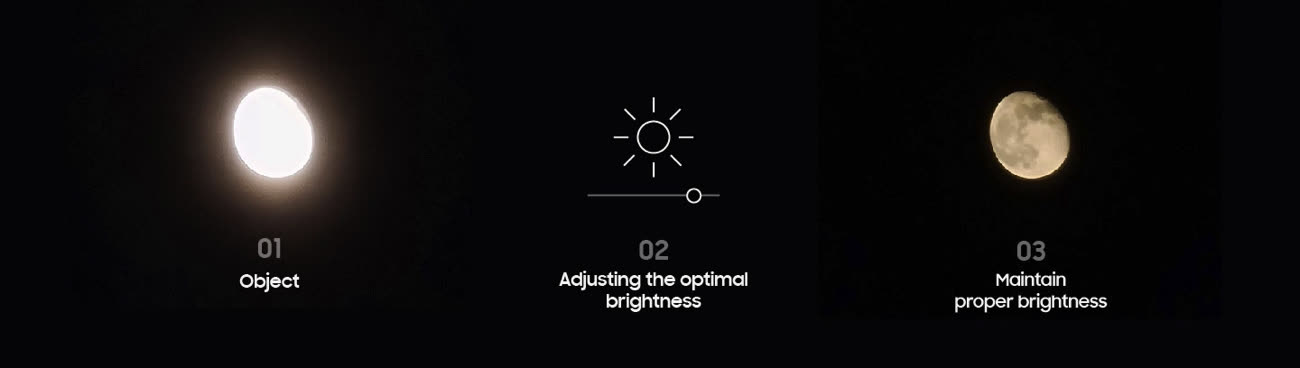

Une fois que la Lune est identifiée, tout un tas d'ajustements photographiques sont effectués. L'exposition est réglée de telle sorte que la Lune ne soit pas surexposée et la mise au point est fixée sur celle-ci. Samsung tire aussi parti de ses stabilisateurs optique et numérique pour éviter autant que possible un flou. Mais ça n'explique toujours pas comment le S23 Ultra parvient à ajouter des détails là où il n'y en a pas.

On y arrive enfin. Une fois que l'utilisateur a appuyé sur le bouton pour prendre la photo, l'Optimiseur de scène revérifie qu'il s'agit bien de la Lune. Si c'est bien le cas, le smartphone prend plusieurs images à différentes expositions, les combine (le principe est le même pour le Smart HDR de l'iPhone) et exploite ensuite « le moteur d'amélioration à base d'IA de l'Optimiseur de scène pour éliminer efficacement le bruit restant et améliorer encore plus les détails de l'image. »

En somme, même si cela ne faisait plus aucun doute, Samsung confirme ajouter des détails grâce à un modèle d'intelligence artificielle entraîné exprès pour ça. Comme plusieurs tests l'ont montré, le fabricant ne se contente pas de remplacer la « vraie » Lune par n'importe quelle lune plus nette, il analyse finement la Lune capturée pour en proposer une version détaillée correspondante — c'est bien la face visible dans le ciel qui se retrouve sur la photo.

Même si ces explications permettent de comprendre le pouvoir surprenant des Galaxy Ultra, elles ne closent pas le débat. Est-il normal que le S23 Ultra révèle des détails sur un élément qui n'en a pas à la base ? La réponse est bien évidemment non. Samsung le reconnait en déclarant qu'il va faire en sorte d'améliorer son Optimiseur de scène afin qu'il ne confonde pas une prise de vue de la vraie Lune et une capture d'une simple image de la Lune.

Au-delà de ce cas particulier, le tour de passe-passe de Samsung pose la question du rôle de l'informatique dans la photographie : jusqu'où doit aller la « photographie computationnelle » qui abolit la frontière entre le logiciel et le matériel ? À quel moment une photo n'est-elle plus réelle ? Si l'exemplaire lunaire Samsung est l'un des plus marquants, tous les autres fabricants exploitent des techniques similaires à des degrés divers. Les Éclairages de portrait de l'iPhone ne font rien d'autre que simuler des éclairages de studios photo. Alors jusqu'à quel point voulons-nous que nos smartphones créent ou recréent du « réel » ? La question reste ouverte.