Lancée en 2015 comme une plateforme d'entraide entre personnes non voyantes ou malvoyantes et volontaires voyants, l'application iPhone Be My Eyes accueille depuis quelques mois un nouveau bénévole disponible à n'importe quelle heure du jour ou de la nuit : GPT-4V. Le dernier modèle d'OpenAI, doté d'une fonction de vision, est mis à profit pour décrire précisément l'environnement des personnes ayant une déficience visuelle.

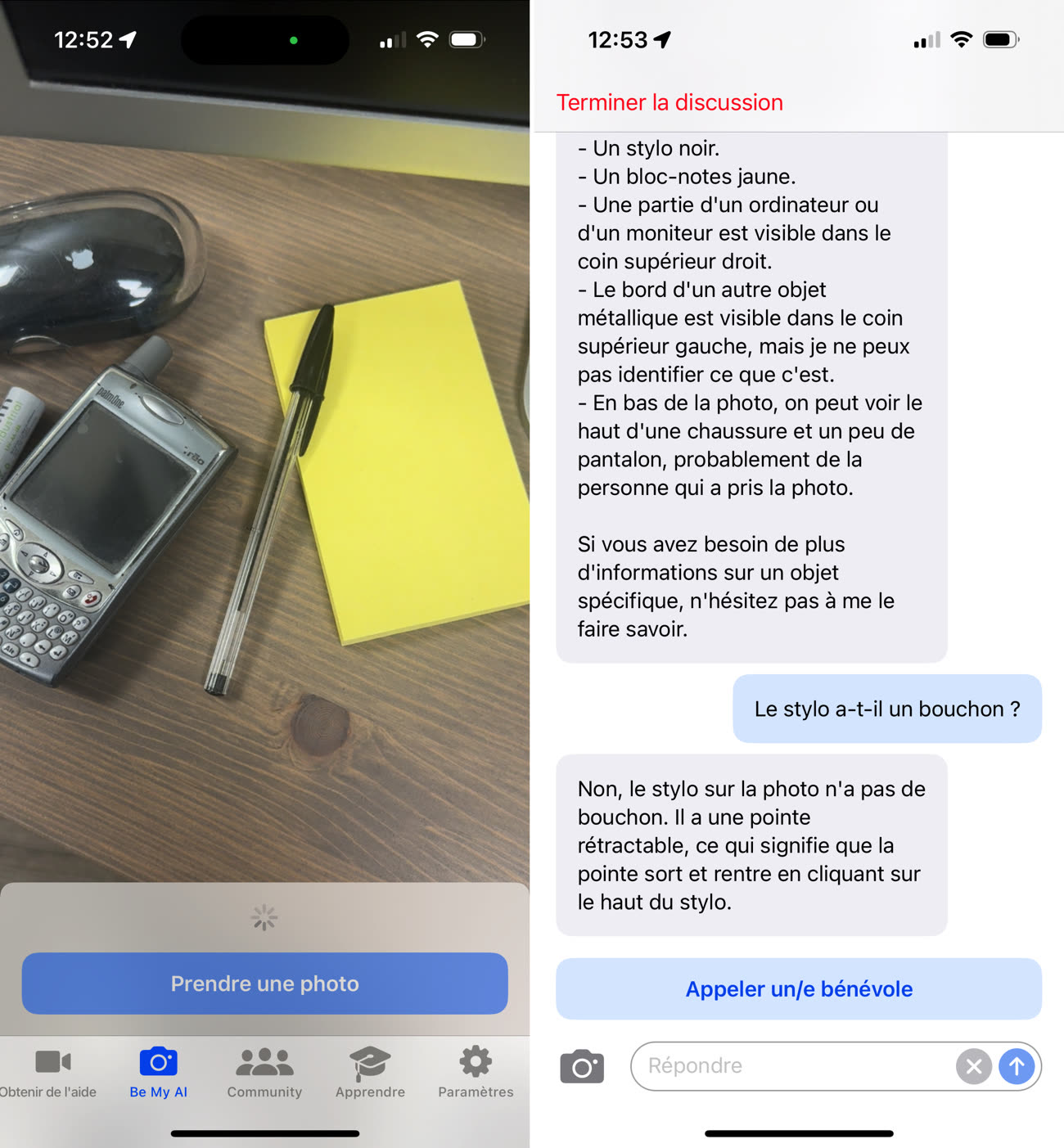

L'utilisation est simple : après avoir créé un compte dans l'application, on se rend dans le nouvel onglet Be My AI et on prend en photo l'objet ou la scène à décrire. La photo est alors envoyée sur les serveurs d'OpenAI pour être analysée par GPT-4V. Une dizaine de secondes plus tard, la description est affichée dans l'application et elle peut être lue par VoiceOver, le lecteur d'écran intégré à iOS.

« Le résultat de ces analyses est le plus poussé que je n’ai jamais vu dans aucune autre application de détection et de reconnaissance d’image », nous indique Tristan, un développeur aveugle qui nous a signalé l'existence de Be My AI. Depuis son lancement à la rentrée sur iOS (la version Android se fait attendre), la fonction a déjà été utilisée plus d'un million de fois par plusieurs milliers de personnes.

« Depuis que j'ai connaissance de cette nouveauté, je me suis amusé à la mettre à rude épreuve en lui faisant ingurgiter toutes sortes d'images prises en bougeant, depuis la fenêtre d'un TGV, le téléphone à l'envers, de nuit, de jour… Et jusqu'à l'heure, je n'ai pas franchement réussi à la prendre en défaut », note Tristan. Il y a bien de petites erreurs, comme une pile de linge prise pour une couverture pliée, mais pas de grosse confusion comme il pouvait y en avoir avec les premières technologies de reconnaissance d'image, selon lui.

« Les descriptions générées sont vraiment impressionnantes de précision : on a un résumé des éléments et s'il y a des gens, on a leur description ainsi que leur action, explique-t-il. S'il semble que l'IA galère parfois un peu avec les couleurs et les nuances, à cause des conditions d'éclairage par exemple, on est vraiment sur quelque chose de globalement cohérent. »

Il est même possible de demander à GPT des précisions sur la scène capturée pour éclaircir tel ou tel point, comme on le ferait avec un bénévole humain. Lors d'un de nos essais, l'assistant s'est trompé quand il s'agissait de savoir si le stylo capturé avait un bouchon ou non. C'est pour ce genre d'imprécision que By My AI est toujours présentée comme une « bêta ouverte », qu'elle est accompagnée d'un message d'avertissement (il est déconseillé de l'utiliser pour des actions ou des données sensibles) et qu'il reste possible d'appeler facilement un volontaire en chair et en os.

Le temps de traitement relativement long (une dizaine de secondes en moyenne) et la consommation de ressources sur iPhone assez élevée (même si l'analyse est effectuée en ligne) sont deux autres bémols, mais Tristan les pardonne sans peine au vu de l'efficacité de l'analyse. La gestion des données peut être aussi considérée comme un écueil dans certains cas : les photos prises avec Be My AI peuvent être stockées par le fournisseur du service (OpenAI) et exploitées pour entraîner sa technologie d'intelligence artificielle. Be My Eyes n'en fait pas mystère en déconseillant son utilisation pour des informations sensibles.

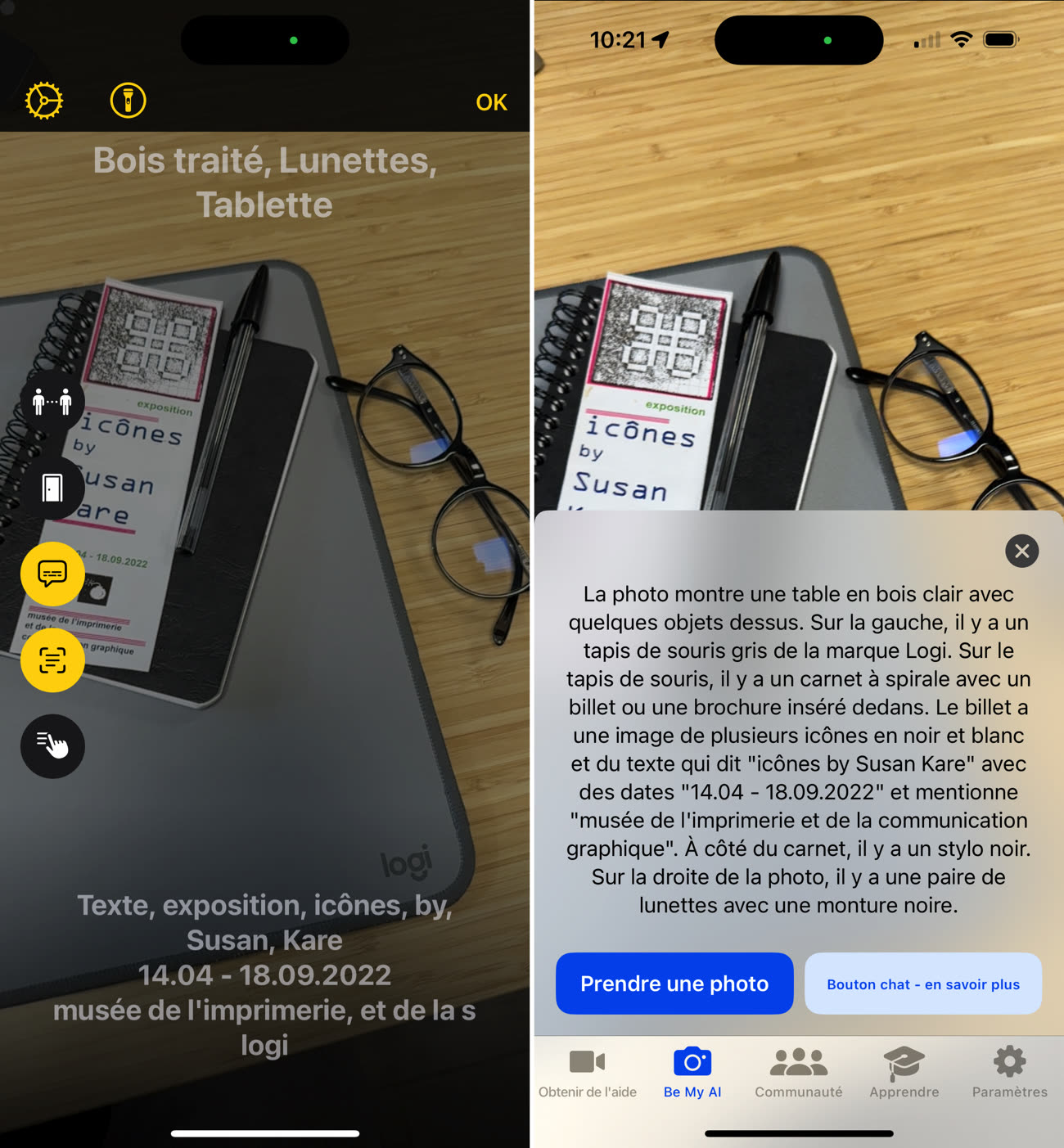

Depuis iOS 16, Apple propose sa propre solution de reconnaissance de l'environnement qui n'a pas ces défauts. La fonction de description associée à la Loupe est exécutée en local pour une analyse immédiate (pas besoin de prendre de photo, la description s'affiche quasi instantanément) et privée. La contrepartie, c'est que la description est très sommaire : quand la fonction native d'iOS se contente de lister les objets présents, Be My AI détaille à quoi ils ressemblent et comment ils sont répartis dans l'espace. « Les deux solutions sont en fait complémentaires », résume Tristan.

Be My AI est gratuit durant cette phase de bêta et le restera normalement à l'avenir. L'éditeur prévient néanmoins que si le contrat avec son partenaire devait prendre fin, il devrait envisager d'autres options. OpenAI fait habituellement payer GPT-4V, mais les deux acteurs ont sûrement trouvé un accord spécial permettant à Be My Eyes d'en profiter gratuitement en échange des données de ses utilisateurs.

Alors que Microsoft a intégré ce mois-ci Be My AI à son centre d'assistance dédié aux personnes handicapées, Tristan imagine déjà d'autres usages avec GPT-4V, comme la création d'audiodescriptions pour les films qui restent trop rares : « Netflix a commencé à produire des descriptions avec des voix synthétiques qui lui permettent de rédiger le texte puis de le traduire correctement dans chaque langue sans avoir recours à des comédiens, mais tellement reste à faire qu'un petit coup de main de l'IA serait bienvenu. »