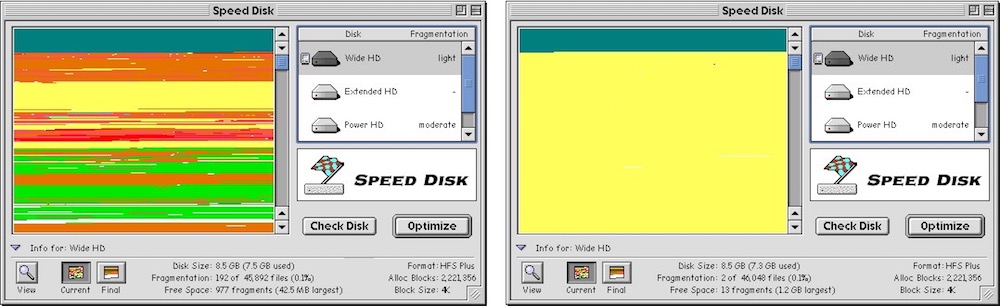

À une époque pas si éloignée, la défragmentation était dans le vocabulaire courant des utilisateurs d’ordinateurs. Cette opération lente (si lente…) devait être effectuée régulièrement si l’on voulait conserver des performances correctes. Les informations étaient écrites sur les disques durs dans des blocs non contigus, ce qui fait que la lecture était de plus en plus lente. Pour accélérer les choses, la défragmentation consistait à organiser les blocs de manière plus logique, en les regroupant au plus près pour accélérer la lecture.

Les SSD ont contribué à rendre la défragmentation largement obsolète. Même si les blocs d’informations ne sont pas stockés les uns à côté des autres, les débits en lecture sont tels que l’impact sur les performances sont moins visibles. Et puis les contrôleurs des puces de stockage intégraient des mécanismes pour éviter les ralentissements.

C’est pourquoi la découverte de Guilherme Rambo est surprenante : en fouinant dans le code d’iOS 11.4 disponible en bêta depuis hier soir, il a déniché un nouveau processus nommé apfs_defragd. Son nom semble assez explicite, il s’agit a priori d’un outil de défragmentation pour APFS, le système de fichiers maison d’Apple qui est en place depuis un an. Apple avait prévenu l’an dernier qu’un mécanisme de défragmentation était prévu, mais uniquement pour les disques durs des Mac, pas pour les stockages flash des appareils iOS.

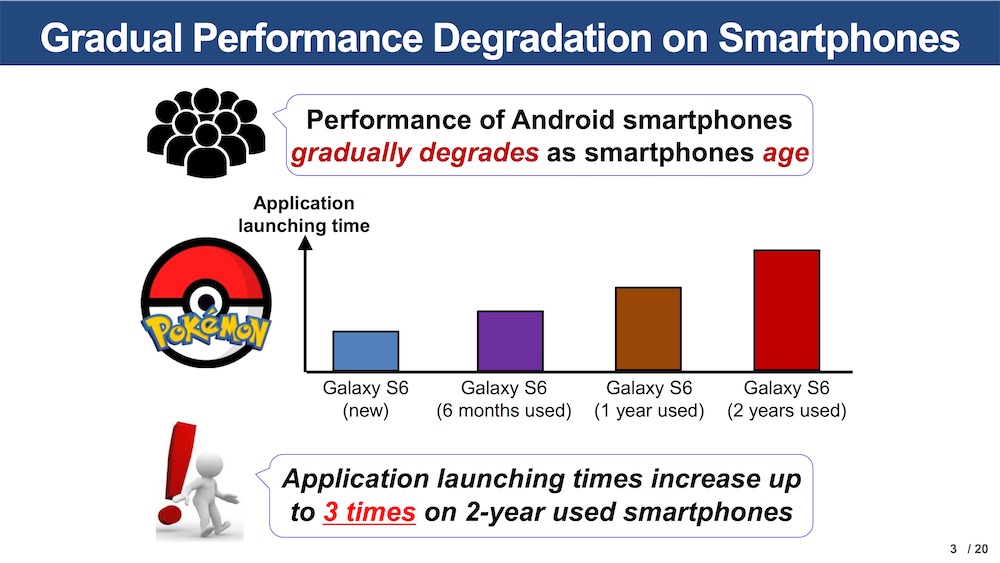

Alors pourquoi défragmenter iPhone et iPad ? Peut-être parce qu’Apple ne compte plus exploiter les fonctions fournies par les contrôleurs associés aux puces NAND des appareils iOS. Le constructeur pourrait au contraire tout faire du côté du logiciel, peut-être pour mieux optimiser le stockage. On ne sait pas exactement quelle est son idée, on sait en revanche que la fragmentation existe aussi pour les NAND et qu’elle peut avoir un impact sur les performances.

Est-ce qu’iOS 11.4 va améliorer les performances des appareils iOS ? Il est trop tôt pour le dire, d’autant qu’Apple utilisait jusque-là d’autres mécanismes pour éviter les baisses de performance au fil du temps. On ne sait pas non plus si macOS 10.13.4 hérite du même processus. Faute de documentation concernant la gestion de la défragmentation par APFS, les utilitaires Mac spécialisés iDefrag et iPartition ont été récemment abandonnés.