Il faudra sans doute attendre la présentation de la nouvelle gamme d'iPhone, qui pourrait tomber le 13 octobre, pour qu'Apple déballe le paquet sur l'A14 Bionic. Le constructeur a levé une partie du voile avec l'iPad Air 4 qui intègre la puce, mais il reste encore quelques inconnues notamment sur le plan des performances (heureusement, on peut compter sur les benchmarks officieux).

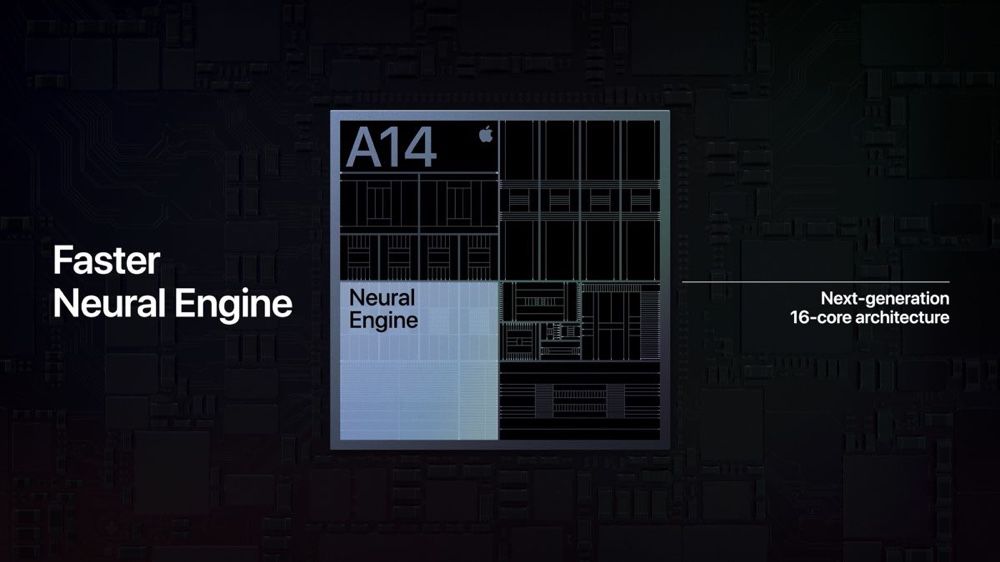

Le constructeur a toutefois livré quelques informations sur son dernier système-sur-puce (SoC), en particulier sur le Neural Engine, qui comprend 16 cœurs pouvant traiter la bagatelle de 11 000 milliards d'opérations par seconde — à comparer aux 600 milliards d'opérations de la puce neuronale intégrée au plus près du SoC de l'iPhone 8 et X, l'A11 (dont le sobriquet « Bionic » est tiré du Neural Engine) et aux 5 000 milliards de l'A12 et de l'A13.

Des accélérateurs sont également présents dans le processeur central pour accélérer la vitesse de calcul. L'A14 affiche une accélération x10 par rapport au processeur de l'A12, qui comptait deux accélérateurs (tout comme l'A13, qui affichait une accélération x6 par rapport à l'A12). Le traitement des tâches liées à l'apprentissage automatique est deux fois plus rapide avec l'A14 par rapport à l'A12.

Les apps qui s'appuient sur le framework Core ML pour certaines de leurs fonctions vont filer à toute allure. « Ça me coupe le souffle quand je vois ce que les gens peuvent faire avec la puce A14 », s'exclame Tim Millet dans le Stern allemand. Le vice-président d'Apple en charge de l'architecture des plateformes explique qu'Apple met tout en œuvre pour que cette technologie soit mise à disposition du plus grand nombre de développeurs.

Nous travaillons en étroite collaboration avec notre équipe logicielle tout au long du développement pour nous assurer que nous ne construisons pas seulement une technologie utile pour quelques-uns. Nous voulons nous assurer que des milliers et des milliers de développeurs iOS puissent en faire quelque chose.

Apple a beaucoup investi pour s'assurer qu'elle ne se contente pas simplement d'« emballer des transistors » qui ne serviraient pas. « Nous voulons que tout le monde puisse y accéder », assure le dirigeant. Bien sûr, Apple n'a pas inventé les réseaux de neurones artificiels, une technologie qui existe depuis des années. Mais Millet relève qu'il manquait jusqu'à ces dernières années deux choses pour que les techniques de l'apprentissage automatique donnent le meilleur d'elles mêmes : « un manque de données et de puissance de calcul pour développer des modèles complexes pouvant également traiter une grande quantité de données ».

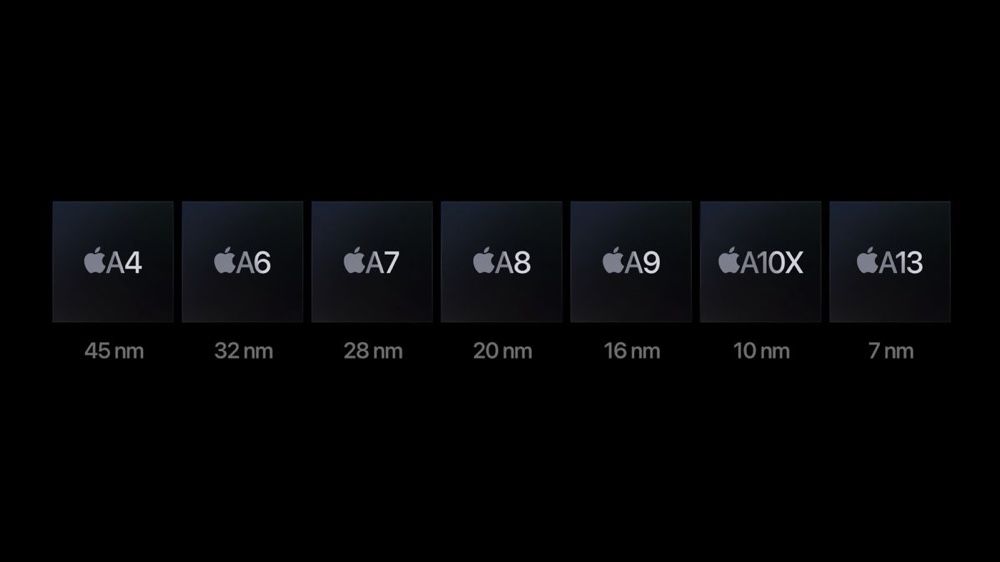

C'est grâce au travail des équipes de Jony Srouji et aux évolutions apportées à la finesse des gravures de ses puces que l'A14 est aussi bien taillé pour les tâches d'apprentissage automatique, ce qu'il faudra vérifier sur pièce, évidemment (lire : La puce A11 Bionic en développement depuis l’iPhone 6).

Face ID fait partie de ces fonctions qui font un grand usage du Neural Engine, mais comme chacun a pu s'en rendre compte, le système de reconnaissance faciale d'Apple est désarmé quand on porte un masque. Tim Millet s'en excuse : « Il est difficile de voir quelque chose qu'on ne peut pas voir », en parlant de la partie du visage couverte. Des possibilités sont envisageables comme la reconnaissance du haut du visage, mais « vous perdrez certaines des spécificités qui rendent votre usage unique », décrit-il. Potentiellement, quelqu'un pourrait déverrouiller votre iPhone plus facilement.

Le problème est donc « délicat », convient le vice-président. « Les utilisateurs veulent la sécurité, mais ils veulent aussi la commodité », et Apple cherche à s'assurer que les données sont en sécurité. La solution finalement pourrait être de combiner Face ID avec Touch ID, mais pour le moment c'est fromage ou dessert. Même si Apple continue de développer sa technologie de reconnaissance des empreintes digitales (lire : Intégrer Touch ID au bouton d’allumage de l’iPad Air 4 n’a pas été facile).