Après les rumeurs, on s'attendait à une annonce en bonne et due forme et c'est chose faite ce soir : Apple va bel et bien intégrer dans l'iPhone une technologie de détection d'images pédopornographiques qui va scanner les images à même l'appareil… Mais c'est un peu plus compliqué que cela, et ce n'est pas le seul mécanisme de sécurité dédié à la protection de l'enfance que le constructeur présente sur ce nouveau site.

Il y a en fait trois mesures qui vont être mises en place plus tard cette année, qui vont se limiter aux États-Unis pour le moment. Apple fournit un livre blanc technique sur l'ensemble de ces mesures.

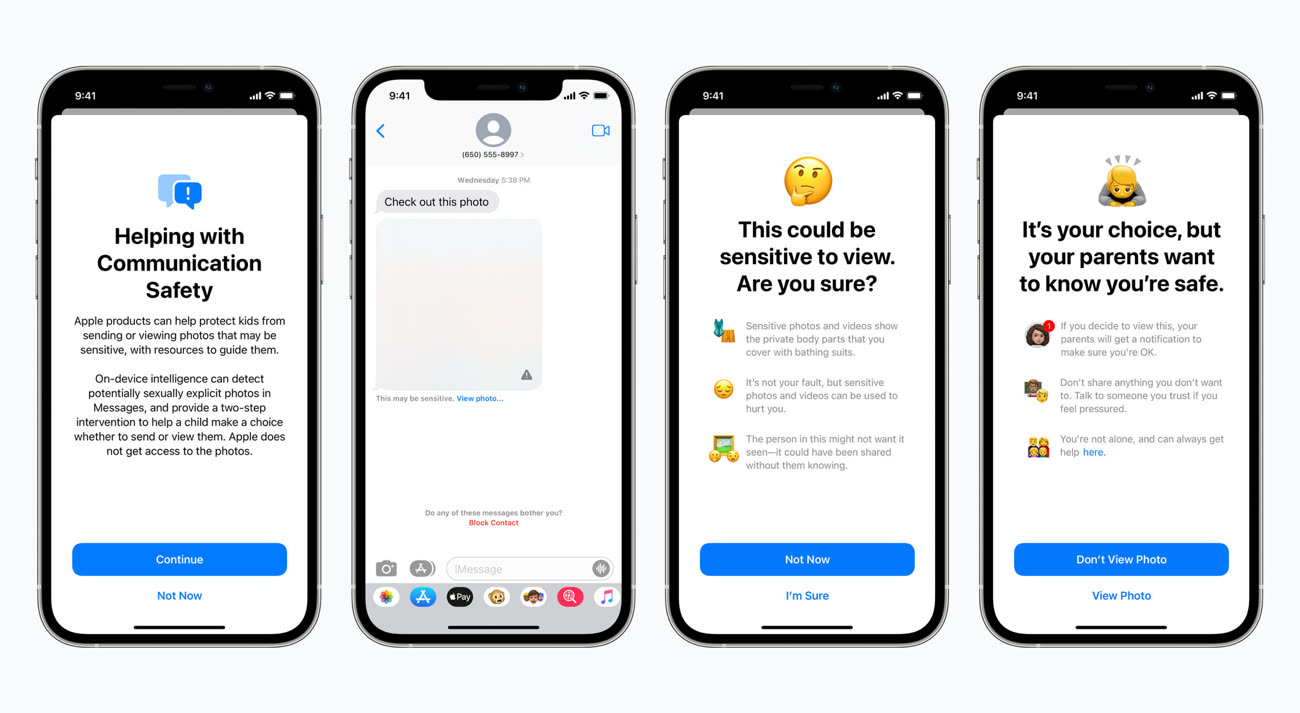

L'application Messages va bénéficier de nouveaux outils qui vont prévenir l'enfant utilisateur que tel contenu partagé est potentiellement sensible (on peut penser à des photos sexuellement explicites envoyées par des prédateurs). À la réception de telles images, elles seront floutées et l'enfant recevra une alerte sur la nature litigieuse du message.

Si l'utilisateur mineur décide tout de même de visualiser l'image, les parents pourront recevoir une notification. Idem lorsque le mineur décide de partager une photo intime. Les notifications parentales sont optionnelles pour les enfants de moins de 13 ans, et pas disponibles pour les enfants âgés entre 13 et 17 ans. Messages s'appuie sur un traitement d'apprentissage automatique réalisé à même l'appareil pour analyser l'image et déterminer s'il s'agit d'un contenu sexuellement explicite. Bien sûr, Apple n'a pas accès aux messages.

Cette fonction sera disponible dans iOS 15, iPadOS 15 et macOS Monterey, pour les comptes Apple configurés en partage familial.

Un Genius à la maison : comment bien gérer le partage familial

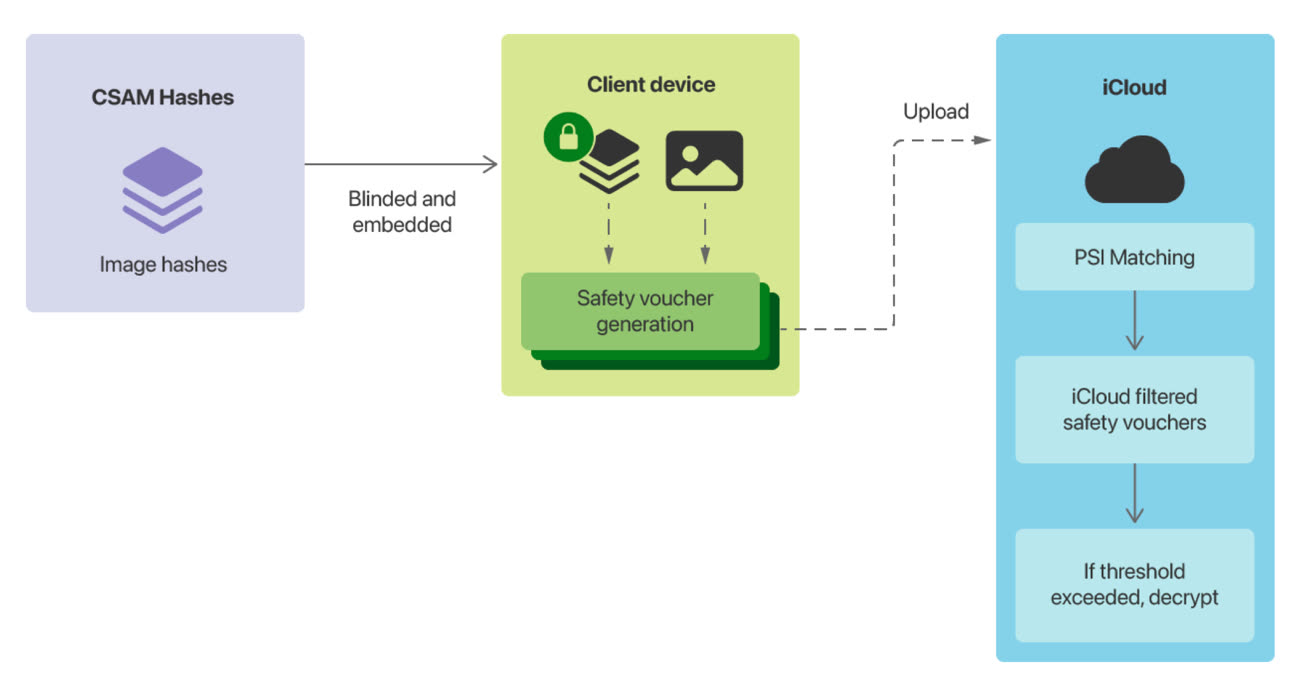

La technologie de détection d'images pédophiles (CSAM pour Child Sexual Abuse Material) fera son apparition dans iOS et iPadOS. Elle permettra à l'appareil d'examiner les images stockées dans la bibliothèque photos, et en cas de détection de cas d'abus sexuels sur des enfants, Apple sera en mesure d'alerter le National Center for Missing and Exploited Children (NCMEC), une organisation qui travaille avec les forces de l'ordre américaines.

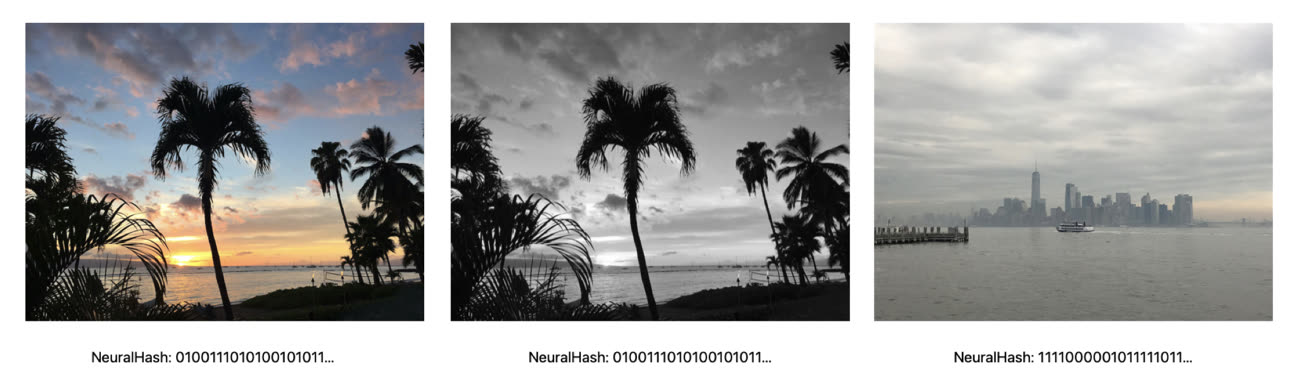

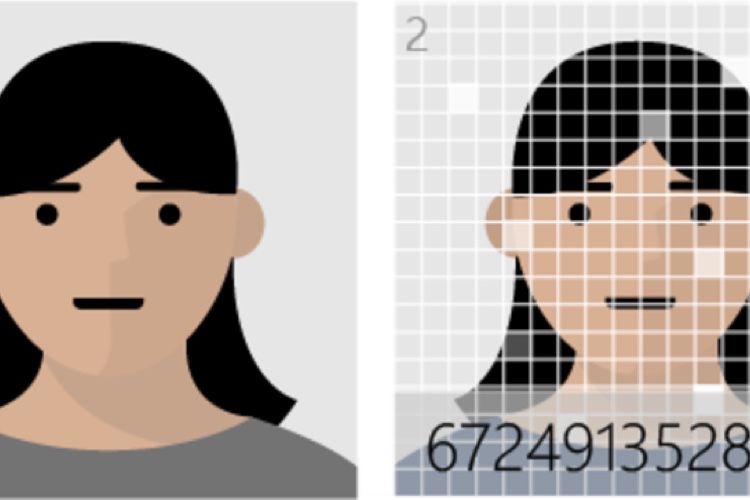

Cette technologie baptisée NeuralHash (et non pas NeuralMatch comme les indiscrétions l'ont annoncé tout à l'heure) analyse l'image et la convertit en une suite de chiffres. Les images en question peuvent être recadrées ou éditées, cela n'affectera pas le NeuralHash.

Avant qu'une image ne soit téléversée dans la bibliothèque iCloud, la méthode fait correspondre ces numéros avec ceux d'une base de données du NCMEC et d'autres groupes de défense des enfants. Apple transformera cette base de données en un ensemble de hashes qui sera stocké de manière sécurisée sur les appareils.

En cas de correspondance, l'appareil génère un jeton cryptographique et un « dérivé visuel » qui sont téléversés dans la bibliothèque iCloud Photos, en même temps que l'image. Une fois qu'un seuil (non révélé) de correspondances est dépassé, Apple s'empare des jetons et examine manuellement chaque rapport pour constater la correspondance, ou pas. Le compte iCloud est ensuite désactivé, et un rapport est envoyé au NCMEC qui prendra les mesures qui s'imposent.

Apple garantit un niveau « extrêmement élevé » de vigilance afin que les comptes ne soient pas signalés de manière incorrecte. Il va falloir faire confiance au constructeur sur ce coup là. Il donne plusieurs avantages à son système : cela lui permet d'identifier des images pédophiles stockées dans des bibliothèque iCloud Photos, tout en protégeant la vie privée de l'utilisateur.

Apple n'apprend l'existence des photos des utilisateurs que lorsqu'une collection de photos correspondantes à la base de données est présente dans un compte iCloud. Et même dans ce cas, Apple n'a accès qu'à ces images, pas aux autres qui ne correspondent pas.

Le constructeur ajoute que la base de données est invisible aux yeux de l'utilisateur, le système se veut « très précis » avec un taux très faible d'erreur, et plus respectueux de la confidentialité que le scan des photos sur les serveurs, bien que le constructeur ait admis utiliser ce type de technologie l'an dernier :

La lutte contre la pédophilie se mène aussi sur iCloud

On comprend donc que si le traitement de la correspondance entre la base de données et les photos de l'utilisateur se réalise à même l'appareil, il faut tout de même que les images soient téléversées dans le nuage d'iCloud afin qu'Apple puisse prévenir les autorités. La Pomme a confirmé que si iCloud Photos était désactivé sur l'appareil, il ne sera pas possible de détecter des images qui correspondent à la base de données CSAM.

À des degrés divers, d'autres entreprises scannent les images de leurs utilisateurs comme Twitter, Microsoft, Facebook et Google.

And if you’re wondering whether Google scans images for child abuse imagery, I answered that in the story I wrote eight years ago: it’s been doing that **SINCE 2008**. Maybe all sit down and put your hats back on. pic.twitter.com/ruJ4Z8SceY

— Charles Arthur (@charlesarthur) August 5, 2021

Dernier volet de cet ensemble de mesures de protection, Siri et les fonctions de recherche d'iOS/iPadOS 15, de watchOS 8 et de macOS Monterey vont proposer des liens pour rapporter des cas d'exploitation sexuelle de mineurs, au cas où l'utilisateur le demanderait.