Mise à jour 22h — Apple a officialisé les nouveaux mécanismes de sécurité pour lutter contre la pédopornographie en ligne. C'est à lire ici.

Apple n'a encore rien confirmé, mais selon le chercheur en sécurité Matthew Green et le Financial Times qui a fait parler plusieurs sources, le constructeur s'apprête à mettre en place un système de détection d'images pédopornographiques à même les iPhone vendus aux États-Unis. Le système, baptisé neuralMatch, aurait été présenté cette semaine par Apple à plusieurs universitaires, mais une communication publique serait prévue rapidement.

Le principe est le suivant : lorsque l'algorithme détecte une image litigieuse, il prévient une équipe d'examinateurs chez Apple chargés de vérifier la nature de la photo, et de contacter les autorités le cas échéant. Seuls les États-Unis seraient concernés, au moins dans un premier temps. Apple utilise déjà une technologie de correspondance d'images pour dépister des cas d'abus sexuels sur les enfants, mais celle-ci analyse les photos stockées sur iCloud. neuralMatch examinera les images directement sur l'iPhone.

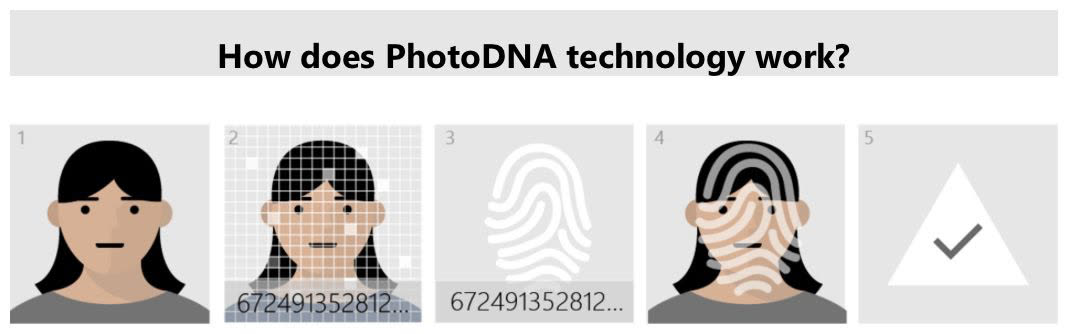

Selon Matthew Green, l'iPhone va télécharger une base de données contenant les signatures électroniques de contenus pédopornographiques. Ces signatures sont ensuite mises en correspondance avec les photos du smartphone converties en une suite de chiffres via du hashing. Une approche décentralisée qui s'appuie sur algorithme entraîné depuis la base de données du National Center for Missing and Exploited Children (NCMEC). Celle-ci sert aussi à l'analyse iCloud. À terme, l'examen des photos stockées dans le nuage se basera aussi sur neuralMatch.

Le FT explique qu'Apple a voulu trouver un équilibre entre la protection de la vie privée de ses utilisateurs et les demandes répétées des autorités et des organisations de défense de la jeunesse qui veulent que le constructeur en fasse davantage dans la lutte contre la pédophilie et le terrorisme. Bien que dans le cas qui nous occupe aujourd'hui, le terrorisme ne soit pas dans la boucle.

Si la technologie neuralMatch ne servira qu'à la détection d'images pédopornographiques, qui dit qu'elle ne pourra pas un jour partir à la recherche d'autres types de contenus ? Les opposants à un régime pourraient ainsi être visés par un système recherchant des documents anti-gouvernementaux… La crainte est que les États les moins sourcilleux sur la confidentialité mettent la pression sur Apple pour détourner neuralMatch de son objectif premier.