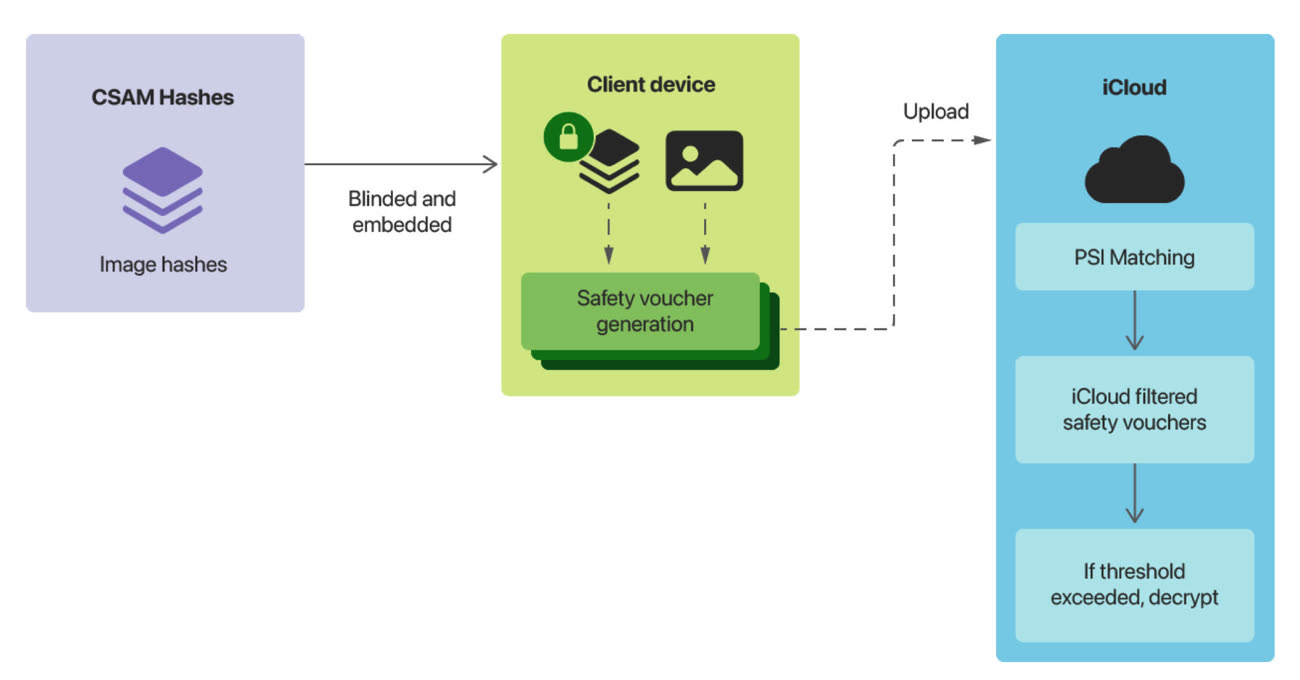

C'est au détour d'une déclaration chez Wired qu'Apple enterre discrètement une mesure annoncée en plein cœur de l'été 2021 pour lutter contre la pédophilie, et qui n'est pas passée inaperçue. Le constructeur abandonne son idée de détecter les images pédopornographiques contenues dans les bibliothèques de photos sur ses appareils.

Cette détection CSAM (pour Child Sexual Abuse Material) devait se réaliser à la fois en local puis sur les serveurs d'Apple, mais le constructeur a tellement mal géré la communication autour de ce projet que rapidement, il l'a mis sur pause. Avant de la lâcher complètement, donc.

Un des pêchés d'Apple dans cette histoire, c'est de s'être lancé la fleur au fusil en omettant de se concerter avec les spécialistes et les scientifiques qui travaillent sur les technologies de détection de ces images. Ce qui a soulevé de sérieuses craintes quant à la sécurité et à la confidentialité des données des utilisateurs.

« Nous avons décidé de ne pas aller de l'avant avec notre outil de détection CSAM que nous avions proposé pour iCloud Photos. Les enfants peuvent être protégés sans que les entreprises ne passent au peigne fin les données personnelles », explique le constructeur. « Nous continuerons à travailler avec les gouvernements, les organisations de protection de l'enfance et d'autres entreprises pour aider à protéger les enfants, à préserver leur droit à la vie privée et à faire d'internet un endroit plus sûr pour tous ».

Une mesure du « paquet » annoncé en août 2021 a été mis en place sans provoquer de controverse : le floutage des images dénudées dans Messages pour les jeunes utilisateurs. Cette fonction, réalisée entièrement en local, est disponible en France depuis iOS 16.

L'abandon de cette fonction va certainement de pair avec l'annonce de la sauvegarde chiffrée de bout en bout des photos dans iCloud.

iOS 16.2 pourra chiffrer de bout en bout les photos et les sauvegardes dans iCloud