Apple n’en a pas terminé avec l’histoire de la détection d’images pédopornographiques au sein des appareils de ses utilisateurs. Présenté en 2021, ce projet avait été abandonné l’année suivante face aux risques en matière de sécurité et de confidentialité que l’entreprise n’avait pas suffisamment pris en compte. Si ce recul a été salué par les défenseurs des libertés individuelles qui redoutaient la création d’une porte dérobée dans les iPhone et les Mac de tout un chacun, il a aussi désolé des victimes d’abus sexuels.

Aux États-Unis, une plainte a été déposée contre Apple pour avoir présenté « des améliorations significatives visant à protéger les enfants » qu’elle n’a ensuite « pas réussi à mettre en œuvre » dans ses systèmes d’exploitation. Le recours collectif pourrait regrouper jusqu’à 2 680 victimes de maltraitance infantile pour un montant total de 1,2 milliard de dollars de compensation demandée.

« Les contenus pédopornographiques sont abominables et nous sommes déterminés à lutter contre les méthodes utilisées par les prédateurs pour mettre les enfants en danger. Nous innovons activement et de toute urgence pour lutter contre ces crimes sans compromettre la sécurité et la vie privée de tous nos utilisateurs », a déclaré à propos de cette poursuite un porte-parole d’Apple interrogé par le New York Times.

Le journal relate la souffrance d’une Américaine de 27 ans informée presque quotidiennement par les autorités qu’une nouvelle personne est accusée d’être en possession d’images d’elles la montrant abusée sexuellement alors qu’elle était enfant. Dans l’un de ces avis des forces de l’ordre, il était indiqué que les photos avaient été trouvées sur le MacBook d’un homme. La jeune femme poursuit maintenant Apple car elle estime que l’entreprise n’a pas tenu sa promesse pour protéger les victimes comme elle.

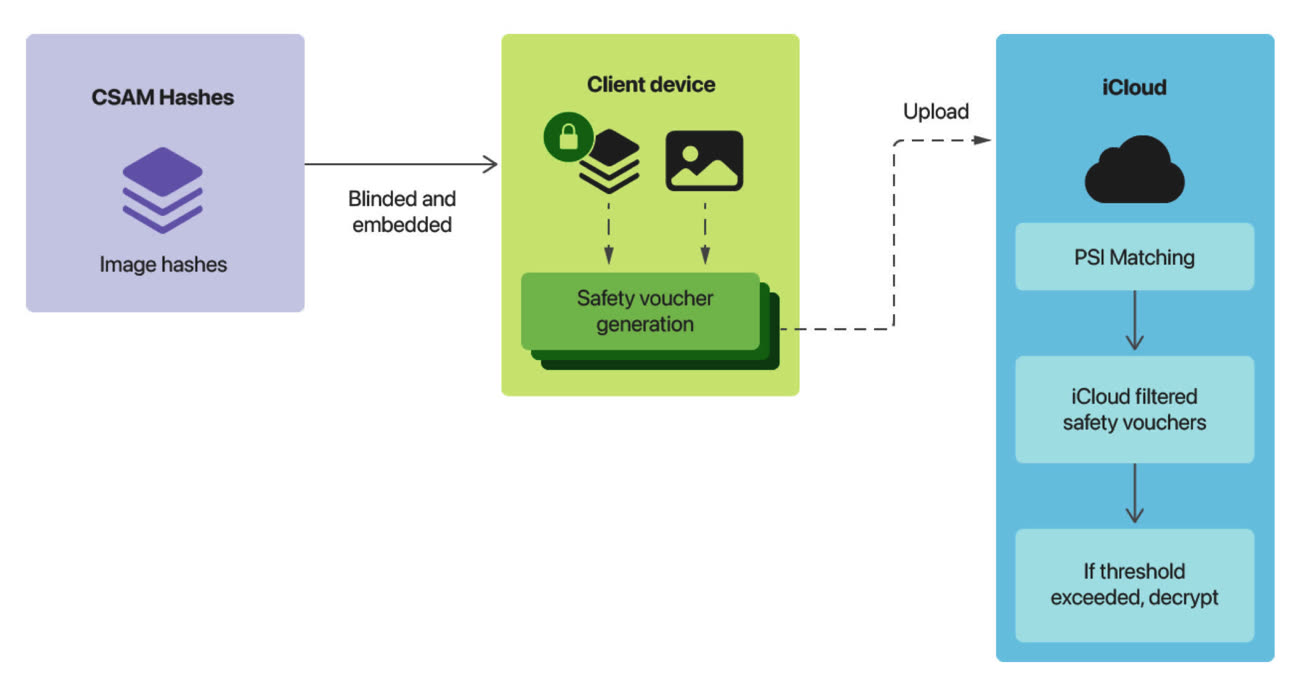

Pour détecter des contenus pédopornographiques sur les appareils de ses clients, Apple avait imaginé un mécanisme d’encodage complexe pour représenter les photos sous la forme d’un identifiant numérique capable de résister au recadrage et aux retouches. Avant qu’une image ne soit synchronisée avec la photothèque iCloud, le système aurait comparé son identifiant à ceux des images d’une base de contenu pédopornographique tenue par une ONG.

« La recherche d’un type de contenu particulier pourrait ouvrir la voie à une surveillance de masse, avait finalement réalisé un an plus tard Erik Neuenschwander, le responsable de la confidentialité chez Apple, reprenant un argument d'experts en sécurité indépendants. Nous avons conclu qu’en pratique, il est impossible d’implémenter [notre projet] sans mettre en péril la sécurité et la confidentialité de nos utilisateurs. »

Apple a mis en place d’autres protections pour les mineurs, comme le floutage des photos sexuellement explicites reçues dans Messages ainsi qu’un avertissement en cas d’envoi d’une photo de ce type.