À l'heure où le nouvel iPhone SE est capable de réaliser des images en mode Portrait avec son unique appareil photo (c'est même un des principaux arguments de vente d'Apple), il est tout de même bien malheureux que l'iPad Pro 2020 ne puisse réaliser une prouesse similaire. Et pourtant, la tablette embarque non seulement un ultra grand-angle absent du smartphone, mais aussi un capteur LiDAR !

Sebastiaan de With, un des développeurs de l'app photo Halide, va doucher quelques espoirs. Il n'est absolument pas certain que le LiDAR de l'iPad Pro soit la garantie que la tablette accueillera un mode Portrait. Pourtant, le boulot de ce capteur est d'évaluer la profondeur (il mesure la distance entre la tablette et un objet situé à moins de 5 mètres).

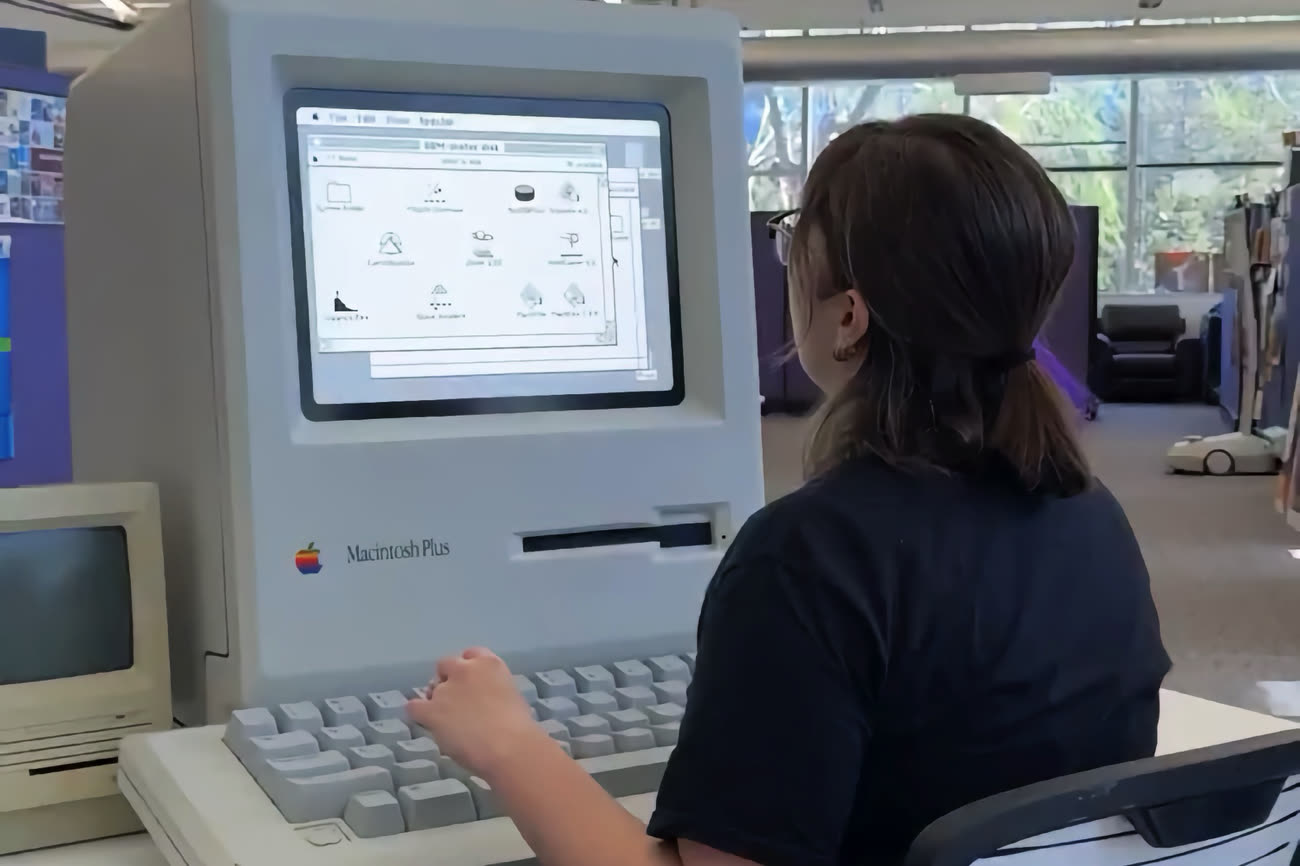

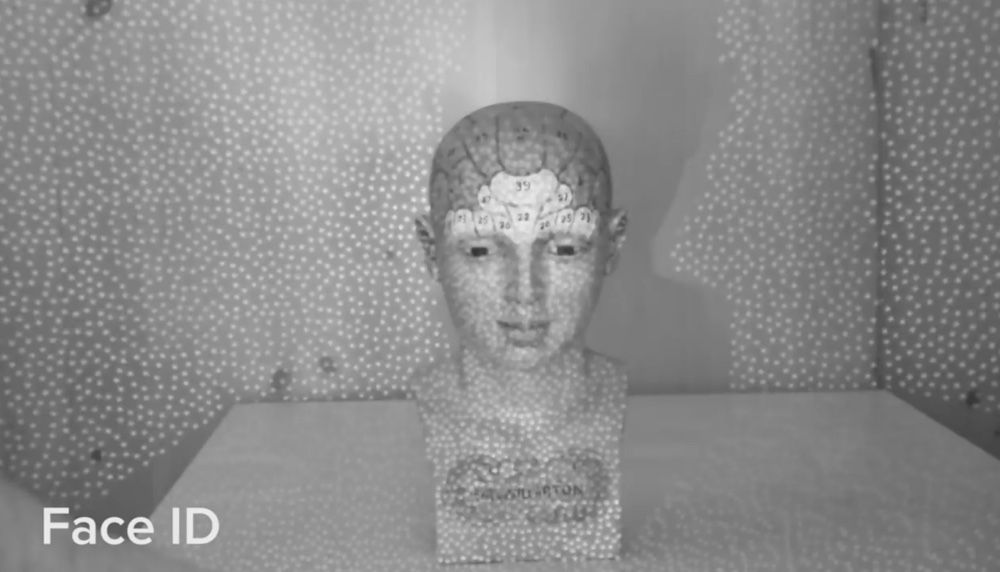

À l'instar du TrueDepth de l'iPhone (aussi présent sur l'iPad Pro), le LiDAR de la tablette projette un nuage de points lumineux… mais il se trouve que les mailles de ce filet invisible à l'œil nu sont beaucoup plus espacées avec le LiDAR qu'avec Face ID. iFixit l'avait constaté lors du démontage de l'iPad Pro :

Si le nuage de points de Face ID est si dense, c'est qu'il doit mesurer précisément la « profondeur » du visage, des informations nécessaires à la fonction de déverrouillage de l'appareil. Le LiDAR se destine lui à la numérisation des pièces de la maison. Cela ne le qualifie pas nécessairement pour la réalisation de photos en mode Portrait.

Certes, rien n'empêcherait Apple d'exploiter les informations de profondeur du LiDAR pour mettre au point un mode Portrait sur l'iPad Pro. Mais Sebastiaan de With pense que le constructeur utilisera plutôt une bonne dose de machine learning, comme c'est le cas sur l'iPhone XR : les données de profondeur obtenues par le capteur photo du smartphone sont limitées, mais avec le réseau neuronal qui va bien, il est possible d'accomplir bien des miracles (au passage, on verra ce qu'il en sera avec l'iPhone SE).

D'après notre test de performances du Neural Engine, l'A12Z est plus performant que l'A12 de l'iPhone XR. L'espoir reste donc de mise… Pour obtenir les données suffisantes pour le mode Portrait, Apple pourrait s'appuyer sur les deux capteurs photo de l'iPad Pro plutôt que sur son LiDAR.

Le capteur, que l'on pourrait retrouver sur l'iPhone 12, ouvre des perspectives qui ne sont pas nécessairement liées à la photographie. Jeu vidéo, architecture, ameublement, industrie… C'est aux développeurs d'imaginer de nouveaux usages. Apple fournit avec ARKit 3.5 les outils nécessaires pour tirer avantage du LiDAR, mais uniquement les surfaces 3D, pas les informations de profondeur déplore le développeur.

Le capteur est bien équipé pour scanner un meuble, comme le montre l'app Esper, développée spécialement à cette occasion par l'équipe d'Halide :

Mais il ne faut pas regarder de trop près. Les informations demeurent insuffisantes pour scanner des objets pour les imprimer en 3D. Cela reste malgré tout un bon point de départ pour créer des modèles en trois dimensions, les proportions étant elles très précises.