Apple détaille dans une page d'assistance la façon dont elle collecte des données pour affiner son affichage en réalité augmentée dans Plans. Ce recours à des informations fournies par l'utilisateur est optionnel.

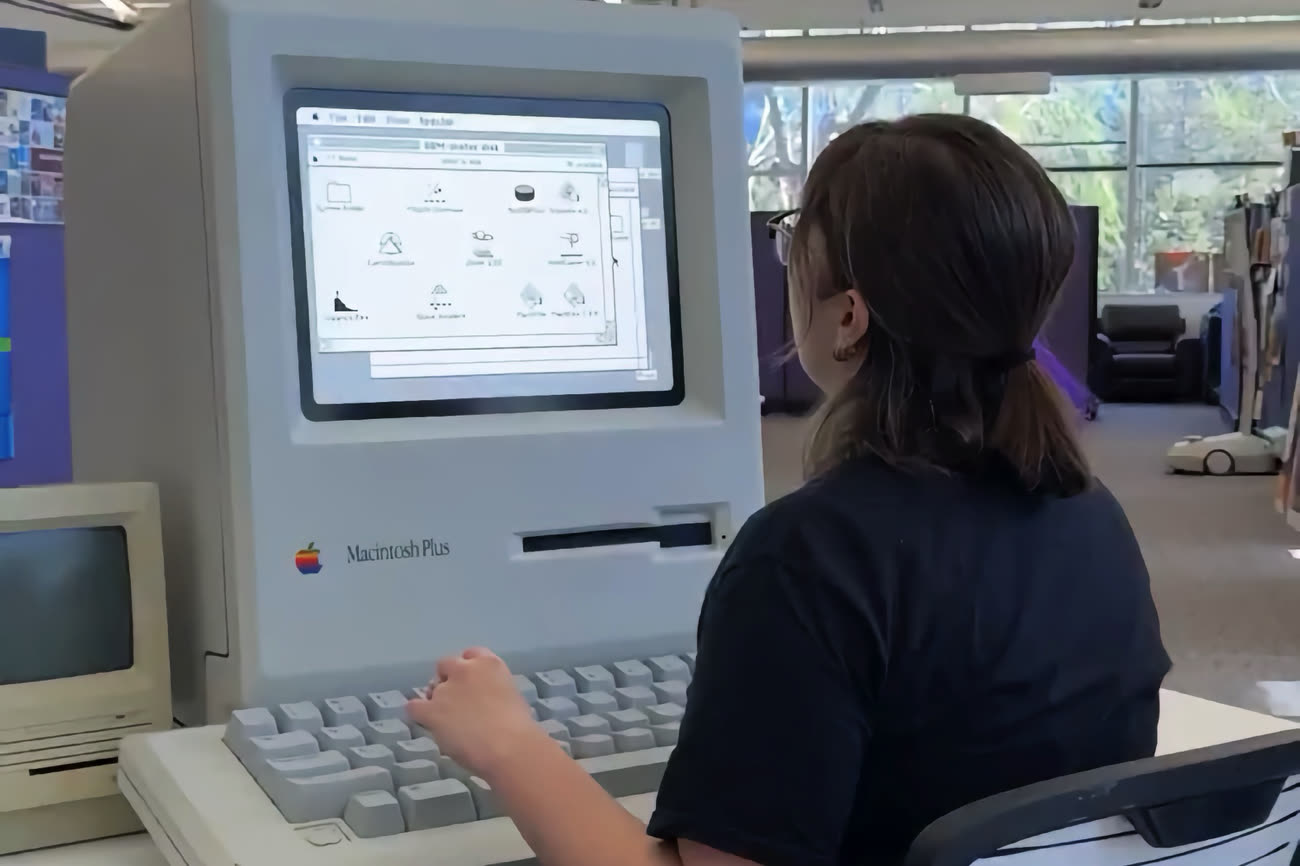

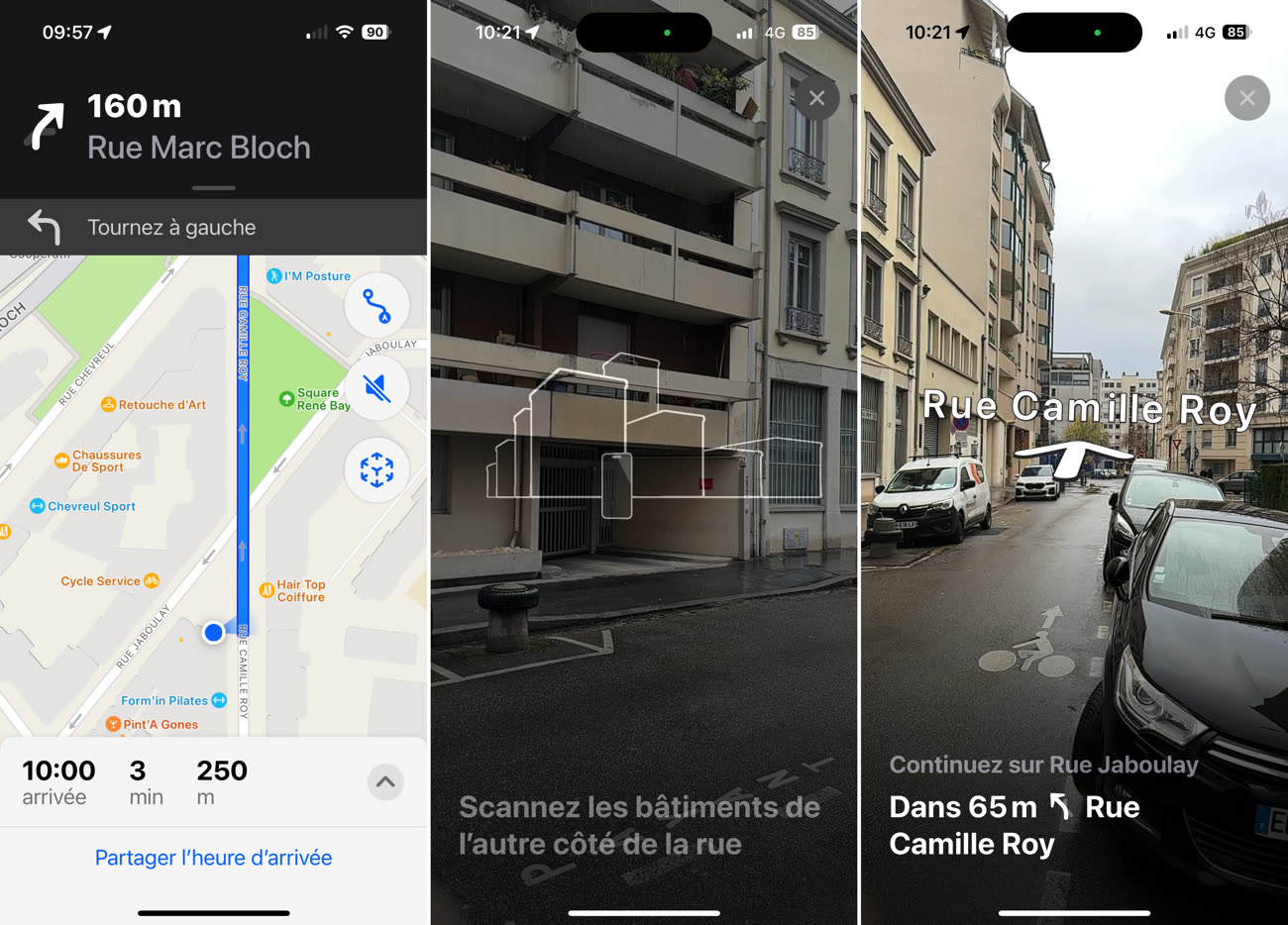

Ces explications ont été publiées après la sortie d'iOS 17.2 qui inclut un réglage utilisateur pour cette fonction. Cela fait un peu plus d'un an que Plans, en France, propose cet affichage en réalité augmentée où les consignes d'itinéraire s'affichent en surimposition à l'image capturée par la caméra. Ce n'est pas forcément pratique — il faut garder le téléphone en l'air à la verticale — mais cette fonction peut s'envisager sur le long terme, dans d'autres contextes.

Apple explique que l'on peut contribuer à améliorer la précision des informations données dans cette vue. Lorsque l'iPhone est utilisé dans ce mode, la caméra détecte des "points caractéristiques" dans l'image, ceux qui définissent la taille et la forme d'éléments statiques. Ça pourra être une bâtisse, un monument ou un immeuble. Une fonction d'apprentissage automatique, exécutée en local sur le téléphone, est utilisée pour comparer les informations de ces relevés avec celles envoyées par Plans à l'utilisateur et ainsi améliorer la précision de l'affichage en RA.

Les personnes ou objets en mouvement comme les motos ou voitures sont filtrés pour ne retenir que des masses fixes. Aucune photo n'est collectée, ni d’informations d'identification de l'utilisateur, et du bruit est ajouté dans les données, précise Apple.

Comme mesure supplémentaire pour protéger davantage votre vie privée, Apple utilise l'apprentissage automatique sur l'appareil pour ajouter du "bruit" aux données des points caractéristiques. Ce bruit crée des variations irrégulières dans les données qui permettent toujours à Plans de comparer les points caractéristiques aux données de référence, mais agit pour empêcher le scénario improbable d'une tentative d'utiliser les points caractéristiques pour recréer une image où des personnes ou des véhicules pourraient être identifiés.

À cette fin, Apple met en concurrence des moteurs neuronaux où l'un brouille l'image en ajoutant ce bruit et l'autre tente de la reconstituer. Le résultat de ce match lui permet d'améliorer son bruitage tout en conservant la lecture des points collectés nécessaires à Plans.

Ce partage de données est optionnel. Il peut être proposé lorsqu'on active l'affichage en réalité augmentée. Pour le modifier, il faut aller dans Réglages > Confidentialité et sécurité > Analyse et améliorations > Précision de la localisation en RA (tout en bas).