Apple a officialisé un partenariat avec OpenAI, qui va se traduire par une intégration entre ChatGPT et Siri ou différents outils Apple. En pratique, on pourra poser une question à l’assistant qui pourra remonter tout cela à ChatGPT et répondre aux requêtes.

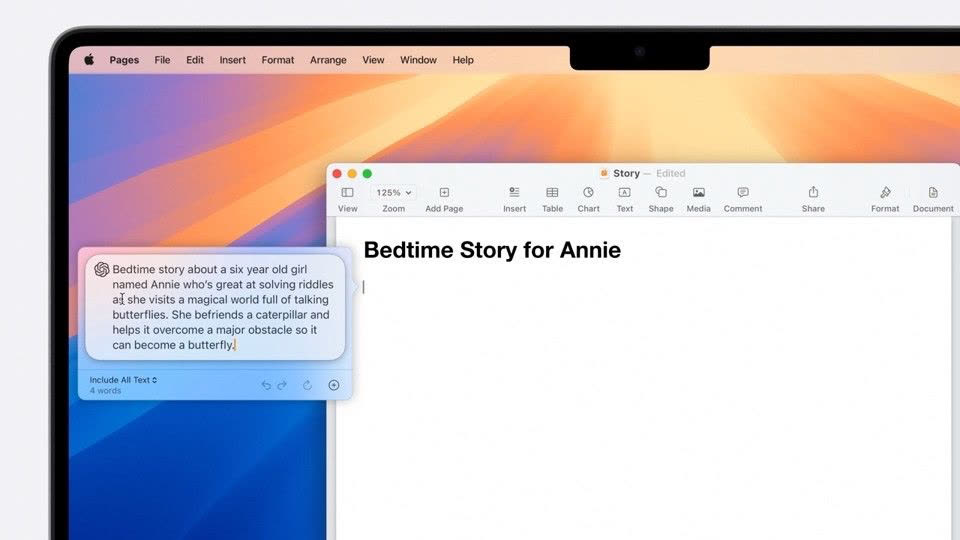

C’est le récent GPT-4o d’OpenAI qui est intégré à Siri. À chaque fois, l'assistant demandera la permission pour contacter les serveurs d’OpenAI. Si vous l'accordez, vous aurez la réponse de l'assistant dans la foulée. Un pop-up pourra apparaître dans certaines apps, par exemple pour demander à ChatGPT de générer du texte.

ChatGPT sera accessible sans créer de compte, et les requêtes ne seront pas stockées sur les serveurs. L’intégration de ChatGPT aura lieu plus tard dans l’année. D’autres modèles pourraient suivre par la suite.