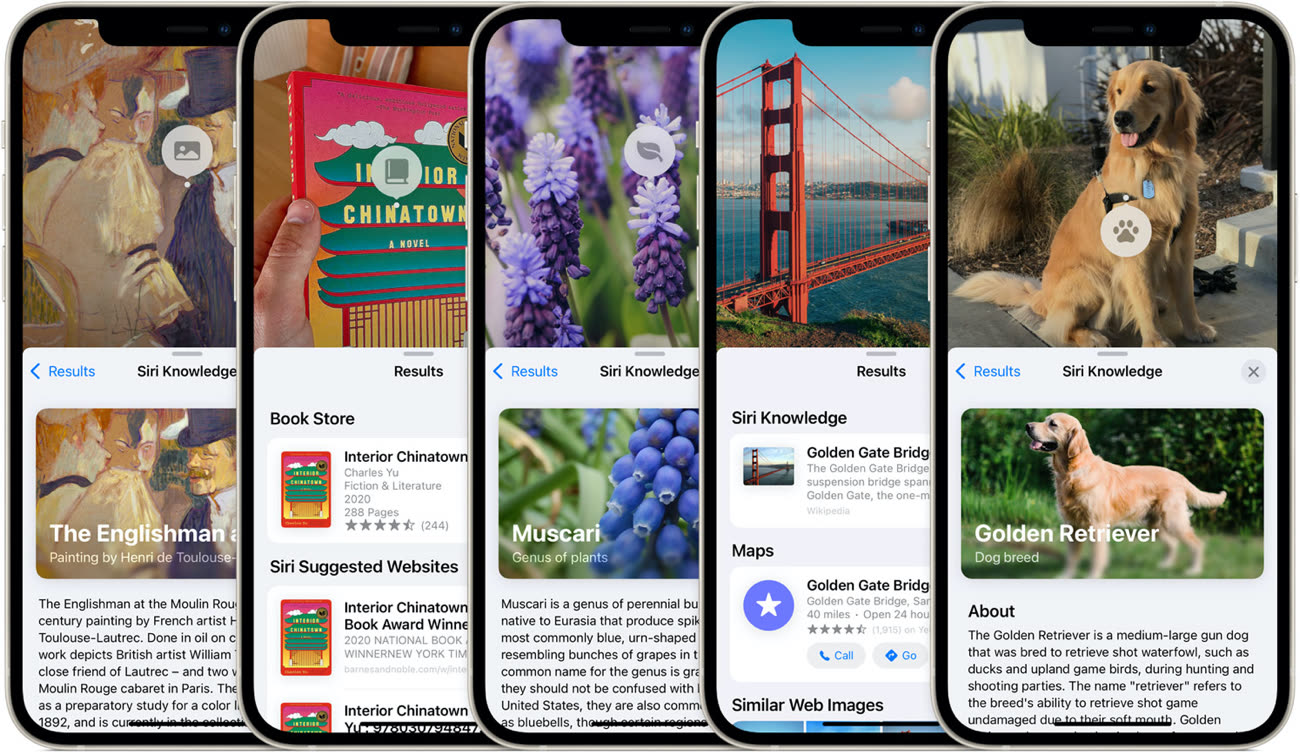

La recherche visuelle est l’une des nouvelles fonctions d’iOS 15 qui doit permettre d’identifier précisément le contenu d’une image. L’app Photos savait identifier un chien, mais elle peut désormais vous donner la race de l’animal. Cette nouveauté permet aussi d’identifier les monuments pris en photo, la variété d’une plante ou même d’obtenir des informations sur un livre ou un tableau pris en photo.

Cette nouveauté a été présentée sans aucune restriction, si ce n’est matérielle : comme texte en direct, elle nécessite un appareil iOS avec une puce Apple A12 au minimum. Pour le reste, tout le monde devait pouvoir en bénéficier et Apple n’a pas signalé d’incompatibilité sur sa liste des fonctionnalités d’iOS 15. Néanmoins, elle n’a jamais fonctionné sur nos appareils, si bien que l’on pensait la nouveauté retardée.

Comme nous l’a signalé un lecteur, elle a toutefois fait son apparition sur cette page publiée par Apple qui liste les restrictions régionales. La recherche visuelle est indiquée comme étant compatible uniquement avec les appareils Apple en anglais et réglés sur la région États-Unis. En clair, elle n’est accessible qu’aux utilisateurs dans ce pays, ce qui explique pourquoi on ne l’a jamais vue sur nos appareils configurés en France.

L’ajout de la recherche visuelle sur cette page semble dater du soir du keynote et c’est à notre connaissance la première fois qu’une telle restriction a été mentionnée. Le changement semble tout récent, la preuve cette fiche support mise à jour le 24 septembre, soit vendredi dernier, présente la fonction en français sans évoquer de limitation géographique, comme si elle était disponible dès aujourd’hui.

Cette restriction est-elle temporaire ? C’est possible, mais on peut noter que la recherche visuelle a été supprimée sur la page principale du site d’Apple dédiée à iOS 15, ce qui est peut-être le signe qu’un nettoyage est en cours et que la fonction sera réservée aux États-Unis jusqu’à nouvel ordre.

Pour finir, rappelons que vous pouvez choisir d’utiliser votre iPhone ou iPad configuré en anglais et aux États-Unis. Le changement s’effectue dans les Réglages, section « Général » puis « Langue et région ». Du côté de l’app Photos, ce changement semble s’accompagner d’une nouvelle indexation des données, ce qui ne me permet pas de confirmer que la recherche visuelle est bien activée sur mon iPhone.

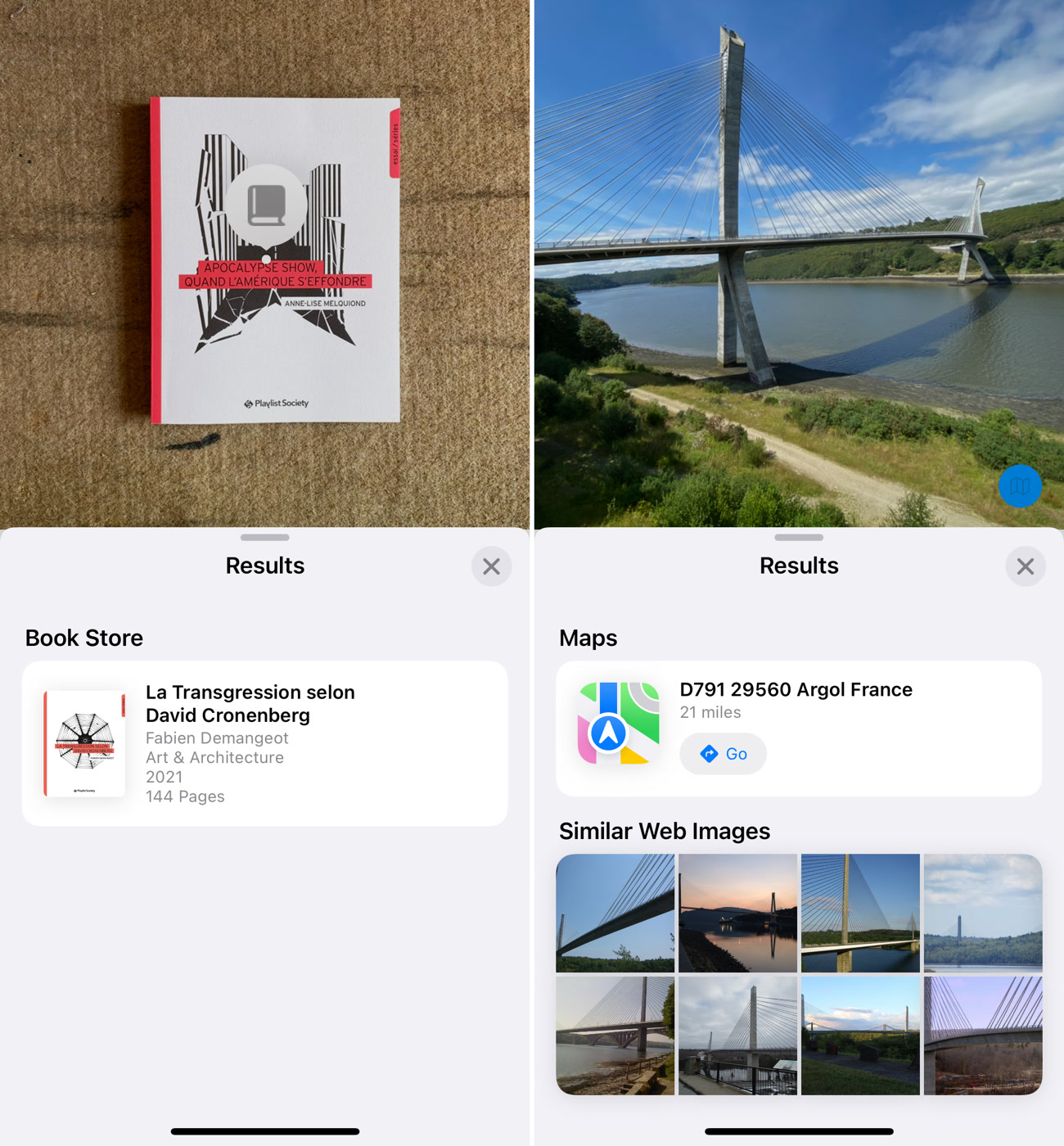

Mise à jour le 27/09/2021 08:46 : après quelques minutes, la fonction recherche visuelle est bien apparue sur mon iPhone configuré aux États-Unis. Voici quelques exemples d’éléments « faciles » correctement identifiés par l’app :

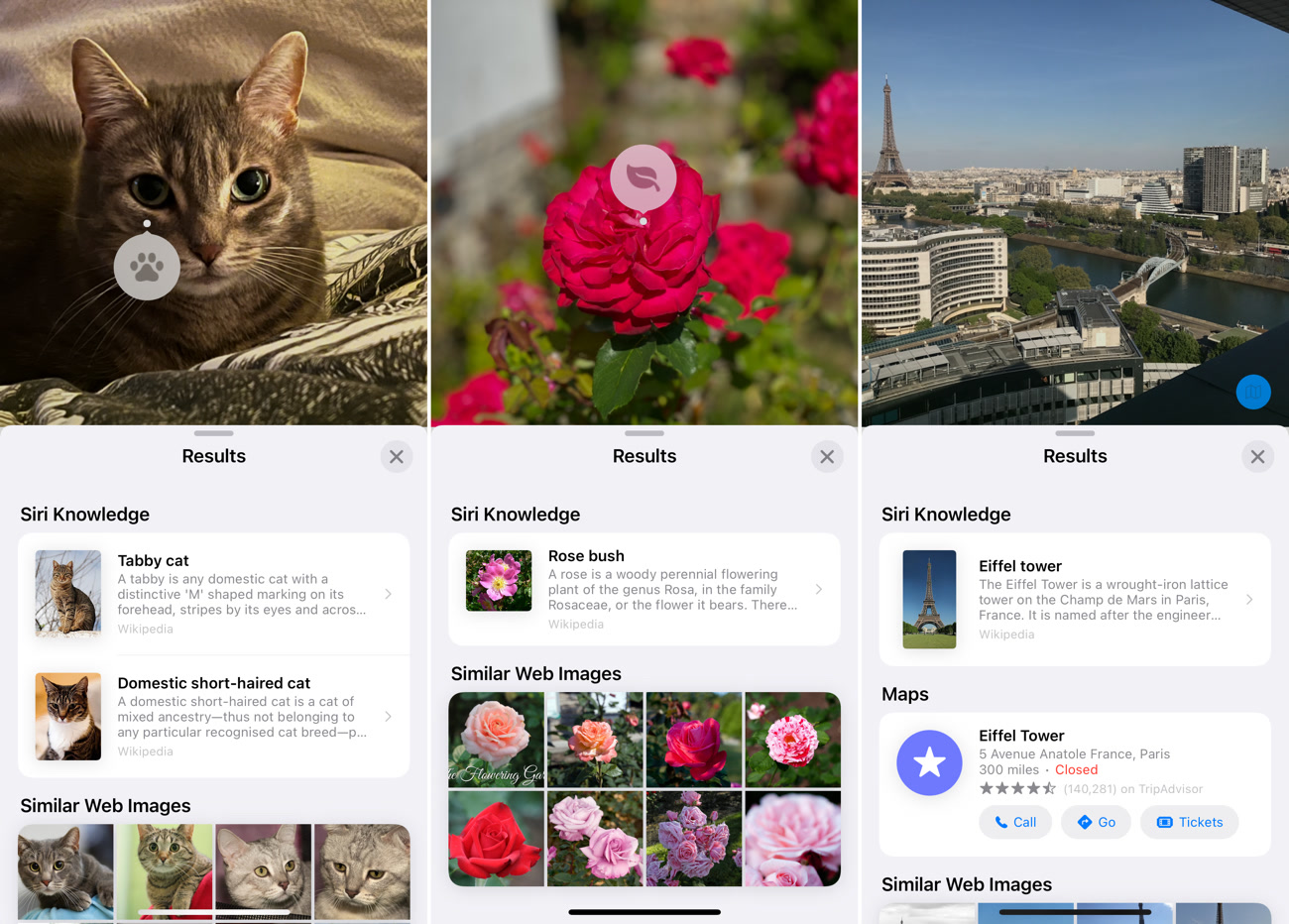

Puisque la fonction est pensée pour un autre pays, vous n’obtiendrez pas toujours le résultat attendu, néanmoins la recherche visuelle peut s’avérer surprenante dans certains cas. Ici, le livre trouvé n’est pas le bon, mais la couverture de celui suggéré est visuellement très proche et on peut comprendre son erreur. Quant au pont, il est trop mineur pour être identifié par son nom (pont de Ténérez), mais les coordonnées de la photo permettent de le positionner au bon endroit ; par contre, les autres photos n’ont rien à voir avec ce pont précis.

Source :