Lors de la présentation du système sur puce des nouveaux iPhone — A19 dans l'iPhone 17, A19 Pro dans les iPhone Air et 17 Pro —, Apple a mis en avant une innovation : la partie graphique intégrée dans l'A19 Pro (ce qu'on appelle le GPU) est maintenant capable d'accélérer les calculs liés à l'IA, ce qui permet des gains assez importants face au coprocesseur intégré historiquement (le NPU), qui reste tout de même présent.

Posons les bases, pour bien comprendre les choses. Le NPU, pour Neural Processing Unit, est un des blocs des systèmes sur puce d'Apple depuis quelques années (dès l'A11). Sur le papier, il singe les réseaux neuronaux d'un véritable cerveau, même si dans la pratique les NPU sont essentiellement des composants extrêmement optimisés pour effectuer une tâche précise. Dans le cas d'Apple et des intégrations dans les systèmes sur puce au sens large (chez AMD, Qualcomm, Intel, etc.), le choix a été fait de proposer des performances correctes — Apple ne le précise pas, mais probablement au moins 35 TOPS, comme une puce A18 Pro — et une consommation faible.

C'est un choix intéressant pour des tâches qui nécessitent une accélération des calculs liés au machine learning mais n’exigent pas une grande puissance de calcul. Pour identifier des objets grossièrement sur une image, générer des sous-titres, flouter l'arrière-plan d'une webcam et des dizaines d'autres tâches, un NPU fait généralement l'affaire avec une demande en énergie réduite, sans devoir impliquer le CPU ou le GPU. Ce n'est pas gravé dans le marbre : il est possible de créer des composants avec une très grande puissance (et une consommation à l'avenant), ce que Google fait avec les TPU de ses serveurs.

Le GPU, lui, est le nom générique pour la puce principale d'une carte graphique, et par extension pour le bloc qui effectue les calculs dans un système sur puce. Un GPU est à l'origine pensé pour du rendu 3D, mais a évolué avec le temps : les GPU modernes peuvent effectuer des calculs génériques et maintenant des calculs pour un usage assez précis, ce qu'on appelle de façon assez générique l'IA. Entendons-nous bien : il est déjà possible d'effectuer des calculs sur un GPU, et il s'agit même d'une solution efficace. Ce sont des composants capables d'effectuer de nombreuses opérations simples en parallèle, souvent plus rapidement qu'un processeur classique.

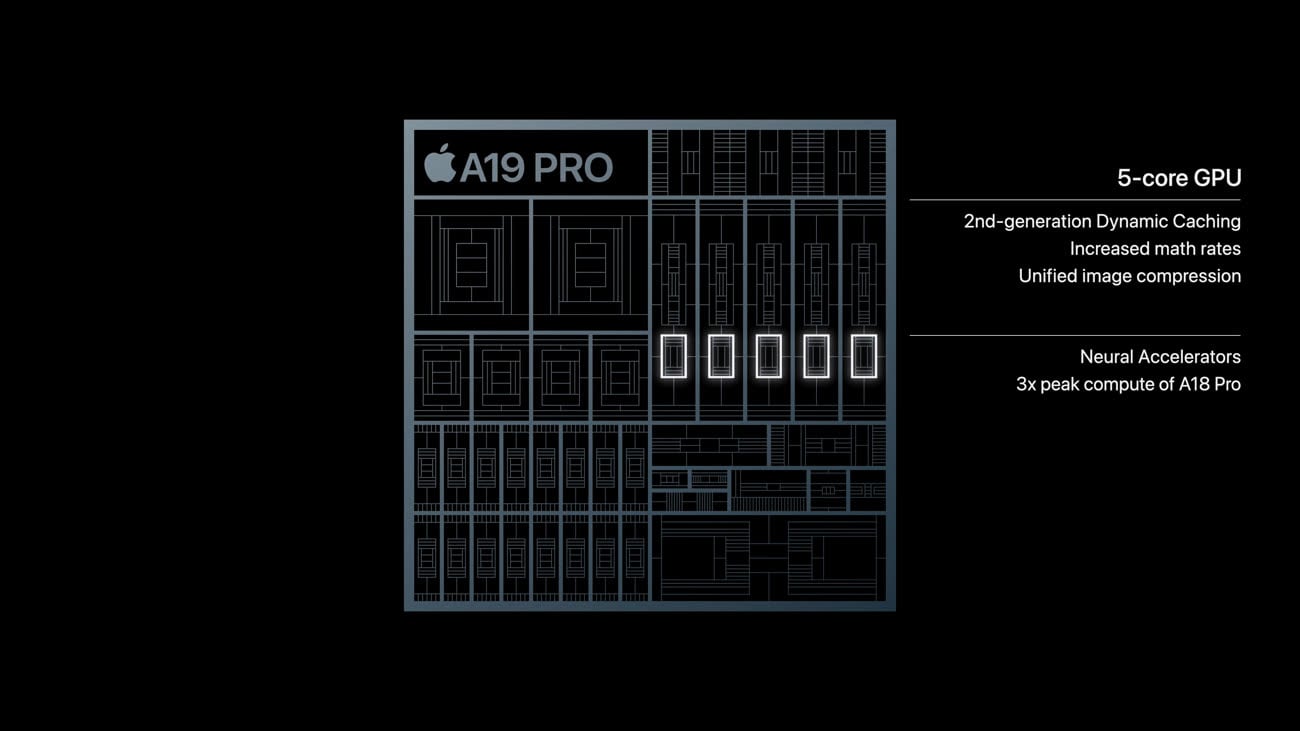

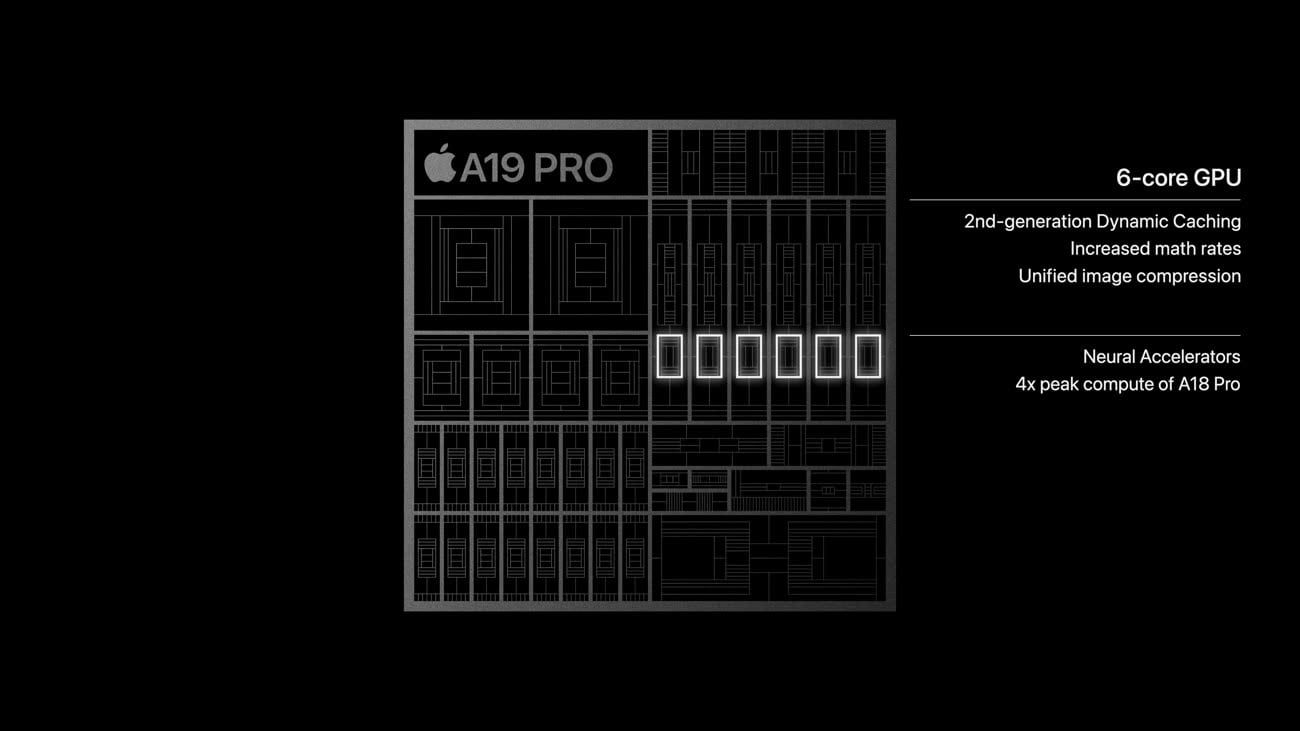

La nouveauté des GPU des iPhone est une optimisation déjà mise en place par Nvidia depuis plusieurs années : des unités dédiées dans le GPU pour effectuer certains types de calculs précis, notamment sur des matrices. Dans les GeForce, Nvidia appelle les unités en question des tensor core et ils sont plus ou moins nombreux, en fonction des cartes graphiques et des choix de Nvidia. Dans le cas d'Apple, ils permettent des gains intéressants : dans le keynote, l'accélération via le GPU est donnée comme jusqu'à 4x plus rapide que le NPU de l'A18 Pro, soit environ 140 TOPS.