En un an, le domaine des intelligences artificielles génératives a évolué de manière considérable. Non seulement ChatGPT n’est plus l’unique robot avec lequel vous pouvez discuter, mais en plus vous pouvez faire vivre ceux-ci sur vos propres appareils. Alors que nous vous avions expliqué au printemps dernier comment exécuter un grand modèle de langage sur votre Mac, il est depuis devenu possible de faire de même rien qu’avec votre iPhone.

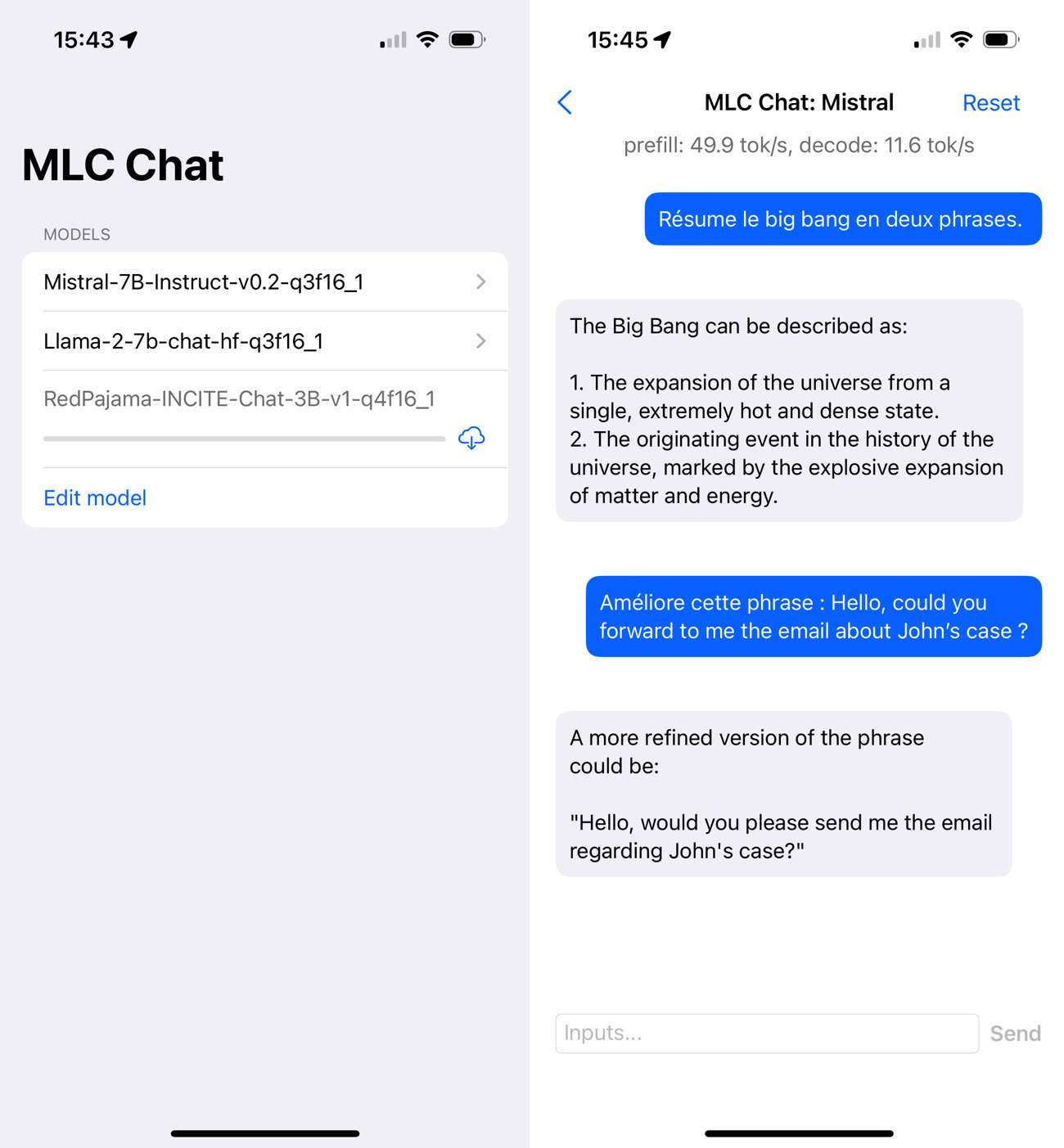

Parmi les applications iOS du genre, il y a notamment MLC Chat, qui a l’avantage d’être gratuite et open source. L’application pèse pas moins de 3,3 Go car elle embarque par défaut Mistral 7B (« 7B » pour 7 milliards de paramètres), un modèle libre créé par la start-up française Mistral AI. L’intégration de Mistral 7B est intéressante, car ce modèle est globalement meilleur que Llama 2 7B, le modèle mis à disposition gratuitement par Meta (et disponible en option dans MLC Chat).

Grâce à MLC Chat, vous pouvez donc utiliser Mistral sans connexion internet. Vous pouvez lui poser toutes sortes de questions, lui demander de résumer un texte, lui faire traduire des phrases, etc. Par rapport à ChatGPT, les réponses mettent un peu plus de temps à arriver et elles sont généralement moins pertinentes — l’assistant a la fâcheuse tendance à privilégier l’anglais, entre autres choses.

L’utilisation de MLC Chat fait chauffer rapidement l’iPhone — un iPhone 15 Pro lors de mes essais —, signe que les calculs demandent beaucoup de puissance. L’éditeur de l’application recommande d’ailleurs un appareil avec au moins 6 Go de RAM pour Llama-7B. Tous ces inconvénients (lenteur relative, modèle moins perfectionné, forte consommation de ressources) font qu’il reste plus agréable d’utiliser ChatGPT, mais il faut bien mettre les choses dans leur contexte. Il y a d’un côté une IA générative propriétaire qui tourne sur de gros serveurs, de l’autre un modèle de langage ouvert exécuté par un iPhone.

Apple est en train de s’attaquer aux défauts actuels des IA génératives locales en développant ses propres technologies, du modèle de langage jusqu’à son cadre d’exécution pour, qui sait, créer un Siri moins bête.