Amazon est en train d'ajouter des commandes vocales à Alexa pour faciliter la suppression des enregistrements vocaux réalisés par une enceinte. La requête ne semble pas encore disponible en français, elle devrait être du type « Alexa, efface tout ce que j'ai dit aujourd'hui ». Plus tard, une autre commande permettra de supprimer ce que l'on vient juste de dire.

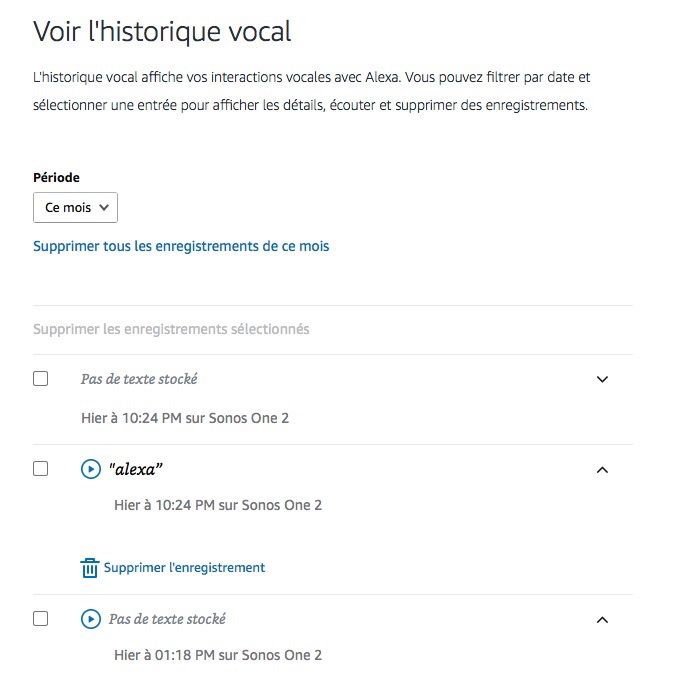

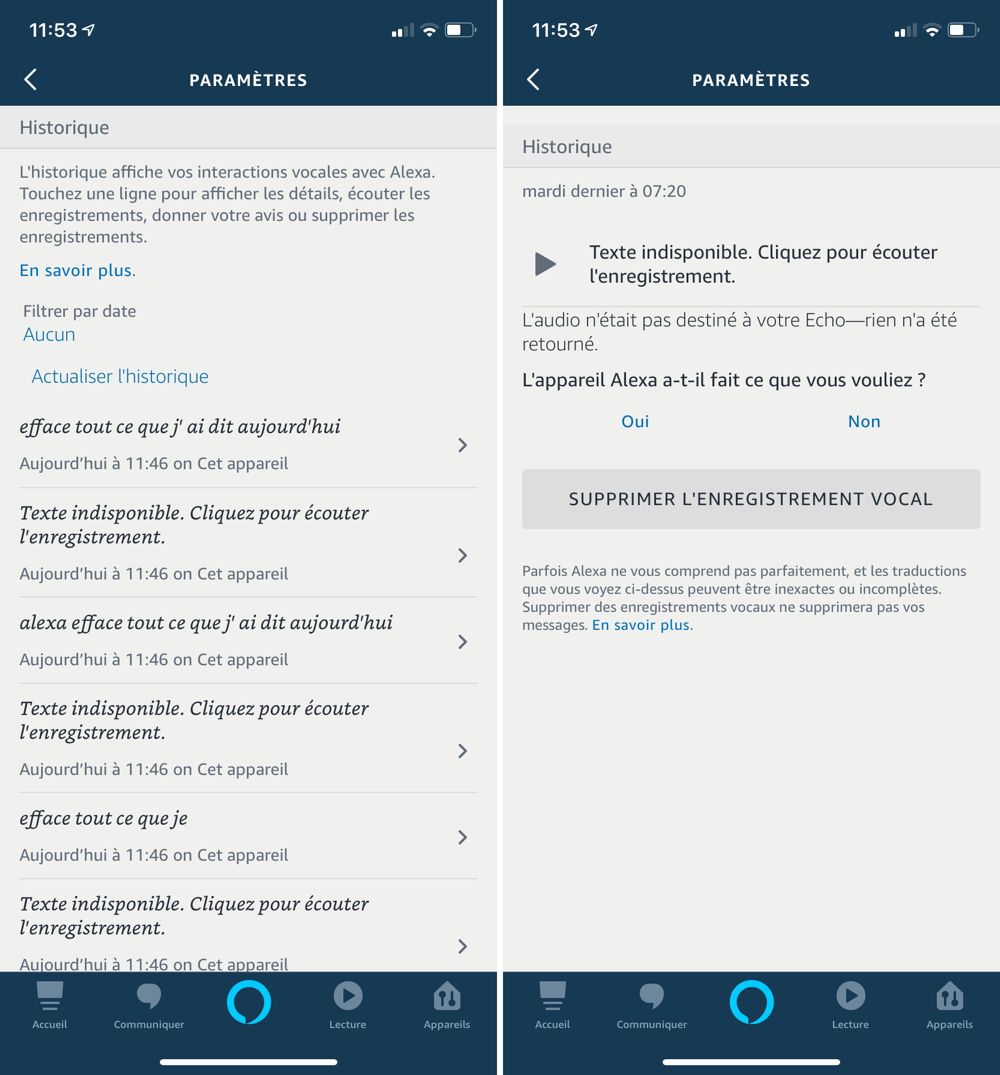

Jusque-là Amazon permettait de supprimer ces bribes de conversation avec son assistant depuis l'application ou depuis son site, mais pas avec la même facilité. Sur le site, on peut supprimer tout ou partie de ces éléments d'un coup, alors que dans l'app c'est seulement un par un.

Tant sur le site que dans l'app Alexa (Paramètres > Compte Alexa > Historique) on peut réécouter les quelques secondes de l'enregistrement audio qui a suivi le déclenchement d'Alexa.

C'est là qu'on verra que chaque fois que l'assistant se déclenche par erreur, un enregistrement d'environ 5 secondes est conservé avant qu'Alexa ne réalise qu'aucune commande ne lui était destinée. C'est l'inconvénient d'avoir "Alexa" comme mot-clef, les enceintes compatibles Amazon ont une fâcheuse tendance à réagir pour un oui ou pour non. Même un bruit, à la sonorité proche "d'Alexa", suffit à les activer.

Cette évolution d'Alexa va dans le sens d'une réponse à des critiques récentes sur l'accès à ces enregistrements par des employés d'Amazon (lire Les oreilles humaines d'Alexa ont accès aux adresses des utilisateurs). Mais ce nettoyage demandé par l'utilisateur, pour qu'il soit vraiment utile, doit se faire intégralement, sans qu'il reste des miettes.

Il y a quelques jours, Amazon avait expliqué à CNET qu'elle disposait aussi d'une transcription textuelle de la captation audio et cette dernière subsistait sur certains de ses serveurs :

Lorsqu'un client efface un enregistrement audio, nous supprimons aussi de nos systèmes Alexa principaux, et de plusieurs dépendances, la transcription textuelle correspondante, qui est associée au compte client.

Cependant d'autres serveurs pouvaient conserver une copie de ces données. Elles étaient donc effacées… mais pas complètement. « Nous avons un chantier en cours pour les supprimer des sous-systèmes restants » a ajouté Amazon.

Source :