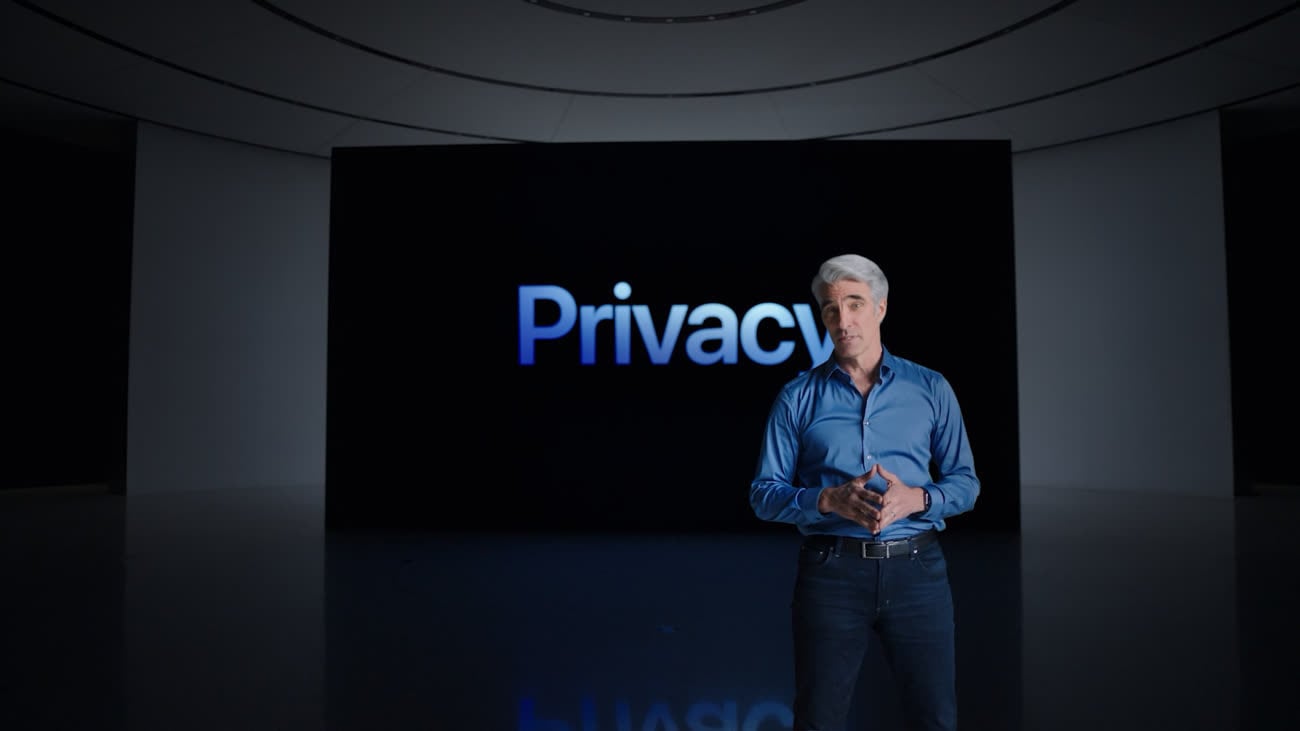

Craig Federighi reconnait qu'Apple a très mal communiqué sur les mesures de lutte contre la pédopornographie

Le moins qu'on puisse dire, c'est qu'Apple a complètement loupé la communication autour de ses mesures pour la protection des enfants. Des chercheurs en sécurité aux employés, de la concurrence aux observateurs avisés, beaucoup de monde s'accorde à dire que le constructeur s'est tiré une balle dans le pied. Certes, la Pomme a promis de s'expliquer, mais jusqu'à présent ces efforts n'ont pas vraiment réussi à balayer les doutes.

Bref, il fallait monter d'un cran et c'est nul autre que Craig Federighi qui monte au créneau dans une nouvelle interview au Wall Street Journal. « Au niveau de la compréhension des choses, c'est clair que beaucoup de messages se sont assez mal mélangés », admet le vice-président à l'ingénierie logicielle. « Nous souhaitons que ce soit un peu plus clair pour tout le monde, parce que nous pensons que ce que nous faisons est très positif ».

En annonçant plusieurs mesures n'ayant techniquement rien à voir entre elles, à savoir le floutage d'images sexuellement explicites dans Messages lorsque l'utilisateur est un enfant, et le scan de la bibliothèque de photos iCloud pour les images pédopornographiques, Apple a entretenu la confusion. Les photos innocentes des bambins en train de prendre leur bain allaient-elles être signalées à Apple comme étant pédopornographiques ?

« Avec le recul, l'annonce de ces deux fonctions en même temps allait effectivement créer de la confusion », convient Federighi. « Les gens ont connecté [ces deux fonctions] entre elles et ont eu très peur : que se passe-t-il avec mes messages ? La réponse est… rien. Rien ne se passe avec vos messages ».

Mais passé ce mea-culpa, pas question de revenir sur les mesures. Craig Federighi assure encore une fois que l'analyse de détection des photos pédopornographiques dites CSAM (Child Sexual Abuse Material) ne pourra pas être exploitée par des gouvernements autoritaires pour débusquer des opposants politiques. Apple dément cette possibilité car le système a été développé de telle sorte qu'un usage hors CSAM est impossible dans la pratique.

Apple l'assure, les gouvernements ne pourront pas abuser du nouveau mécanisme de lutte contre la pédopornographie

« Nous, qui nous considérons comme des leaders de la confidentialité, nous pensons que ce que nous faisons ici est à la pointe du progrès », ajoute-t-il. Le mécanisme repose sur une correspondance entre une base de données d'identifiants numériques d'images pédopornographiques et les photos de l'utilisateur.

Plus précisément, il s'agit de comparer des suites de chiffres : les images présentes dans l'iPhone sont converties par l'appareil en des numéros hachées par un processus cryptographique (baptisé NeuralHash). Ce processus de comparaison est réalisé sur l'appareil en local, avant que les images soient téléversées dans la bibliothèque iCloud Photos de l'utilisateur.

En cas de correspondance avec la base de données, la photo uploadée s'accompagne d'un « bon de sécurité » ainsi que d'un « dérivé visuel ». À partir d'un certain nombre de correspondances, Apple peut déchiffrer le contenu du bon de sécurité, une opération qui est ensuite visée par un opérateur humain. Craig Federighi révèle que ce nombre de correspondances a été fixé à « quelque chose comme » 30 images pédopornographiques connues.

Ce n'est que lorsque ce seuil est atteint qu'Apple sait « quelque chose de votre compte et même à ce stade, on ne connait que ces images, pas les autres images ». Il poursuit : « Ça n'a rien à voir avec les images de votre enfant dans son bain. Ni même avec des images pornographiques qui seraient en votre possession. Ce système se contente d'examiner les correspondances entre les signatures numériques de vos photos avec des images pédopornographiques connues ».

Pourquoi ne pas s'être contenté de scanner les photos uniquement sur les serveurs, comme le reste de la concurrence depuis des années et comme Apple le faisait déjà elle-même ? Le processus réalisé sur l'iPhone permet aux chercheurs en sécurité de regarder ce qui se passe dans iOS, explique-t-il en substance. « Donc, si des changements étaient apportés pour étendre la portée [du système de détection] d'une manière que nous nous étions engagés à ne pas faire, il y a un moyen de le vérifier, ils peuvent repérer ce qui se passe ».

Apple jusque-là en retard dans la lutte contre la pédopornographie

Sur ce plan, Federighi en dit trop ou pas assez. En dehors de l'iPhone SRD fourni à des chercheurs en sécurité triés sur le volet, il n'existe aucun moyen officiel de lever le capot d'iOS pour en vérifier le code. Peut-être qu'Apple a en projet d'ouvrir un peu sa boîte noire afin que des spécialistes puissent vérifier la réalité de son fonctionnement ? Il existe aussi des manières officieuses de jeter un œil dans le code, comme les rumeurs s'en sont fait une spécialité.

Le vice-président ajoute que la base de données des photos pédopornographiques ne provient pas uniquement du National Center for Missing and Exploited Children (NCMEC) il y a au moins deux organismes dans des « juridictions distinctes » et qu'un auditeur indépendant sera en mesure de vérifier si cette base de données ne contient que des images fournies par ces groupes. Une manière de s'assurer que le fichier ne contient pas d'autres photos n'ayant rien à voir avec le sujet.

@raoolito

Mais est-ce que ton monde vaut une surveillance généralisée de la population? Avec le risque que ça finisse en dictature, pour l'instant tu n'as rien à te reprocher donc ça te concerne pas, mais demain?

pour quelle raison Apple voulait instaurer la dictature ?

@marenostrum

De toute évidence cette initiative part d’une bonne intention . Là n’est pas le débat.

il faut pas s'inquiéter alors. sinon on risque de paraitre coupable.

@marenostrum

Tu as déjà entendu parler d’interpol ? Le principe est de mettre en connexion les polices du monde entier pour que les criminels ne puissent pas s’échapper. A la base, il n’y que les criminels qui craignent quelque chose. Sauf que certains pays (Chine, Russie, Iran…) ont pollué les notices rouges d’Interpol avec des opposants politiques. Demain, comment garantir que la base d’Apple secrète ne sera pas détournée?

@marenostrum

Je sais pas si t'es au courant mais pleins de pays sont des dictatures déjà... Et si tu surveilles tout le monde il est facile pour une démocratie de basculer dans la dictature.

mais qu'est ce que un pays a à faire avec Apple ? je comprends pas. Apple n'est pas pays. et en plus qu'es ce que ce pays a à faire avec nous, les clients de Apple ? s'ils veulent pas de Apple, pourquoi pas ? mais qu'es ce que ça peut nous foutre ?

Apple va partir ailleurs et c'est tout. en plus les pays que tu parles font tous comme Apple, ils condamnent les pedo files. t'es pas cohérent je crois.

@raoolito

« Je veux un monde sans pedophile, sans terroriste, sans trafiquant de drogue, etc… »

Une sorte de «Imagine» de john Lennon en mode Bad trip.

@raoolito

« Je veux un monde sans pedophile, sans terroriste, sans trafiquant de drogue, etc… »

Moins de pedophiles, de terroristes et de trafiquants de drogues me paraît être un objectif plus raisonnable ..

@raoolito

« sans pedophile »

Toujours la même confusion avec pédocriminalité.

On choisit pas d’être pedophile, et il y aura toujours des gens qui en souffrent. Et peu qui passeront à l’acte.

« sans terroriste »

Le terroriste n’est bien souvent qu’un opposant politique ou idéologique.

Une Russie sans les « terroristes » de Poutine ? Une Chine sans les « terroristes » de Pékin ?

Vraiment ?

« sans trafiquant de drogue, etc… »

Euh… On peut peut-être se passer des grands narcotrafiquants surtout quand ils deviennent narcoterroristes ou infiltrent les états et les sociétés.

Mais les petits artisans, s’ils n’étaient pas là, qu’est-ce que je mettrais dans mon Nesquik ?

« etc.. »

Ce etc veut tout dire.

Tu veux en fait un monde de gens qui sont comme toi, pensent comme toi, ont les mêmes goûts que toi, etc…

Moi, un monde de raoolito, ben, non, en fait.

Un monde plus apaisé ne sera pas un monde sous surveillance de masse, mais un monde avec un meilleur partage des ressources et des richesses…

@Bigdidou :

« Ce etc veut tout dire. »

Exact. C'est ce "etc" qui représente un des principaux problèmes avec le mécanisme qu'Apple va mettre en place en local dans les iPhone de tous les utilisateurs, sans leur laisser le choix (iOS 15 finira rapidement par être obligatoire).

Personne ne nie qu'il faut lutter contre la pédo-criminalité et la pédo-pornographie. Par contre, dire "tous les moyens sont bons, si vous n'avez rien à vous reprocher vous n'y verrez pas de souci, parce que c'est Apple on peut avoir confiance, et ce n'est pas la faute de l'entreprise si le mécanisme est utilisé à mauvais escient ou piraté", c'est totalement irréel. -_-

@webHAL1

« c'est totalement irréel. -_-«

Le problème, c’est que c’est un mouvement de fond.

On a accepté beaucoup de choses, moi le premier, contre le terrorisme, puis la COVID, puis maintenant contre des choses graves mais qui n’ont plus de caractère d’urgence et de masse.

Et, effectivement, on en arrive à logique du tous coupables jusqu’à preuve du contraire…

L’idée qu’on vienne sonder les photos sur mon terminal, peu importe avec quelles garanties, est extrêmement dérangeante et une limite que je ne veux pas voir franchir.

Elle ouvre trop choses derrière, et il y a un moment où il faut dire non.

Quant au débat sur ke caractère geek et microcosmique, il est de mon point de vue non pertinent puisqu’il nie au fond tout le principe général du lobbying.

Oui, des gens qui se préoccupent d’une question de société ou d’une question technique (au hasard la santé, la préservation de l’environnement, de nos libertés) sont souvent très minoritaires, débattent tout aussi souvent sous les radars et pourtant ils font bien changer les choses.

@Bigdidou :

« On a accepté beaucoup de choses, moi le premier, contre le terrorisme, puis la COVID, puis maintenant contre des choses graves mais qui n’ont plus de caractère d’urgence et de masse.

Et, effectivement, on en arrive à logique du tous coupables jusqu’à preuve du contraire… »

Chaque pays est différent, en Suisse je n'ai pas l'impression que la situation soit similaire à celle de la France, mais il me semble tout de même important de ne pas confondre ce qui est accepté venant de l'état et encadré par de lois, par rapport à ce qui est accepté venant d'entreprises privées.

Sinon, je te rejoins tout à fait pour ce qui est des populations qui se préoccupent du problème. Il est complètement normal que ça soit les technolophiles qui s'en soucient en premier lieu, et qui tirent la sonnette d'alarme. On voit d'ailleurs que cela commence à de diffuser dans les médias plus grand public, ce qui est une très bonne chose.

@webHAL1

« mais il me semble tout de même important de ne pas confondre ce qui est accepté venant de l'état et encadré par de lois, par rapport à ce qui est accepté venant d'entreprises privées. »

C’est ce que je voulais dire.

La « ligne jaune » apparaît là, dans ces initiatives du privé, mais les circonstances nous y ont préparé, en quelque sorte.

@raoolito

On voit que ça t’es jamais arrivé de te faire exclure de Facebook ou de Twitter suite à une erreur de leur algorithme, jamais appelable. Ou pire, te faire arnaquer par quelqu’un de malveillant qui a des raisons de t’en vouloir et va créer des faux.

@Ajioss

Apple doit respecter la loi. La loi U.S. les oblige à signaler activement les photos pédopornographiques. Pas seulement en réaction à une demande des autorités. Ils ne font qu’implémenter cette obligation de la façon la plus respectueuse possible (selon eux) de la vie privée.

Autrement dit, ils n’ont pas le droit de ne pas agir dans ce domaine.

@hptroll

Bah c’est simple alors. Pourquoi Apple ne donne pas tout simplement cette explication ? La polémique aurait été tuer dès le premier jour.

@Ajioss :

Simplement parce que c'est faux. Aucune loi américaine n'oblige Apple à installer en local, sur tous les iPhone à travers le monde faisant tourner iOS 15 un mécanisme qui va scanner l'intégralité des photos de l'utilisateur.

Certains ici font semblant de ne pas le comprendre, mais c'est bien L'APPROCHE (le "comment") choisie par Apple qui constitue une porte dérobée et un risque important pour la vie privée des utilisateurs d'iPhone, et non pas le MOTIF pour lequel elle le fait (le "pourquoi").

Par exemple : http://www.slate.fr/story/214275/apple-iphone-lutte-pedopornographie-nouvelles-mesures-surveillance-vie-privee-inquietudes

[🙄 Modéré. MB]

Un thread intéressant au lieu de commentaires assez idiots qu’on peut lire ici https://twitter.com/mathishammel/status/1425523073806110720?s=21

intéressant en quoi ?

Que le problème soulevé n'est pas technique mais juridique et politique.

« Craig Federighi assure encore une fois que l'analyse de détection des photos pédopornographiques dites CSAM (Child Sexual Abuse Material) ne pourra pas être exploitée par des gouvernements autoritaires pour débusquer des opposants politiques »

Comme Apple le dit lui même, la seule chose qui empêche ça c’est la volonté d’Apple. Je cite : « Apple will refuse any such demands ».

Là ou avant Apple disait « on ne peut pas » il dirait maintenant « on ne veut pas » (et nous n’aurons rien pour le vérifier). Ce n’est pas du tout la même chose.

Cet outil est une backdoor. C’est tout.

Et je ne parle même pas des éventuelles failles, vu la passoire qu’est déjà l’iPhone.

d'accord, mais qu'est ce que Apple gagne ? pourquoi ils prennent l'initiative sans que personne les oblige le faire ?

@marenostrum

Apple gagne les parents inquiets pour leurs enfants. Un très beau marché.

@TiTwo102 :

Tout à fait d'accord. Sans parler de ce passage :

« Sur ce plan, Federighi en dit trop ou pas assez. En dehors de l'iPhone SRD fourni à des chercheurs en sécurité triés sur le volet, il n'existe aucun moyen officiel de lever le capot d'iOS pour en vérifier le code. »

Toute explication d'Apple comme quoi ce n'est pas une porte dérobée n'est absolument pas crédible. Et c'est bien pour cela que de nombreux spécialistes de la sécurité de par le monde s'inquiètent.

@raoolito

ton monde n’est pas un monde humain mais un monde ou tout le monde aurait été lobotomisé ou conditionné - tout cela pour éviter le 1/100 000 des cas que tu cites - bref 99 999 innocents pour 1 coupable - qui ne passera d’ailleurs peut-être jamais à l’acte.

Ensuite si l’infrastructure est mise en place quelle garantie qu’elle servira ces objectifs et non d’autres particulièrement néfastes?

c'est à toi de faire confiance ou pas. comme partout en fait. tu vas plus dans un resto dès tu sens que la qualité du service baisse, t'achètes plus un produit qui te déçoit, etc. faut faire pareil dans ce cas. ne plus acheter Apple. y en a pas d'autres solutions.

@marenostrum

"c'est à toi de faire confiance ou pas. comme partout en fait. tu vas plus dans un resto dès tu sens que la qualité du service baisse, t'achètes plus un produit qui te déçoit, etc. faut faire pareil dans ce cas. ne plus acheter Apple. y en a pas d'autres solutions. "

Simple et efficace. A la difference près qu’il y a près de 50,000 restaurants rien qu’a Paris (il te faudrait des dizaines d’annees pour tous les faire), tu peux tres facilement bouder et aller voir ailleurs, sauf qu’avec iOS, le choix est beaucoup plus restreint 🤨

tout à fait, le choix sera moindre dans ce cas. en tout cas moi je vais rester chez eux. je leur fais confiance, je suis trop petit pour être dangereux.

@marenostrum

"tout à fait, le choix sera moindre dans ce cas. en tout cas moi je vais rester chez eux. je leur fais confiance, je suis trop petit pour être dangereux. "

Pareil. Bon apres y a des limites, mais le jour où y a perversion du systeme et mauvaiss utilisation, si toutefois il y a, on va pas voir Apple communiquer la dessus, minimum de bon sens. Les mecs qui ont créé Pegasus l’ont pas clamé sur tous les toits… Donc toutes ces raleries, c’est mignon, m’enfin 😮💨

On va commencer par refuser la mise à jour iOS15...

Ça tombe bien, comme si Apple avait prévu cette réaction, il est désormais possible de renoncer à passer à la nouvelle version de l'OS.

Je ne vois nulle part que CF a « très mal » communiqué. Une interprétation de votre part.

Bla bla. On s’en fou royale.

Sauf si vous avez quelque chose à vous reprocher…

il suffit de mettre une photo connue dans l'appareil de quelqu'un pour l'envoyer au prison. ça peut t'arriver, si autour de toi tu as des gens qui t'aiment pas.

Pour info, parce que je trouve que pas mal de sources prêtent à confusion, MacG a déjà fait un article sur le fait qu’Apple scanne (scannait ?) déjà les photos sur iCloud, sur leurs serveurs:

https://www.macg.co/aapl/2020/01/la-lutte-contre-la-pedophilie-se-mene-aussi-sur-icloud-111201

Et également sur les pièces jointes des e-mails

https://www.macg.co/aapl/2020/02/icloud-details-sur-la-facon-dont-apple-gere-les-contenus-pedophiles-111919

@ElFitz

Merci pour l’info.

Ça explique la gaffe de leur part : ils le font déjà, les gens le savaient pas, ils ont cru qu’ils pourraient maintenant dénoncer à la police sans que ça fasse de bruit.

À la base, c’est juste un gage de bonne volonté auprès du FBI pour l’empêcher de légiférer sur une backdoor.

Mais non! Dénoncer au FBI ils le font déjà quand ils trouvent des photos correspondant à la base "officielle" des photos pedopornographiques sur iCloud ou en pièce jointe d'e-mail (l'affaire ci-dessous remonte à septembre 2019):

https://www.forbes.com/sites/thomasbrewster/2020/02/11/how-apple-intercepts-and-reads-emails-when-it-finds-child-abuse/?sh=1404b7b31c29

Donc si en désactive la bibliothèque iCloud, on n’est pas contrôlé par le système ?

Les personnes visés utilise le dark web pour échanger leur fichier. Ça serai étrange qu’il ne pense pas à désactivé une simple option.

C'est à peu près ça. Apple installe un mouchard dans 1 à 2 milliards d'appareils sans aucune chance de coincer le moindre délinquant sexuel...

Sachant qu'ils analysent déjà les photos stockées dans iCloud et les photos en pièces jointes d'e-mails passant par les serveurs iCloud (voir les articles qu'avait fait MacG sur ces sujets dont les liens sont rappelés ci-dessus) que cherchent-ils vraiment sur nos iPhones?

ton iPhone est scanné indépendamment du cloud. c'est une nouveauté de iOS 15. bref ils le savent eux quel genre de personne tu es. après le coud t'envoie en prison. ils ont la preuve.

en tout cas, Apple peut tout faire techniquement dans ton appareil à ton insu. installer, effacer, modifier, changer, etc. bref tu es dans leur mains. si t'es un bon client peut-être qu'ils se montrent gentils envers toi.

Apple et la vie privée déjà c’est une blague.

S’ils voulaient vraiment jouer à fond la carte de la vie privée alors iCloud n’existerait pas. Ou bien les données seraient hébergées ailleurs qu’aux USA.

Rien que de soumette au Patriot Act ou bien d’avoir installé des serveurs en Chine rendent déjà l’argument de la vie privée totalement commercial.

Mais ça fonctionne bien sur les ignorants…

Héhéhé…

Craig vendrait sa mère pour vendre Apple…

Sous forme d’éthique, ils ont de moins en moins de déontologie à Apple… tout (petit à petit) pour le traçage constant de tous!!!

Mais l’idée de départ est très bonne, la pedophilie est un acte immonde, mais idée très mal proposée et dangereuse. Même si certains états utilisent déjà cette technologie sans conditions…

Bonne explication et très bonne com’ Craig… tu viserais pas CEO??

Hum…

Je me demande combien de réseaux pédophiles ont été identifiés et démantelés sur iCloud ?

@Moonwalker

C’est un peu la question centrale que les petits paranos en herbe ont oublié. Est-ce que tout cela sera vraiment efficace ? Est-ce utile ? Sur quoi repose sa nécessité ? Peut on nous prouver que cela va vraiment aider la justice ?

L’explication est assez limpide sur le fait qu’il semble avoir aucune possibilité que le système accuse quelqu’un à tort. Le système semble fiable. Et pour ma part il ne me dérange pas, bien qu’il induise une idée assez dévastatrice. Mais ce que je veux savoir c’est : vous allez vraiment faire changer les choses avec ça ? On peut quand même en douter fortement.

Wow ça fait bien peur tout ça. Après l'affaire Pegasus où l'on apprend qu'on peut être facilement espionné à notre insu, vient cette histoire d'Apple qui met en place des backdoors, qui vont scanner tous les photos prises sur les iDevices. Sachant qu'Apple permet aussi aux traqueurs publicitaires de proliférer et donc de transmettre plein d'infos sur nos activités (moins que sous Android ceci dit), je suis d'avis que l'argument du respect de la vie privée chez Apple est de plus en plus relatif.

Je suis heureux d'être passé sous /e/ OS, même si le 0 faille n'existe pas, et même si avec la pression des états le respect de notre vie privée est en générale menacée.

Remplacez Apple par Google, ca serait le levée de boucliers dans les commentaires mais là, aucun soucis.

Je trouve les chercheurs en sécurité, les associations pour la vie privée aux états unis plus objectifs.

@Arnaudvietnam

« Remplacez Apple par Google, ca serait le levée de boucliers dans les commentaires mais là, aucun soucis. «

En cumulant tous les articles sur le sujet, de ces derniers jours on doit dépasser les 500 commentaires !

Édit : 1363 commentaires sur tous les articles traitant du système, depuis sa présentation le 5 Août !

Apple nous observera autant que les autres mais de manière différente voilà la conclusion de cette affaire.

Pages