Le moins qu'on puisse dire, c'est qu'Apple n'a pas su convaincre du bien fondé de ses nouvelles mesures pour lutter contre les abus sexuels des enfants. Dévoilés jeudi dernier, ces mécanismes ont provoqué une levée de boucliers de chercheurs en sécurité et d'organisations de défense de la vie privée.

Devant la bronca (prévisible) suscitée par cette affaire, Apple a prévu de communiquer tous azimuts et cela s'incarne dès aujourd'hui avec une foire aux questions que le constructeur aurait été bien avisé de publier dès l'annonce de ces mesures.

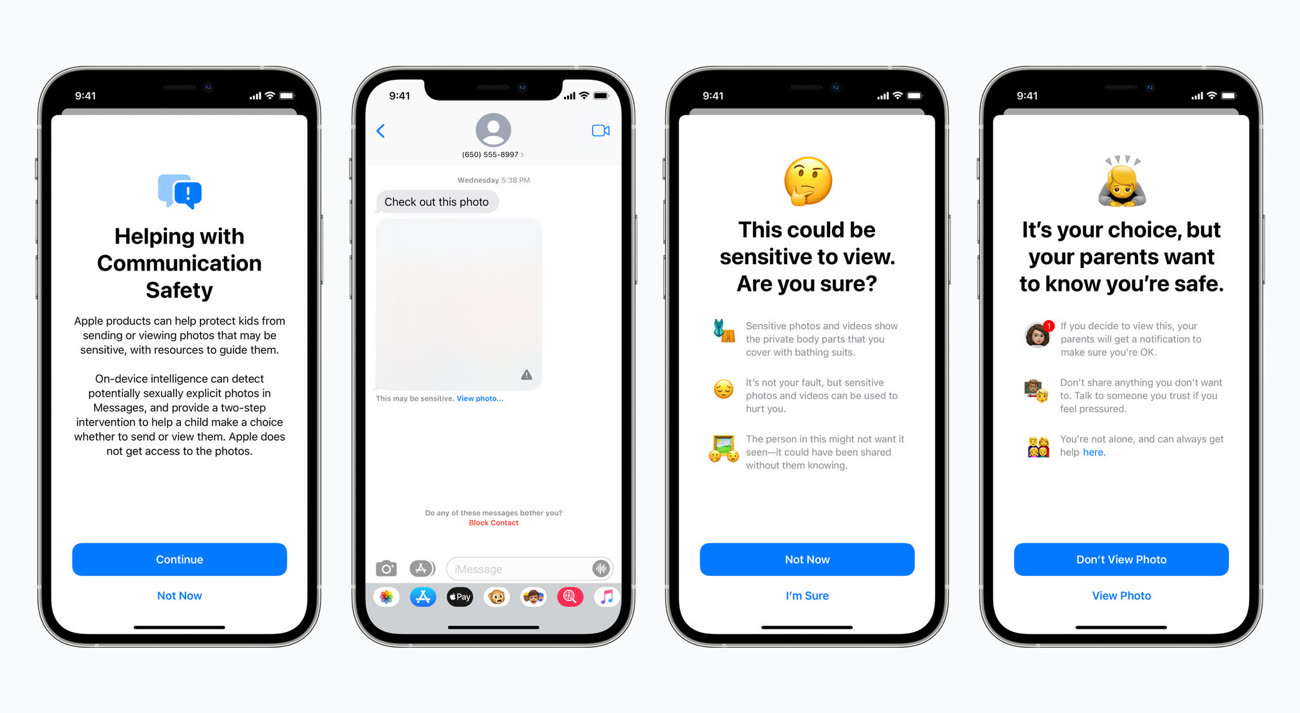

Le système de floutage des images dans Messages

En préambule, Apple éclaircit une première incompréhension : le système de floutage des photos sexuellement explicites dans Messages et celui qui détecte les photos pédopornographiques dans la bibliothèque iCloud sont différents et n'utilisent pas la même technologie.

Dans Messages, après activation de la fonction depuis les réglages du partage familial, les photos reçues ou envoyées sur l'appareil iOS d'un enfant enregistré au sein d'un partage familial sont analysées en local et floutées en cas de présence d'éléments explicites. Les parents peuvent être prévenus par notification du partage de la photo, mais uniquement pour les enfants de moins de 12 ans (c'est une option à activer) ; il n'y aura pas de notification pour les enfants de 13 à 17 ans.

Cette fonction de floutage se réalise en local et « Apple n'accède jamais aux communications » dans Messages. Le chiffrement des communications dans la messagerie est toujours réalisé de bout en bout, rien ne change ici.

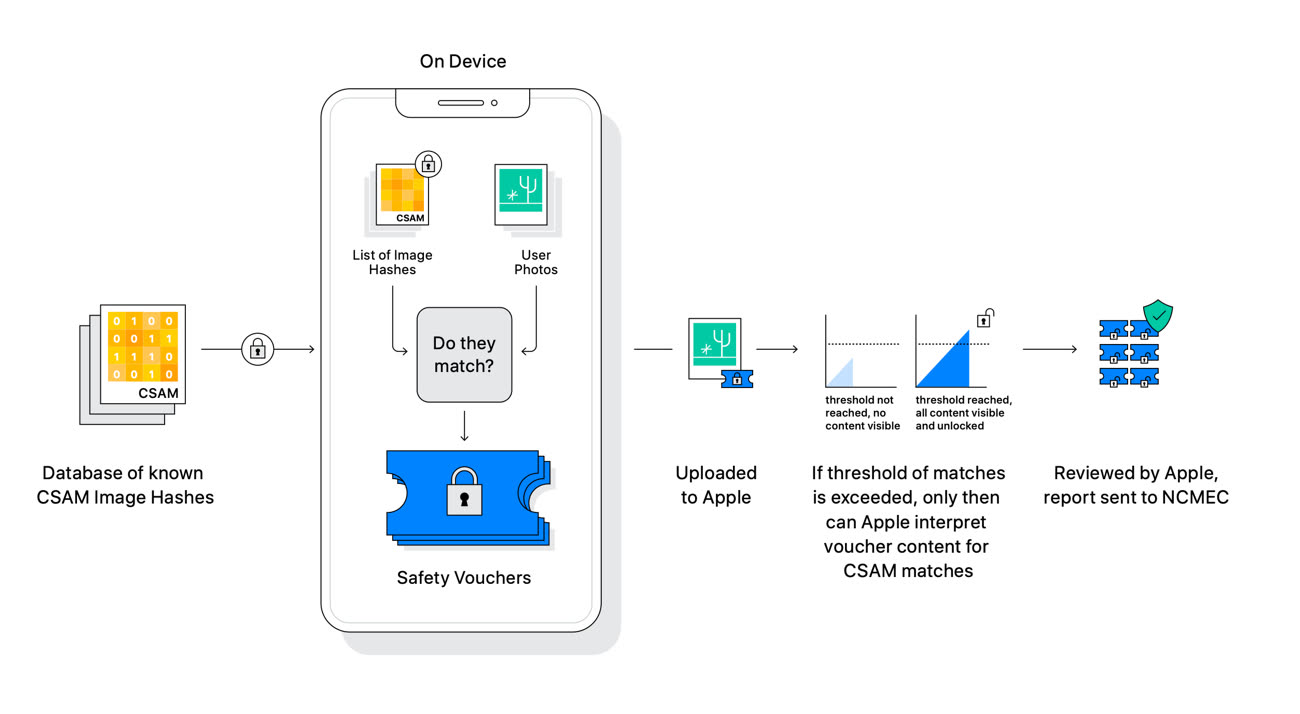

Le système de détection des photos dans la bibliothèque iCloud

Le système de détection des photos d'abus sexuels d'enfants (CSAM pour Child Sexual Abuse Material) n'a rien à voir avec celui de Messages. Apple souligne en préambule que ce mécanisme ne concerne que les photos téléversées dans la bibliothèque iCloud Photos. « Le système ne fonctionne pas pour les utilisateurs ayant désactivé la bibliothèque iCloud », martèle le constructeur.

Apple rappelle le principe global de détection CSAM. En local, il compare les photos de l'utilisateur à la base de données du National Center for Missing and Exploited Children (NCMEC), une association à but non lucratif, seule organisation habilitée à posséder de tels documents (leur possession est interdite dans de nombreux pays). Attention, Apple ne va pas télécharger sur des millions d'iPhone les photos de cette base de données, uniquement leurs hashes, c'est à dire des suites de chiffres.

« En utilisant de nouvelles fonctions cryptographiques, Apple est capable d'utiliser ces hashes pour savoir si les comptes iCloud Photos stockent des collections de photos qui correspondent aux images CSAM, et uniquement les images CSAM », précise le constructeur. Ce dernier ne saura rien des autres données stockées sur l'appareil.

Si Apple a pris la route d'une détection qui se déroule d'abord en local puis sur ses serveurs, c'est pour éviter les « risques sur la confidentialité » que font peser les autres systèmes utilisés par d'autres entreprises qui examinent les photos de leurs utilisateurs uniquement dans le nuage. « La détection CSAM dans iCloud Photos offre des bénéfices significatifs pour la vie privée, en empêchant Apple d'en apprendre davantage sur les photos des utilisateurs, à moins que celles-ci ne correspondent à des images CSAM ».

Apple cherche également à apaiser les craintes très fortes sur la sécurité de ses appareils et la confidentialité des utilisateurs. Le constructeur assure que son système ne peut servir à détecter autre chose que des images CSAM, et il faudra croire l'entreprise sur parole : « Apple refusera les demandes » des gouvernements qui voudront ajouter des images non-CSAM à la liste de hashes.

« Nous avons reçu des demandes de gouvernements pour bâtir et déployer des changements [dans la sécurité d'iOS] qui dégradent la vie privée des utilisateurs », déroule la FAQ. « Nous avons catégoriquement refusé ces demandes. Nous continuerons à les refuser à l'avenir. Soyons clairs, cette technologie se limite à la détection d'images CSAM stockées dans iCloud et nous n'accèderons à aucune demande d'un gouvernement pour l'étendre ».

Les promesses n'engageant que ceux qui y croient, Apple devra donner des gages sur ce point car ce qui se passe en Chine n'est guère encourageant.

Censure, sécurité des données : les compromissions d'Apple en Chine

Le système a été conçu de telle sorte que les hashes d'images « non CSAM » ne puissent être injectés dans la base de données : tous les iPhone et iPad recevront les mêmes hashes, donc les attaques ciblant des individus seront impossibles. Enfin, Apple précise qu'en cas de signalement, c'est un humain qui prend la relève et vérifie si la photo en question est bien litigieuse. La probabilité que le système signale de manière incorrecte un compte iCloud est « inférieure à un sur mille milliards par an ».

Mise à jour 20h30 — Dans une nouvelle séance de questions/réponses avec la presse US, Apple a indiqué que les fonctions de protection de l'enfance (pour Messages et la détection de photos pédopornographiques) pourraient être proposées à des éditeurs tiers. Par exemple, la fonction de floutage des photos sexuellement explicite pourrait être disponible dans WhatsApp, Instagram ou encore Snapchat. La détection des photos CSAM fonctionnerait avec d'autres nuages que celui d'iCloud.

Au vu de la réception pour le moins glaciale réservée par la concurrence à ces mesures (chez le patron de WhatsApp, par exemple), il n'est pas certain que l'on retrouvera de si tôt ces mécanismes ailleurs que chez Apple.