Les nouveaux systèmes d'Apple pour lutter contre la pédopornographie inquiètent

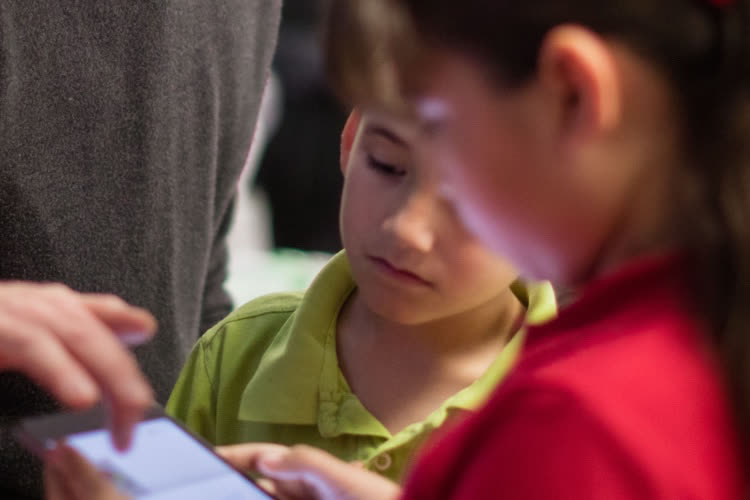

Les nouveaux mécanismes d'Apple pour lutter contre la pédopornographie ne plaisent pas du tout aux défenseurs et avocats de la vie privée, notamment à certaines ONG ou à Edward Snowden. Dans une série de tweets, le lanceur d'alertes a vivement critiqué ces mécanismes, qu'il compare à un moyen de surveillance global. « S'ils peuvent scanner des images pédopornographiques aujourd'hui, ils pourront scanner ce qu'ils veulent demain ». Il ajoute ensuite qu'Apple a « transformé mille milliards de dollars d'appareils en iNarcs [iMouchards]... sans demander ».

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

— Edward Snowden (@Snowden) August 6, 2021

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

Les retours négatifs ne se sont pas fait attendre non plus du côté de l'EFF (Electronic Frontier Foundation), qui estime que l'examen des photos revient à mettre en place une porte dérobée. L'ONG explique qu'il est impossible de construire un mécanisme côté usager qui sera seulement utilisé pour lutter contre la pédopornographie. Pour eux, un tel système (même bien intentionné) brise la promesse du chiffrement bout-en-bout et ouvre la porte à différents abus.

À l'avenir, il sera facile de modifier le mécanisme déjà existant pour le pousser à chercher d'autres types de contenus et pour signaler d'autres types de comptes. L'EFF imagine le cas d'un gouvernement autoritaire utilisant le système pour détecter les images révolutionnaires, satiriques ou liés aux causes LGBTQ+.

Le scan des photos iCloud est pointé comme une perte de confidentialité plutôt que comme une amélioration. L'ONG explique également que les notifications aux parents pourraient être envoyées de manière disproportionnée si l'algorithme n'est pas au point, par exemple en signalant des tableaux d'art ou des memes comme éléments anormaux. La critique est fondée : le système de Facebook fonctionne sur le même principe et se trompe régulièrement.

Enfin, l'organisation CDT (Center for Democracy and Technology) a exprimé ses craintes quant à l'utilisation des fonctions de notification aux parents par des adultes malveillants :

Les jeunes et les enfants LGBTQ vivant dans des foyers violents sont particulièrement vulnérables aux représailles, y compris de la part de leurs parents ou tuteurs. [Le système d'Apple] pourrait exposer par inadvertance des informations sensibles sur eux-mêmes ou leurs amis à des adultes, avec des conséquences désastreuses.

Avec cette technologie, Apple fait le pari risqué de remettre en jeu son image d'« entreprise de la confidentialité ». On le sait, Cupertino s'arrange parfois avec certains pays et les craintes évoquées par les militants sont loin d'être infondées. Les employés d'Apple s'interrogent aussi, au point que Sebastien Marineau-Mes, le vice-président en charge des logiciels, a diffusé un mémo annonçant des explications plus précises à venir afin d'éviter les quiproquos.

Lutte contre la pédopornographie : Apple veut répondre aux craintes et aux incompréhensions

@Paquito06

Pardon mais tu passes complètement à côté de la problématique de FOND.

@MarcMame

"Pardon mais tu passes complètement à côté de la problématique de FOND."

Qui est?

@Paquito06

Qui est qu’apple installe tranquillement (et sans moyen de desactiver) un soft qui permet de savoir si tu as sur ton iphone une photo précise. Le jour où apple veut pour une raison ou pour une autre savoir si t’as une photo x ou y, il leur suffira de rajouter un hash dans la db et hop.

Que ca parte d’une bonne intention n’annule pas le fait que la solution technique choisie ouvre la porte a bien trop de dérives potentielles.

Imagine qu’apple decide d’installer un soft pour activer le micro de tes devices constamment et appelle la police si un algo reconnait une situation qui le necessite, qu’en penserais tu?

@lord danone

"Qui est qu’apple installe tranquillement (et sans moyen de desactiver) un soft qui permet de savoir si tu as sur ton iphone une photo précise. Le jour où apple veut pour une raison ou pour une autre savoir si t’as une photo x ou y, il leur suffira de rajouter un hash dans la db et hop.”

Je crois que tu as repondu a sa place est a coté, du coup. Apple n’installe rien du tout. Apple se fout de savoir ce que tu as sur ton tel. Apple va comparer tes photos avec celles qui sont illegales, et fera cette comparaison quand tu les enverras dans le cloud. Ca s’arrete là, et j’espere que les mecs vont commencer a lire les articles avant de repeter des conneries depuis le debut. Quel hash? On parle d’enfants a poil qui se font sodomiser. La photo est chiffree, la clef est comparee a une base de donnees. Si Apple voulait, elle le pourrait deja depuis bien longtemps, on est en 2021, ils peuvent s’ils veulent, ils vont pas attendre ton consentement. Aujourd’hui ils rendent publique un mouveau systeme. Faudrait pas prendre les ingé, les departements legal et compliance d’Apple pour des teubés.

“Que ca parte d’une bonne intention n’annule pas le fait que la solution technique choisie ouvre la porte a bien trop de dérives potentielles. “

Mais si Apple avait voulu lire tes textos avec grand maman dans iMessage, ton historique Safari sur youporn, tes recettes de cuisine dans Notes et tes photos de vacances a Ibiza dans Photos, ils auraient pas sorti cette fonctionnalité. Quand on veut des infos sur quelqu’un, on ne previent pas, c’est la base, on agit.

“Imagine qu’apple decide d’installer un soft pour activer le micro de tes devices constamment et appelle la police si un algo reconnait une situation qui le necessite, qu’en penserais tu?"

Ah les theories complotistes, digne d’Hollywood ou des quelques dictatures qui tentent de survivre. Mais si Apple avait voulu mettre ca en place, ca aurait deja ete le cas depuis l’iPhone 2G! 🤣

@MarcMame

Oui et ce n’est pas dis que le hash des photos ne soit tout de même pas stocké dans le cloud sans demander de permission.

ok pour l'instant, l'algorithme cherche des ressemblance ./. à des photos pédophiles. très louable. Mais le jour où les PL ou HU font passer une loi qui oblige les fournisseurs de services de chercher les ressemblances ./. à des photos LGBT, on fait quoi ?

@ech1965

“à des photos LGBT, on fait quoi ? “

Oh, il y a plus simple.

Tiens, des choses équivalentes que j’ai vues (et pour lesquelles j’ai accompagné des patients, je me souviens d’une patiente traumatisée 20 ans après d’avoir été conduite à faussement accuser son père sur pression et manipulation de l’entourage. Père qui s’est pendu…) au travers de fausses accusations de pédophilie avec des manipulations, des témoignages et/ou des preuves construites.

Imaginons un divorce qui se passe mal.

On a oublié de désactiver certains partages, de réinitialiser certains codes et de mots de passe, ou pire, on passe par les enfants ou des proches.

Et voilà qu’on se retrouve sur son compte iCloud sans s’en apercevoir avec des photos… étranges.

Puis la police.

C’est pas de la SF, j’ai vu, non pas un paquet, mais quelques situations équivalentes.

Pour se sortir de ça, c’est un enfer.

@pocketjpaul

Arrête de rêver, l’autre crémerie en sait beaucoup plus que ca sur tes photos sur ses serveurs, Google a plusieurs années d’avance sur Apple en terme d’analyse de photo. C’est pas parce qu’ils en parlent pas qu’ils analysent pas.

@Rapsodan2

ce n'est pas une backdoor, c'est juste un scan des photos comme elle le fait deja pour les visages par exemple. tapez "facture" sur votre iphone et il va vous sortir les photos de factures.. qu'il a scanné. idem pour macos

là il enverra en plus un message. C'est tout

whaaaaaaw quel backdoor

@raoolito

La reconnaissance dont tu parles là se fait sur le téléphone. C’est quand même différent.

Apple n’est pas la Police du Monde.

@David Finder

ben c pareil ici, tout se passe sur le téléphone

"ca n'en sort" qu'en cas de plusieurs match répétitifs ( avec des photos de visages d'enfants enregistrés comme ayant subis des violences pedophiles.

@raoolito

Le truc c’est que ce n’est pas à une entreprise privée et étrangère de venir faire la police chez moi.

La prochaine étape c’est quoi ?

@macosZ

je peux comprendre mais elles le font toutes...

"là il enverra en plus un message. C'est tout"

beEEEen... S'il peut faire le faire pour une facture (et envoyer un message), il peut le faire pour une photo de Macron et envoyer un message à la police alors.

S'il peut le faire, il le fera.

@Rapsodan2

L’iPhone a toujours scanné les photos, localement en plus (contrairement à Android mais la ca choque personne). Ce qui est nouveau c’est le fait de prévenir en cas de contenu considéré comme anormal (définition qui évoluera dans le temps, c’est la que se trouve le risque) et la comparer avec une base de donnée qui confirmera ou pas que la photo est bien anormale. C’est exactement ce que fait Shazam mais la encore çà choque personne. C’est comme si Shazam levait une alerte quand tes enfants écoutent du rap et que tu veux intervenir avant que ça dérape pour les remettre dans le droit chemin. Si c’est bien fait, ils n’ont pas besoin d’avoir accès à la photo, donc pas de pb de vie privée jusqu’à ce que la bdd pedo confirme la correspondance, la ils récupèrent la photo iCloud comme preuve. Enfin c’est ce que moi j’aurais fait. C’est super facile à mettre en place un food que tu sais reconnaître un corps nu (ce qu’ils savent tous faire)

@cybercooll

Sauf que tu te contredis toi-même. L’iPhone a toujours scanné les photos en local.

Là, ça ne peut pas être en local, s’il faut les comparer avec une base de données.

Et Shazam ne te surveille pas. Là c’est autre chose.

@David Finder

Bah si. Pas besoin de l’image, il suffit de comparer les histogrammes. C’est beaucoup plus simple et ça reste anonyme sans transfert de quoi que ce soit. C’est beaucoup moins cher, plus rapide et probablement largement suffisant en terme d’efficacité

@David Finder

Sauf que vos photos ne sont pas analysé par Apple mais une signature…🤷♂️

Liste de signatures dans laquelle un état peut mettre ce qu'il veut. La Chine et les régimes autoritaires se frottent déjà les mains. Aujourd'hui la pédophilie, demain le "terrorisme", puis les contenus LGBT, puis les contenus des opposants, etc. Une fois la prote entrouverte on peut être qu'elle le sera toujours plus : comment ça vous êtes contre ? Vous êtes donc pour les pédophiles et les terroristes ? Toujours le même bingo. Sans parler que cela ne saura d'aucun intérêt puisque cela poussera les pédophiles vers des services / systèmes chiffrés de toute part et encore plus impénétrable.

> Je suis à fond pour la surveillance de tout ce qui a trait à la surveillance de la pédopornographie

Moi je suis à fond pour la surveillance des mouvements terroristes (qui peut être contre ?)

Et aussi pour la surveillance de l'écoterrorisme. La destruction de plantes OGM nous a privé d'avancées considérables dans le domaine de plantes résistantes aux conditions extrêmes que l'avenir nous prépare.

Je demande donc à ce qu'un système soit installé sur tous les smartphones pour empêcher les actions coordonnées des faucheurs volontaires.

Et idem pour la contrefaçon de musique et/ou de films qui enrichit le terrorisme.

Et la consommation de cannabis qui entretient la délinquance

Et il y a encore plein d'autres trucs pour lesquels je suis pour (ou contre) et qui devraient faire l'objet d'une surveillance h24

@v1nce29

« Et idem pour la contrefaçon de musique et/ou de films qui enrichit le terrorisme.

Et la consommation de cannabis qui entretient la délinquance

Et il y a encore plein d'autres trucs pour lesquels je suis pour (ou contre) et qui devraient faire l'objet d'une surveillance h24 »

Pour ceux qui pissent à côté des chiottes, aussi.

Je trouve ça carrément inquiétant. J’espère qu’ils feront marche arrière.

Et comme relevé également, ça montre qu'Apple, contrairement à ce qu'ils affirment régulièrement, dispose d'une clé de déchiffrement, a minima pour les photos stockées sur iCloud (pour pouvoir les analyser). Qu'en est-il de nos autres données?

@r e m y

+ 1 !!!

C’est quand même la plus mauvaise pub qu’ils pouvaient se faire. Comment se tirer une balle dans le pied… 🤦🏻

Effectivement c’est très inquiétant. Ça commence par être mis en place pour lutter contre la pedophilie, l’an prochain ça sera contre le terrorisme, dans 3 ans contre les armes à feu, et dans 10 ans contre « la désinformation et les fake news »…

@apple78310

oui et c'est plutot bien…

maintenant que n'import equi peut offrir à la planete n'importe quoi sous les yeux de tous, un systeme qui bloque cela en amont est le bienvenue.

oui et c'est plutot bien…

Oui et quand tu te retrouveras en prison parce que tu as scanné un QRCode qui a déclenché un téléchargement sur ton smartphone de photos illégales, on en reparlera ;)

@raoolito

Stopper les réseaux sociaux ne serait pas plus normal dans ce cas là ???

On croit rêver en lisant tes propos.

Parce qu’on peut dire ce qu’on veut sur Facebook ou Twitter, il faut maintenant surveiller tout le monde ???

On attaque le mal par la racine normalement, non ?

@David Finder

si seulement c'etait possible...

mais l'ere de la surinformation et de la sur communication est là et un retour en arrière est illusoire

"oui et c'est plutot bien…"

Le gouvernement chinois est d'accord avec toi. D'ailleurs vous êtes d'accord que toutes les photos de Tiananmen sont des fake news ? De même, les livres avec le mot "Démocratie" sont également de la désinformation ? Hop on bloque et on signale ces méchants terroristes.

Ça commence par être mis en place pour lutter contre la pedophilie, l’an prochain ça sera contre le terrorisme, dans 3 ans contre les armes à feu, et dans 10 ans contre « la désinformation et les fake news »…

Pff n'importe quoi, contre les armes à feu c'est juste impossible. Par contre, un nichon ça oui ;)

Je présume que les gens du marketing d’Apple ont prévenu Tim Cook que cette mesure allait ruiner des années du discours d’Apple sur le respect de la vie privée.

Pour ceux qui ne lisent pas jusqu’au bout : "

Sebastien Marineau-Mes, le vice-président en charge des logiciels, a diffusé un mémo annonçant des explications plus précises à venir afin d'éviter les quiproquos."

Pas d’emballement pour rien. Attendons

@tequilapafff

Bonne réponse ! Où comment polémiquer sur un sujet dont on ne sait encore rien, ni comment il fonctionne…

Ceux qui saluent la méthode sont probablement les mêmes qui encensent le pass sanitaire. Le monde post 2020 ne va décidément pas être beau à voir. Vos enfants et petits-enfants vous en seront éternellement reconnaissants.

Le passe sanitaire c'est temporaire et le conseil constitutionnel a rappelé que la mesure devrait être supprimée dés l'amélioration de la situation sanitaire.

@bibi81

" le conseil constitutionnel a rappelé que la mesure devrait être supprimée dés l'amélioration de la situation sanitaire. "

Ce qui n’arrivera pas demain, et en attendant c’est open bar.

@san_

« Ceux qui saluent la méthode sont probablement les mêmes qui encensent le pass sanitaire. »

J’encense le pass sanitaire et ne n’approuve pas du tout ce que nous propose Apple….

Étonnant les réactions tout de même…

Que ce soit chez apple, google ou autre, quand on tape dans la recherche de photo, « chaise », « table », « piscine », « chat »… on trouve ça bien pratique de retrouver ses photos, parfaitement indexées et donc analysées… on trouve aussi super pratique la reconnaissance des visages pour retrouver les photos de mémé dans le Périgord… là, ça ne gêne personne tant c’est pratique.

Mais quand il s’agit de lutter contre la pédopornographie, « ça va trop loin », « on se croirait dans 1984 »…

Qu’on me comprenne bien, personnellement je suis pour une réflexion approfondie de la question, poser calmement le pour et le contre.

Je suis juste toujours surpris des réactions à chaud des gens…

@kemar4

> Que ce soit chez apple, google ou autre

Chez Apple contrairement aux autres, cette analyse se fait en local sur le téléphone et les résultats restent sur le téléphone. Ce qui ne pose aucun problème de vie privée. Ici l'analyse se fera toujours sur le téléphone mais les éventuels résultats partiront directement chez Apple / les flics.

Tu peux me répondre que c'est moins pire que chez Google ... difficile à dire, sauf que si je voulais me farcir le viol de vie privée de Google, je paierai mon smartphone deux fois moins cher.

J'ajouterai que chez Apple ça ne se fait pas uniquement en local car ils analysent également les photos stockées sur iCloud.

Et d'autre part, quand l'algorithme, en local, a cru détecter un certain nombre de photos douteuses, ces photos sont transmises à un opérateur chez Apple pour confirmer, ou pas, le caractère "criminel" des photos.

@pocketjpaul

Je ne me focalise pas sur le monde Apple.

Je me pose simplement la question, sans encore m’être vraiment fait un avis, de savoir si ça ne vaut pas le coup de sauver des enfants si le système est fiable…

J’évite simplement de crier au loup quand on en voit pas encore la queue… la tendance actuelle est plutôt à se méfier de tout sans avoir toute les informations..

@kemar4

Je vois pas en quoi ca peut « sauver des enfants ».

Que des types s’excitent devant des photos d’enfants c’est triste mais est ce le prélude à un passage à l’acte ?

Si le pervers devient prudent avec ses photos est ce que pour autant ca réduit la probabilité d’une agression ?

Pour sauver des enfants il faut des parents ou tuteurs informés et une relation de confiance avec l’enfant qui doit pouvoir se confier.

Apple ne fait que balayer devant sa porte en envoyant la merde ailleurs, et tenter une operation seduction aupres de parents qui sont les premiers prescripteurs de smartphones pour leurs enfants.

@kemar4

Installer des caméras dans toutes les chambres à coucher du pays pourrait sans doute aussi éviter des maltraitances et « sauver des enfants ». Donc on le fait ?

C’est sidérant de trouver normal que les fabricants décident de ce qui est bien ou mal, hors de tout contrôle des institutions nationales, et décrètent qu’elles pourront accéder à distance à des données qui ne leur appartiennent pas sur les appareils qu’ils ont vendu, quelle qu’en soit la raison.

@dexter

Pourquoi déformer les propos des autres ?

Voilà pourquoi je ne commente quasiment jamais…

@kemar4

Cela fait des années que les fabricants et fournisseurs de services ont pris l’habitude de collecter nos données via leurs produits. D’abord nos données techniques pour améliorer leurs produits, puis les métadonnées liées à nos échanges, à ce qu’on fait avec (pour les monétiser en échange de la gratuité du service), mais avec un objectif commercial assez simple à comprendre.

Ces pratiques font déjà l’objet de nombre de polémiques, d’ailleurs.

Ici il me semble qu’on est en train de franchir un nouveau cap. Indépendamment de la mission d’entreprise privée, on annonce unilatéralement de nouvelles collectes de données pour réguler des comportements immoraux. Donc sans lien avec la mission d’une entreprise privée.

Mon exemple était volontairement extrême pour illustrer ce phénomène avec une situation qu’on considère tous comme relevant de sa vie privée. Il n’était pas censé refléter directement ton propos mais plus les dérives à venir. Je suis désolé s’il a été perçu comme tel.

Autre exemple : qu’en penserait-on si Apple prenait, de sa propre initiative, la décision de calculer les vitesses de déplacement de ses utilisateurs d’iPhone via le mouvement de leur trace GPS et prenne l’initiative de signaler les conducteurs en excès de vitesse à une association de sécurité routière et pourquoi pas les ponctionner directement de 1000 euros d’amende sur la carte bancaire renseignée sur leur compte Apple ID ?

Pages