Photos, Messages : Apple dévoile de nouveaux mécanismes pour lutter contre la pédopornographie

Après les rumeurs, on s'attendait à une annonce en bonne et due forme et c'est chose faite ce soir : Apple va bel et bien intégrer dans l'iPhone une technologie de détection d'images pédopornographiques qui va scanner les images à même l'appareil… Mais c'est un peu plus compliqué que cela, et ce n'est pas le seul mécanisme de sécurité dédié à la protection de l'enfance que le constructeur présente sur ce nouveau site.

Il y a en fait trois mesures qui vont être mises en place plus tard cette année, qui vont se limiter aux États-Unis pour le moment. Apple fournit un livre blanc technique sur l'ensemble de ces mesures.

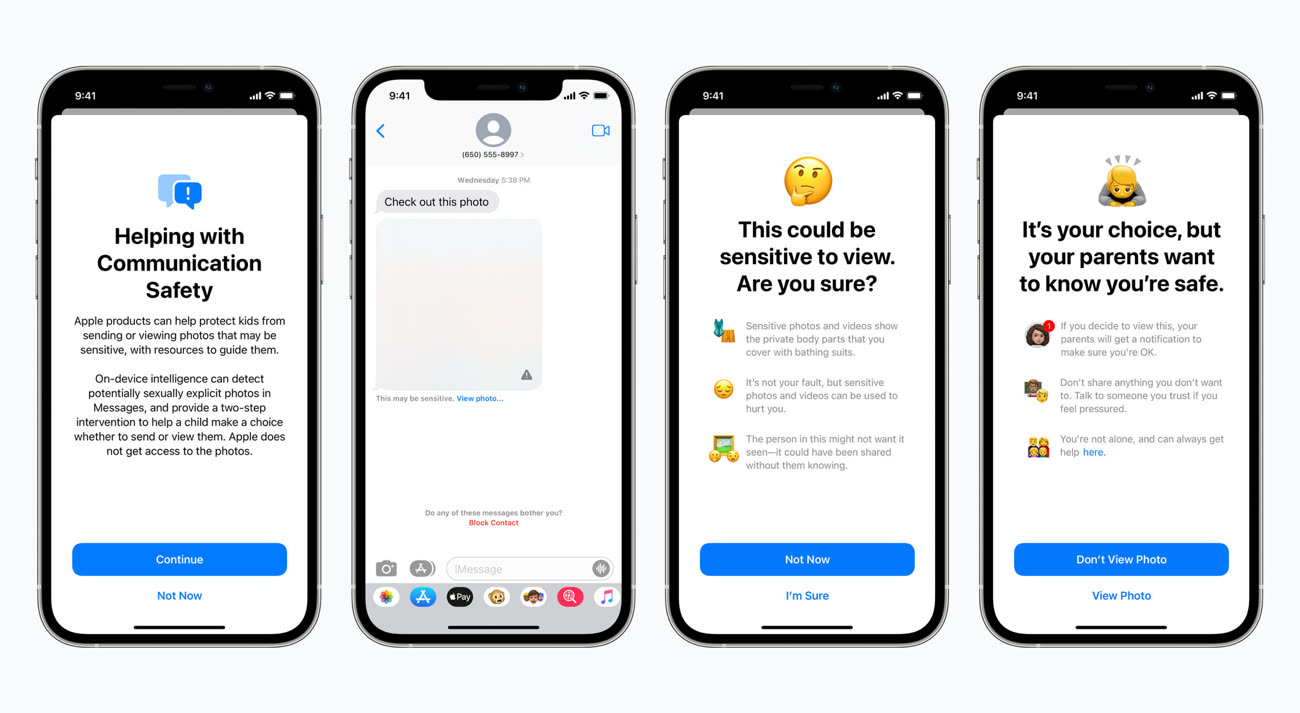

L'application Messages va bénéficier de nouveaux outils qui vont prévenir l'enfant utilisateur que tel contenu partagé est potentiellement sensible (on peut penser à des photos sexuellement explicites envoyées par des prédateurs). À la réception de telles images, elles seront floutées et l'enfant recevra une alerte sur la nature litigieuse du message.

Si l'utilisateur mineur décide tout de même de visualiser l'image, les parents pourront recevoir une notification. Idem lorsque le mineur décide de partager une photo intime. Les notifications parentales sont optionnelles pour les enfants de moins de 13 ans, et pas disponibles pour les enfants âgés entre 13 et 17 ans. Messages s'appuie sur un traitement d'apprentissage automatique réalisé à même l'appareil pour analyser l'image et déterminer s'il s'agit d'un contenu sexuellement explicite. Bien sûr, Apple n'a pas accès aux messages.

Cette fonction sera disponible dans iOS 15, iPadOS 15 et macOS Monterey, pour les comptes Apple configurés en partage familial.

Un Genius à la maison : comment bien gérer le partage familial

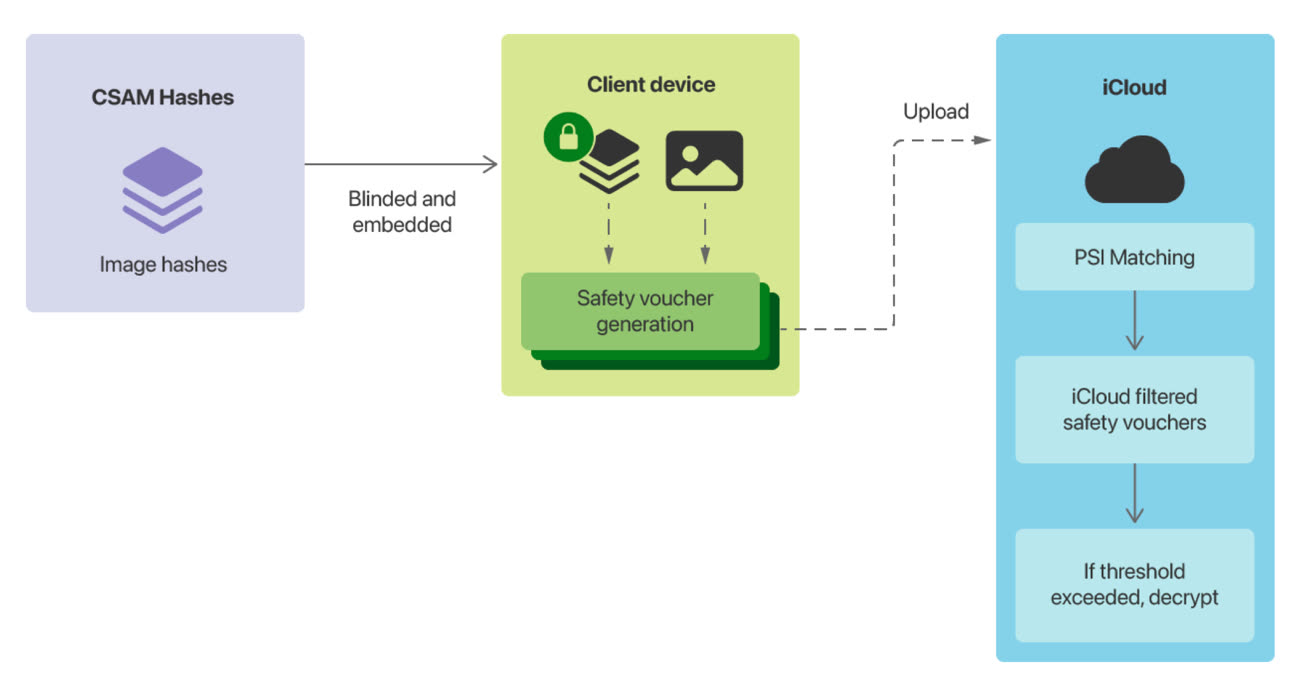

La technologie de détection d'images pédophiles (CSAM pour Child Sexual Abuse Material) fera son apparition dans iOS et iPadOS. Elle permettra à l'appareil d'examiner les images stockées dans la bibliothèque photos, et en cas de détection de cas d'abus sexuels sur des enfants, Apple sera en mesure d'alerter le National Center for Missing and Exploited Children (NCMEC), une organisation qui travaille avec les forces de l'ordre américaines.

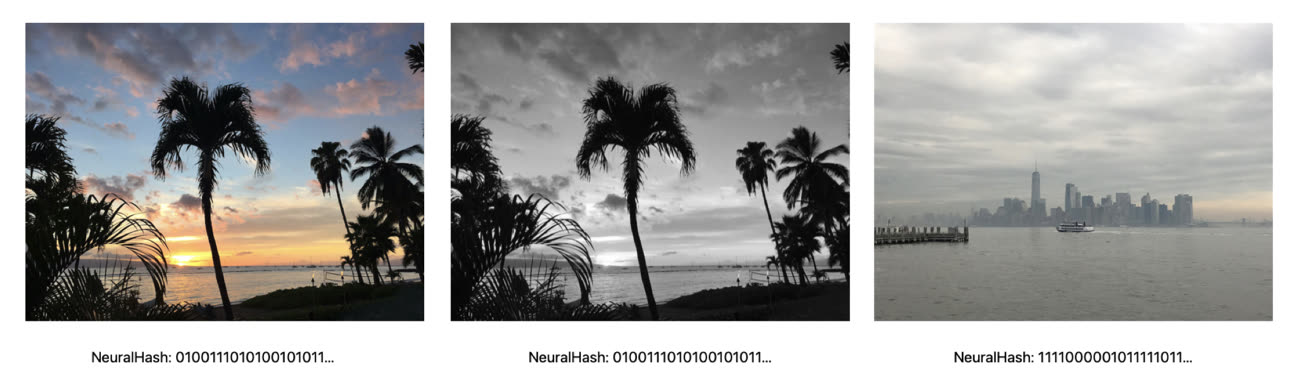

Cette technologie baptisée NeuralHash (et non pas NeuralMatch comme les indiscrétions l'ont annoncé tout à l'heure) analyse l'image et la convertit en une suite de chiffres. Les images en question peuvent être recadrées ou éditées, cela n'affectera pas le NeuralHash.

Avant qu'une image ne soit téléversée dans la bibliothèque iCloud, la méthode fait correspondre ces numéros avec ceux d'une base de données du NCMEC et d'autres groupes de défense des enfants. Apple transformera cette base de données en un ensemble de hashes qui sera stocké de manière sécurisée sur les appareils.

En cas de correspondance, l'appareil génère un jeton cryptographique et un « dérivé visuel » qui sont téléversés dans la bibliothèque iCloud Photos, en même temps que l'image. Une fois qu'un seuil (non révélé) de correspondances est dépassé, Apple s'empare des jetons et examine manuellement chaque rapport pour constater la correspondance, ou pas. Le compte iCloud est ensuite désactivé, et un rapport est envoyé au NCMEC qui prendra les mesures qui s'imposent.

Apple garantit un niveau « extrêmement élevé » de vigilance afin que les comptes ne soient pas signalés de manière incorrecte. Il va falloir faire confiance au constructeur sur ce coup là. Il donne plusieurs avantages à son système : cela lui permet d'identifier des images pédophiles stockées dans des bibliothèque iCloud Photos, tout en protégeant la vie privée de l'utilisateur.

Apple n'apprend l'existence des photos des utilisateurs que lorsqu'une collection de photos correspondantes à la base de données est présente dans un compte iCloud. Et même dans ce cas, Apple n'a accès qu'à ces images, pas aux autres qui ne correspondent pas.

Le constructeur ajoute que la base de données est invisible aux yeux de l'utilisateur, le système se veut « très précis » avec un taux très faible d'erreur, et plus respectueux de la confidentialité que le scan des photos sur les serveurs, bien que le constructeur ait admis utiliser ce type de technologie l'an dernier :

La lutte contre la pédophilie se mène aussi sur iCloud

On comprend donc que si le traitement de la correspondance entre la base de données et les photos de l'utilisateur se réalise à même l'appareil, il faut tout de même que les images soient téléversées dans le nuage d'iCloud afin qu'Apple puisse prévenir les autorités. La Pomme a confirmé que si iCloud Photos était désactivé sur l'appareil, il ne sera pas possible de détecter des images qui correspondent à la base de données CSAM.

À des degrés divers, d'autres entreprises scannent les images de leurs utilisateurs comme Twitter, Microsoft, Facebook et Google.

And if you’re wondering whether Google scans images for child abuse imagery, I answered that in the story I wrote eight years ago: it’s been doing that **SINCE 2008**. Maybe all sit down and put your hats back on. pic.twitter.com/ruJ4Z8SceY

— Charles Arthur (@charlesarthur) August 5, 2021

Dernier volet de cet ensemble de mesures de protection, Siri et les fonctions de recherche d'iOS/iPadOS 15, de watchOS 8 et de macOS Monterey vont proposer des liens pour rapporter des cas d'exploitation sexuelle de mineurs, au cas où l'utilisateur le demanderait.

@Rogntudju

Je vais faire une citation hautement intellectuelle 🤣🤣 (ça va rhooo c’est jeudi soir presque minuit lol! :

Comme l’a dit le président Benson (dans l’excellent film HOT SHOT 2) : la solution simple paraît parfois a certain un peu simpliste ^^

@MickaelBazoge

Ah mais l’article 9to5mac précise que la détection à l’envoi n’est activée que pour les moins de 13 ans, ce qui me semble un bon compromis pour le moment.

Dans l’autre sens, le fait de recevoir une photo nude/porno avec un floutage, une explication voire plus ne alerte pour les parents (j’imagine si moins de 13 ans aussi ?), là c’est une protection pertinente aussi. Même si effectivement aucun jeune ne laisse son numéro de téléphone dans l’annuaire et que c’est plus sur Instagram, TikTok et SnapChat qu’il y a un risque…

@Lu Canneberges

Merci pour cet avis argumenté qui évite de tomber dans le manichéisme des commentaires habituels…

@Silverscreen

Je vous en prie, merci à vous 🙏

@MickaelBazoge

Parfait alors !

@Lu Canneberges

« Ayant été victime de pédocriminalité je ne peux qu’applaudir. »

Eh bien moi, je ne peux qu’être consterné.

@Lu Canneberges

Je suis moyennement d’accord, dans le sens où les états qui veulent persécuter des populations spécifiques ont déjà bien mieux comme moyens. Toutefois, il faut effectivement que ça ne vienne pas renforcer ce qui est déjà présent. C’est indéniable. Pour le moment ce n’est pas le cas, évitons de brûler les pousses pour éviter qu’une branche de l’arbre gêne ;-)

Suspect les fan boys qui pointeront sur Android si jour au lendemain...

Non mais qu’on m’explique la… ça veut dire que si potentiellement ma copine majeure m’envoie quelque chose, ça peut se retrouver entre les mains d’une équipe Apple??

@Ralph_

Oui, mais c’est pour votre bien ! 😉

@Ralph_

Non.

Les photos sont Hashees, et le code issu de ce hashage va être comparé au hashage de photo pedo connue des autorités américaines.

Au bout de X matchs, Apple prévient les autorités.

Mais en aucun cas ils n’auront accès à tes photos privées.

(C’est très bien expliqué dans l’article d’ailleurs. Il suffit de lire :) )

Non, sauf en cas de bug. Les photos ne sont envoyées chez Apple que si leur signature match avec une du CSAM.

Actuellement ce ne sera pas actif hors US (sauf en cas de bug).

@lmouillart

Ben justement, le bug existe.

Qu’est ce qui te dit qu’un sein bien adulte ne sera pas confondu avec un sein d’une mineure 🤨

A partir de là signalement, la photo sera vue, et ensuite classé sans suite. Mais entre temps, la vie privée et l’intimité d’une personne aura été vue sans son consentement.

@Ralph_

Non. Tu n’as pas compris

Il faut que tu aies l’une des photos incriminée (signalée donc) pour que le match se fasse.

Ce n’est pas le contenu de la photo qui est analysé. C’est la photo elle même.

Il faut que la photo soit précisément celle qui se trouve dans la base de données pour qu’il y ai un match.

Donc a priori à part si la photo de ta compagne a été signalée comme une photo pedi pornographique, il n’y a pas de risque pour toi :)

@Ralph_

ça marche pas comme ça :

1- la photo est comparée à une base de données de photos déjà recensées et tirées de bases de données utillisées par des cercles pédocriminels. La photo de ma fille à la plage ou de ma femme topless avec son 80A ne sont pas concernées

2- Ils faut plusieurs matches donc plusieurs photos identiques à celles présentes dans la base de données criminelle pour que les photos concernées soient signalées à Apple.

@Ralph_

Si elle est petite (ratio tronc/tête par exemple), si elle n’a pas de système pileux apparent ( désolé j’ai essayé de le dire de la façon la moins grivoise possible, n’y voyez aucun manque de respect ), si comme madame romainB84 elle a « une tête de gamine », et si elle a une silhouette juvénile, alors oui, il y a des chances qu’une photo dénudée d’elle finisse dans la file d’attente « à faire verifier par un humain ».

@f3nr1l

Non aucune chance. Cf mon explication ci dessus :)

@Ralph_

Arrêtez de paniquer sans lire. C’est uniquement si vos photos correspondent à une base de donnée reconnue contenant exclusivement de la pédopornographie criminelle. Donc rien à craindre pour les photos de famille.

Mais si au passage on arrivait à apprendre aux parents d’arrêter de publier des photos de leurs enfants sur les réseaux sociaux sans leur consentement, ça ne serait pas plus mal !

@Lu Canneberges

« Mais si au passage on arrivait à apprendre aux parents d’arrêter de publier des photos de leurs enfants sur les réseaux sociaux sans leur consentement, ça ne serait pas plus mal ! »

J’ai récemment vu une vidéo du Roi des Rats sur YouTube parlant de TikTok et de qu’on y trouvait. Les enfants ne semblent même plus avoir besoin des parents pour diffuser leur photos et vidéos…. Y a du ménage à faire et j’ai pas l’impression que ça bouge beaucoup.

@Ralph_

Non.

Pour faire court, Apple va mettre un logiciel espion dans les appareils qu’il nous vend.

c'est déjà le cas. ils analysent tout depuis toujours, mais maintenant ils rendent service aux gouvernements, pour devenir indispensables. en plus c'est logique, qui ne veut garantir son business ?

C’est surtout sur Snapchat que ce genre de chose devrait être fait. Sur iMessage ça voudrait dire que les numéros de téléphone ont déjà été échangé. Et donc soit il y a eu une rencontre physique soit ça a été fait via un RS et dans ce cas, pourquoi vouloir aller sur iMessages ? Je comprends pas trop le principe.

De plus le scannage de la bibliothèque de photos meme si c’est fait en interne c’est pas terrible. Je donne l’exemple. Ma sœur m’envoie des photos/vidéo de mon neveu dans sa douche en train jouer. Forcément il n’est pas en maillot de bain. Du coup comment c’est vue aux yeux d’Apple ça ?

@hervemac

+1 pour Snapchat.

Mais arrêtez de partir sur vos photos de famille. C’est uniquement si vos photos correspondent à une base de donnée reconnue contenant exclusivement de la pédopornographie criminelle. Donc rien à craindre pour les photos de famille.

Mais si au passage on arrivait à apprendre aux parents d’arrêter de publier des photos de leurs enfants sur les réseaux sociaux sans leur consentement, ça ne serait pas plus mal !

@Lu Canneberges

« Mais arrêtez de partir sur vos photos de famille. C’est uniquement si vos photos correspondent à une base de donnée reconnue contenant exclusivement de la pédopornographie criminelle »

C’est quoi la pédopornographie non criminelle du coup ? :-)

Bon dans l’article initial j’ai cru comprendre que le système était capable d’extrapoler sur des images qu’il n’avait jamais « vu » (c’est d’ailleurs l’utilité de l’AI : reconnaître des choses non apprises). La question du gamin dans le bain me semble une question légitime même si Apple assure que son système est très fiable.

@Chris K

Il y a 2 choses différentes et distinctes (mais annoncées en même temps)

L’analyse des photos iMessage pour les mineur ou là effectivement c’est le contenu de la photo qui sera analysé mais uniquement afin de prévenir le mineur / ses parents qu’il est sur le point de voir une photo éventuellement sensible. La tout se passe sur le device, pas d’intervention humaine

L’autre analyse est celle des photos iCloud qui hashe les photos sans analyser leur contenu afin de les comparer à la base de donnés des photos connues comme étant illégales qui la déclencherait l’alerte vers les autorités compétentes.

Donc pour les photos de famille, pas de risque de faux positif

@Nico_Belgium

« L’autre analyse est celle des photos iCloud qui hashe les photos sans analyser leur contenu afin de les comparer à la base de donnés des photos connues comme étant illégales qui la déclencherait l’alerte vers les autorités compétentes.

Donc pour les photos de famille, pas de risque de faux positif »

Effectivement, j’ai relu le livre blanc, et il semblerait que l’AI se contente de trouver des similitudes par rapport à une image de base. Grosso modo. L’analyse détecterait comme positif des images modifiées (en taille, couleur et que sais-je) à partir d’une image originale.

@Chris K

Il est régulièrement question du fait que le système ne s’active que si tu as un certain nombre d’images problématiques, et il serait plutôt trop précis que pas assez.

Mais il faut aussi se demander si s’envoyer via internet des photos de nos enfants dénudés est une bonne idée ! Tout comme on a une génération qui grandit avec des photos intimes publiées sans vergogne pr leurs parents, si un jour le téléphone est volé ou piraté et qu’on y retrouve des photos utiles à du chantage ou du harcèlement, y avoir pensé avant pourrait éviter bien des tracas…!

@Lu Canneberges

« Mais il faut aussi se demander si s’envoyer via internet des photos de nos enfants dénudés est une bonne idée ! »

Sauf si j’ai mal compris, dans le cas qui nous intéresse pas besoin d’envoyer les photos de familles. Il suffit que la (ou les) photo(s) que tu as prise(s) pour toi seul en souvenir se télécharge(nt) dans iCloud.

@hervemac

« De plus le scannage de la bibliothèque de photos meme si c’est fait en interne c’est pas terrible. Je donne l’exemple. Ma sœur m’envoie des photos/vidéo de mon neveu dans sa douche en train jouer. Forcément il n’est pas en maillot de bain. Du coup comment c’est vue aux yeux d’Apple ça ? »

Apple semble dire que leur système est très fiable. On peut penser que le genre de situation que tu décris ait été « prévu » ou du moins testé.

J’imagine mal Apple devoir traiter manuellement des millions de photos où des familles prennent leur bambin en photos pendant le bain.

En généralisant, j’imagine que les pervers prenant en photo des enfants sur une plage ou ailleurs passeront au travers des mailles du filet. Quoique… l’intelligence artificielle donne parfois de surprenants résultats.

les photos sont comparées avec ce qui se trouvent dans une base de données que la police possède. donc c'est impossible qu'une photo de toi existerait chez eux. sauf au cas où tu disposes la même. et puis les photos de ce genre sont explicites. sont des photos fait exprès. comme les habits d'une nana qui vend son corps quoi, on peut pas le confondre avec une étudiante. ça se voit clairement. après si des ressemblances t'auras besoin d'un avocat je pense.

J’ai peur de ne pas comprendre.

Apple ne voit pas les images mais juste un hash qui lui même est comparé. Mais si ce porc prend lui même des photos de gamins, le hash est donc inexistant dans la base non ? Dans ce cas, ils ne s’échangeront que des exclus. Ça doit être plus complexe que ça, c’est pas possible.

Et si je prends en photo mon petit dans son bain et qu’on voit son petit bout, ça se passe comment ?

Quand on voit ou on va avec le pass vaccinal parce que « c’est pour votre bien » on est en train d’ouvrir la boîte de Pandore…

Et demain c’est quoi la prochaine étape?

La lecture des conversations de messageries privées pour lutter contre le terrorisme? Wait…

@piepie38

Il y a déjà un article là dessus que Mac G a fait

Remplacer automatiquement les insultes et gros mots pas des emoji "beep" ou "tuut"

Etape 1 : Pour une très bonne cause, flicage généralisé à cause de quelques dégénérés… et d’autres dégénérés applaudissent sans aucune restriction…

Etape 2 : quelques demeurés se font choper, mais la plupart des salopards pédophiles prennent leurs dispositions pour passer à travers les mailles du filet. sans doute pas si cons, hélas.

Etape 3 : le flicage ne sert plus pour la cause initiale, mais la technologie est éprouvée grandeur nature sous les applaudissements béats, et peut servir à fliquer pour des motifs moins acceptables.

CQFD, sous vos applaudissements…

@Rogntudju

j’aurais pas mieux résumé

ça fait longtemps que Photos détecte les objets. tu peux l'essayer. cherche bibliothèque ou livres ou voiture, ou montagne, enfants, etc. sur le récent système en beta même le texte est reconnu.

@Rogntudju

Merci 🙏🏽

Dans un commentaire sur un autre article, j'avais proposé de rendre illégal les appareils photos pour lutter contre la pédo pornographie... mais quelqu'un a trouvé un moyen encore plus radical... supprimons les enfants!

@Nico_Belgium et @mouillard:

Je pense que dans NeuralHash, Neural est ce qui importe le plus, autrement dit, l’algo va plutot déterminer que « ca c’est une ´stouquette », « ça c’est un chtite nenfant » plutot que « c’est la même photo que pedolist8475838.jpg, mise a l’envers et tournée de 5 degrés »

Les reseaux neuronaux doivent avoir été entrainés avec pleiiiin de photos d’enfants « vas y, apprends, voici a quoi ressemble un gosse », pleiiiin de photos de pr0n « ça c’est des adultes qui font du saikse. C’est bien cette activité qu’on cherche, mais tant que tout le monde a poilches ou mesure plus de (5?, 4?) têtes, laisse passer), et enfin la partie la plus éprouvante, je plains les personnes qui s’y collent, « ça ce sont les pièces à conviction de la brigade de protection des mineurs des dix dernières années. C’est ce genre de scène qui doit t’alerter »

Enfin c’est de cette façon que j’imagine la chose, avec mon petit cerveau tortueux.

Perce que si on se base sur de simples hash, genre sha256, md5sum, etc… tout ce qui ne figure pas deja dans la liste passe a travers les mailles.

@f3nr1l

Non. En tout cas ce n’est absolument pas comme ça que Apple l’a expliqué :)

Le Neural vient du fait qu’ils sont capable de détecter également si la photo est retouchée (si la colorimetrie a été altérée, si on a rajouté des petites étoiles dessus par exemple, etc..)

Donc il y a de l’intelligence artificielle oui mais toujours dans le but de détecter les photos signalées.

Et oui, les photos non signalées passeront donc entre les mailles du filet. Mais en même temps utiliser ton système générerait beaucoup trop de faux positifs.

@Nico_Belgium

To help address this, new technology in iOS and iPadOS will allow Apple to detect known CSAM images stored in iCloud Photos.

Tu as raison, il s’agit pour le moment de detecter des photos CONNUES.

Mais, quand on lit a travers les lignes,

The Messages app will add new tools to warn children and their parents when receiving or sending sexually explicit photos.

When receiving this type of content, the photo will be blurred and the child will be warned…

…

Similar protections are available if a child attempts to send sexually explicit photos. The child will be warned before the photo is sent, and the parents can receive a message if the child chooses to send it.

…

Messages uses on-device machine learning to analyze image attachments and determine if a photo is sexually explicit.*

on se rend compte que les outils permettant de detecter de NOUVELLES photos existent deja, même si ça n’est appliqué qu’aux utilisteurs mineurs.

Ca ne durera pas, le système actuel de détection d’anciennes photos pédoporno ne suffit pas. Il est « defective by design ».

Et cela se comprend, Apple ne peut pas introduire un système d’analyse de vos photos sans provoquer une levée de boucliers. Par contre, si ce sont des associations de parents (ultra puissantes aux USA) qui l’exigent, qui clament qu’apple ne s’investit pas suffisamment dans la lutte contre la pedocriminalité, alors ça passera comme une lettre à la poste.

@f3nr1l

Sauf que ce système peut identifier des photos sexuellement explicites. De tout type donc (pas seulement pedo-pornographique. Une photo un peu sexy de ma compagne serait également détectée par ce système. Mais vu que je suis majeur et elle aussi ça ne déclencherait rien sur nos appareils).

On ne peut pas interdire aux gens d’avoir des photos sexuelles sur leur téléphone. Jusqu’à preuve du contraire ce n’est pas illégal.

Et comment est ce que Apple pourrait faire la différence entre la photo de mon petit neveux à poil sur la plage à 3 ans avec une photo pedo ?

Le ML a ses limites ;-)

@Nico_Belgium

"On ne peut pas interdire aux gens d’avoir des photos sexuelles sur leur téléphone. Jusqu’à preuve du contraire ce n’est pas illégal. "

Ce ce sont des photos potentiellement pedophile, si, c’est illégale. Que ce soit de ra famille ne compte pas.

@gwen

Sauf que comme je l’ai expliqué, leur système avec iMessage ne se limite pas aux photos pedo mais à tout type de photo sexuelle

Ici je ne fait qu’expliquer pourquoi je ne pense pas qu’apple étendra le système pour prévenir les autorités a l’apparition de nouvelles photos qui pourraient être problématiques.

Cela générerait trop de faux positifs à mon sens. Et chaque faux positif pourrait être a priori problématique en cas de vérification manuelle niveau vie privée.

Cela étant mes parents ont pris des photos de moi nu quand j’étais tout petit dans certaines situations ( sur la plage ou à un camping) et ce ne sont pas de terribles pedo-criminels pour autant.. ce sont juste des tranches de vies prisent à un moment T.

Et on a tous eu droit à ce genre de photos…

Si j’ai bien compris, il y a une base de données énorme de photos pédo-pornographiques stockées dans des serveurs quelque part aux US.

J’espère que le truc est bien protégé parce que c’est un peu glauque rien que d’y penser.

@Tao

"Si j’ai bien compris, il y a une base de données énorme de photos pédo-pornographiques stockées dans des serveurs quelque part aux US.

J’espère que le truc est bien protégé parce que c’est un peu glauque rien que d’y penser."

Tu peux aussi, aux US, checker si ton voisin est un predateur sexuel, tout est public:

https://www.nsopw.gov/

Apres tu peux etre sexual offender si t’as pissé 2 fois en public et que tu t’es fait choper 😅

Pages