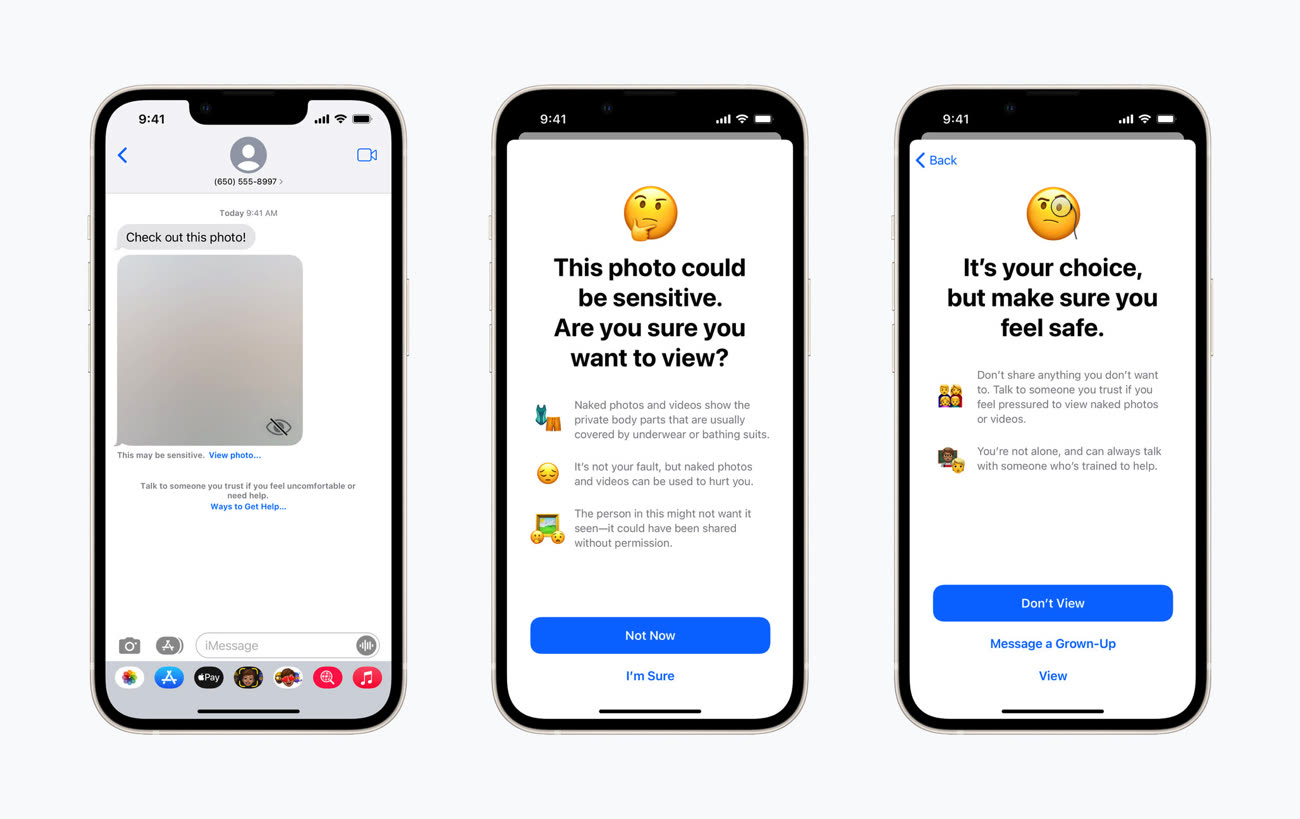

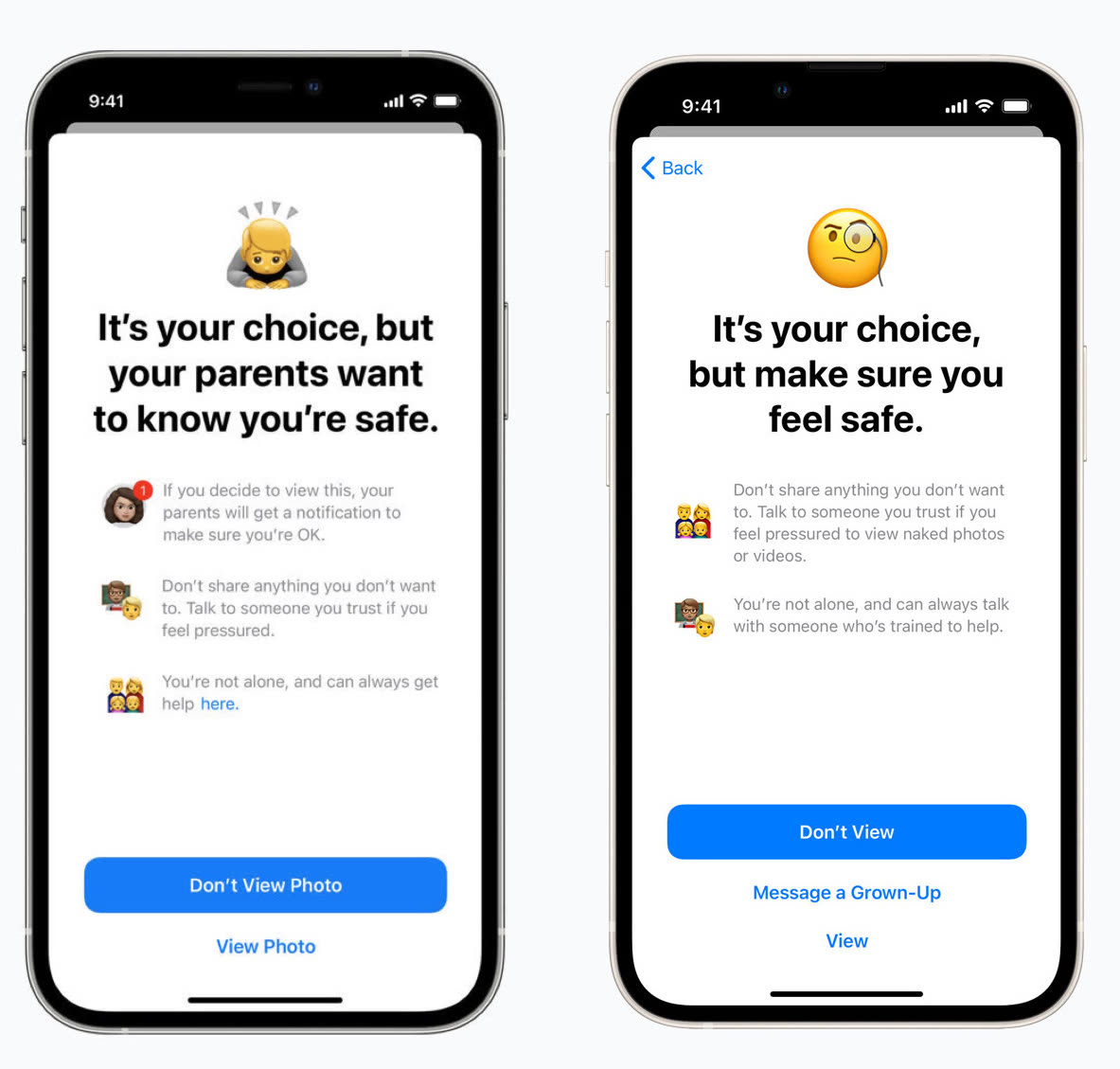

Apple va bientôt déployer sur iOS au Royaume-Uni, au Canada, en Nouvelle-Zélande et en Australie deux fonctionnalités de protection de l'enfance déjà disponibles aux États-Unis. Dans les familles où le partage familial est configuré, les parents pourront activer une analyse des photos reçues par leur enfant dans l'app Messages.

Si cette analyse réalisée en local détermine qu'il y a des photos sexuellement explicites, celles-ci seront automatiquement floutées et l'enfant sera prévenu que ces images risquent de heurter sa sensibilité et qu'il n'est pas obligé de les regarder. De la même manière, si c'est l'enfant qui envoie des photos de lui nu, un message lui demandera de réfléchir à deux fois avant de partager ce contenu sensible.

Contrairement à ce qu'Apple avait prévu en premier lieu pour les enfants de moins de 12 ans, si le pitchoune décide malgré tout de voir ou d'envoyer une photo à caractère sexuel, les parents ne recevront pas de notification les prévenant du message.

Tous les utilisateurs des quatre pays anglophones cités ci-dessus trouveront également plus d'informations sur la protection de l'enfance via Siri, Spotlight et le moteur de recherche de Safari.

Au Canada, le responsable du compte familial iCloud peut désormais activer le réglage Sécurité des communications > Rechercher des photos sensibles dans les options de Temps d'écran. Il est aussi possible de consulter les ressources liées à la sécurité des enfants, qui sont ici fournies par des associations canadiennes. À l'heure actuelle cependant, si l'option est bien visible, les photos dénudées ne sont pas encore floutées. La fiche d'assistance, pas encore traduite en français, est disponible à cette adresse.

La fonction de détection d'images pédopornographiques dans la bibliothèque iCloud des utilisateurs qui avait fait polémique est toujours reportée sine die.

Mise à jour : ajout de la Nouvelle-Zélande et de l'Australie à la liste des pays ayant les nouvelles fonctions.

Source :