L’apprentissage automatique est peut-être un concept un peu abstrait, mais ses applications sont très concrètes. On en a la preuve tous les jours dans l’app Photos par exemple, et bien sûr Apple n’est pas la seule entreprise à exploiter les possibilités de l’intelligence artificielle.

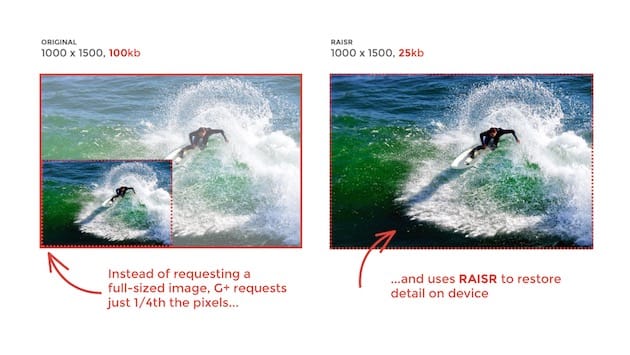

Google est aussi sur le coup, avec notamment RAISR (pour « Rapide and Accurate Image Super-Resolution »). Cette technologie dévoilée en novembre dernier permet d’améliorer des images peu définies avec des résultats étonnants (lire : Google crée des versions haute définition d'images grâce au machine learning).

La première utilisation pratique de RAISR a commencé à apparaître… sur Google+, et pour une poignée de smartphones Android. Le moteur de recherche prend donc ses précautions avec un déploiement mesuré de sa technologie. Une sorte de test grandeur nature, mais si les résultats sont convaincants, alors RAISR est susceptible de réduire l’usage de données cellulaires et de bande passante.

Le principe est simple : Google+ ne charge pas l’image au complet, mais uniquement le quart des pixels qui la compose. Charge ensuite à RAISR de « reconstituer » les 75% restants. Une image de 100 Ko ne pèse plus que 25 Ko… De quoi limiter effectivement la bande passante nécessaire à l’affichage de photos.

Google traite plus d’un milliard d’images par semaine, réduisant ainsi l’accès aux données d’un tiers pour les utilisateurs qui en profitent. Le moteur de recherche va étendre cette technologie plus largement dans les prochaines semaines.